一等一的頂會CVPR接收的論文竟然出錯?這條消息在今天的Reddit炸了鍋。根據論文作者公開的代碼,實驗無法復現,同行評議過程也再次遭到質疑,該不該連代碼也一起審核?網友向大家征求意見:這篇論文該不該被撤稿?

CVPR,計算機視覺乃至人工智能領域頂會中的頂會,“THE頂會”,接收的論文竟然名不副實?

你說該不該撤稿?

今天,一條這樣的消息在Reddit炸了鍋。

事情是這樣的,有人試著去復現了CVPR 2018的一篇論文——CMU和密歇根州立大學的《Perturbative Neural Networks》,發現得不到作者在論文中所描述的結果,他認為這表明論文作者計算有誤,因此其結果無效,于是就在Reddit發帖(在他大前天向作者發郵件但沒有收到回復后)問眾網友:

“我覺得這篇論文該被撤稿。你們覺得呢?”

“THE頂會”CVPR的同行評議竟然出錯?!

一石激起千層浪。

因為這可不是隨便哪篇上傳到arXiv的預印版,而是經過了CVPR雙盲評審的論文啊。連CVPR這樣一等一的頂會都出錯了,這還怎么得了?

具體看,《Perturbative Neural Networks》的作者在文中寫道,如今計算機視覺的成功大多是由于卷積神經網絡(CNN),而他們提出了一個簡單有效的模塊,叫做“干擾層”(perturbation layer),作為卷積層的替代。干擾層不使用傳統意義上的卷積,而是將其響應計算為一個線性加權和,這個和是由增加的噪音干擾輸入的非線性激活組成的。

PNN論文作者通過實驗和分析,表明干擾層可以有效地替代標準的卷積層,然后他們將干擾層組成深度神經網絡——干擾神經網絡(PNN),并在一系列視覺數據集(MNIST,CIFAR-10,PASCAL VOC和ImageNet)上與標準CNN進行比較,得出結論PNN的表現跟CNN一樣好。

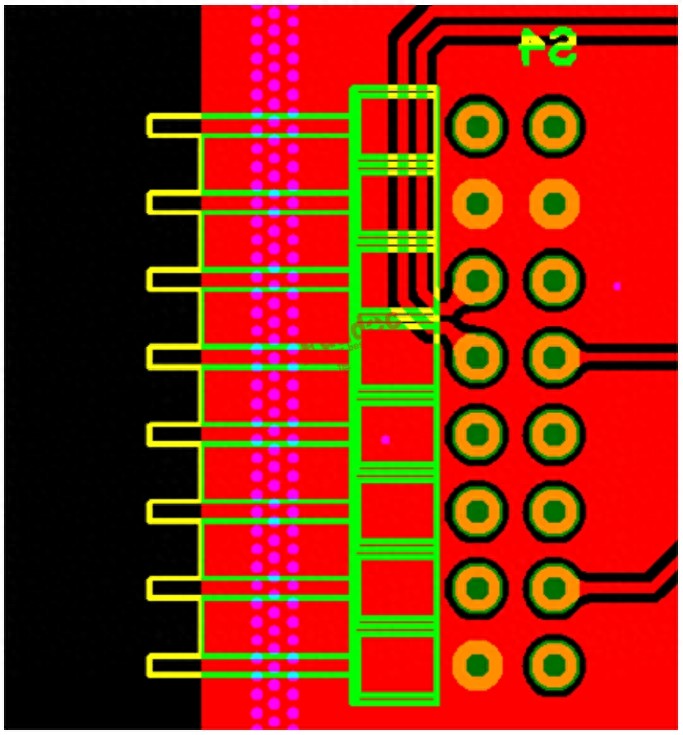

但“p1esk”,也就是在Reddit發言認為該撤稿的那個人就不同意了,他認為將3X3卷積換成1X1再在輸入中增加一些干擾,實際上并沒有什么意義。他的測試結果是這樣的:

P1esk 復現的結果,發現PNN精度根本就沒有到90%,只有85%左右

當然,p1esk 也給出了他詳細的實現過程,具體可以去看Github頁面(見文末)。

論文該不該撤?都是公開代碼惹的禍

好,回到最開始討論的是否該撤稿問題上來。

網友的意見大致可以分為三類:

不用撤,既然作者都把代碼公開了,顯然是無心之過,只要將錯誤改過來就好了;

撤!有錯誤當然撤,不僅如此,以后還應該規定所有論文提交時都必須公開代碼,不僅論文要評審,連代碼也要一并審核;

先把撤稿的事放在一邊:(雙盲)評審過程本身并不涉及代碼的審核,就好像生物學領域的論文不會在審稿期間去重復實驗,也無法做到一一核查代碼,原本就是論文發表后,由其他同行來復現,由此判斷其結論是否經得起科學論證。

你有沒有發現,討論的重點實質上已經從“撤稿”轉移到了“公開代碼”上面。

p1esk 為何能發現PNN論文結果與作者描述得不一致?因為PNN論文的作者將代碼公開了。如果不公開,連發現這個不一致的機會都沒有。

因此,也有人評論,說不定這就是某些論文不公開代碼的原因呢。

這種想法得到了不少贊同,不少人表示,對啊對啊,這比那些說了會公布代碼但卻一直不公布的人要好多了。

而代碼公開,實際上一直是深度學習領域的老大難問題。

有的產業研究機構不太希望公開代碼,因為涉及到專利或產品。

深度學習是如今研究復現率最低的領域之一,正如南京大學計算機系主任、人工智能學院院長周志華教授在AI WORLD 2018世界人工智能峰會發表的演講中提到的那樣:

“常用神經網絡的朋友知道,現在深度神經網絡有很多問題。大家經常說的一件事情就是要花大量的精力調整參數,參數實在太多了。

“不僅如此,這還會帶來另外一個嚴重的問題:哪怕我告訴你同樣的算法、用同樣的數據,如果不告訴你參數是怎么調的,可能就沒有辦法得到同樣的結果。”

作者回應:正在檢查,誤差太大會主動撤稿

現在,Reddit這條討論里被贊最多的回復,來自PNN論文的作者。

你好,我是這篇論文的第一作者。我們在大約3周前注意到了這個問題,現在正在調查中。我很感謝Michael對PNN論文的實現,并將他發現的問題告訴給了我們。我們希望徹底分析問題,并且得到100%確定的結果,之后再給出進一步的回復。

我們可視化工具中平滑函數的默認設置有誤,這是我們疏忽了,現在已經修復。我們正在重新運行所有的實驗。我們會用最新的結果更新我們的arXiv的論文和Github庫。如果分析表明我們的結果確實跟提交CVPR的版本中相差很多,我們會撤回這篇論文。

話雖如此,根據我的初步評估,如果他在實現的時候正確選擇#filters、噪音水平和優化方法,我眼下能夠在CIFAR-10上達到大約90%~91%的精度,而不是他選上述參數得到的85%~86%。但是,不做進一步檢查,我不想說更多。

大部分網友都認為這是一個合理的回復。

那既然作者都這樣說了,圍觀人等就散去吧?

你是不是忘了,最根本的代碼公開還沒有得到結論呢!

如果深度學習和人工智能真的要成為一門科學,那么就必須符合科研的標準。如今,代碼開源以及復現實驗的呼聲越來越高,這也是領域健康發展的證明。

重視論文可重復性,讓深度學習成為一門科學

ICLR在去年舉辦了一個“研究復現挑戰賽”,今天剛剛公布了第二屆的消息。在這個復現挑戰賽中,參賽者從2019年ICLR提交的論文中任意選擇一篇,然后嘗試復現論文中描述的實驗。目標是評估實驗是否可重復,并確定你的發現是否支持該論文的結論。

參賽者的結果可以是肯定的(即確認可重復性),也可以是負面的(即說明無法復現實驗內容,并給出可能的原因)。

舉辦這樣的競賽,就是為了讓更多的人,尤其是學生,加入到論文審核的工作中來,同時也提升其對論文可重復性重要性的意識。

-

神經網絡

+關注

關注

42文章

4793瀏覽量

102006 -

計算機視覺

+關注

關注

8文章

1704瀏覽量

46394

原文標題:CVPR18論文竟然“造假”?雙盲評審代碼也要核查!

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

美報告:中國芯片研究論文全球領先

匯頂科技2024年業績大幅增長

正負壓驅動波形詢問

OpenHarmony程序分析框架論文入選ICSE 2025

評論