RAKsmart作為高性能服務器提供商,其硬件配置和網絡環境非常適合運行AI大模型。下面,AI部落小編為您講解如何在RAKsmart服務器上部署DeepSeek AI大模型的完整流程。

一、部署前的準備工作

1.服務器選型與配置

DeepSeek等AI大模型對計算資源要求較高,建議選擇RAKsmart以下配置的服務器:

GPU型號:至少配備NVIDIATeslaV100或A100顯卡(顯存16GB以上),多卡并行可提升訓練/推理速度。

內存:64GB及以上,避免因內存不足導致進程崩潰。

存儲:1TBNVMeSSD,確保模型文件(通常數百GB)快速加載。

操作系統:Ubuntu22.04LTS或CentOS8,兼容主流深度學習框架。

2.系統環境初始化

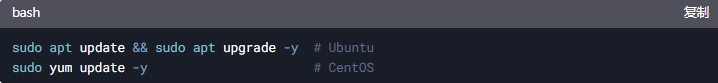

更新系統:

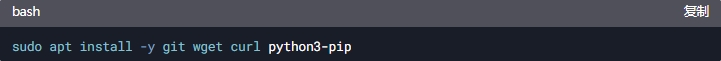

安裝基礎工具:

二、安裝深度學習環境

1.配置NVIDIA驅動與CUDA

安裝顯卡驅動:

訪問NVIDIA驅動下載頁,選擇對應GPU型號的驅動。

安裝CUDAToolkit:

DeepSeek依賴CUDA加速,推薦CUDA11.8:

添加環境變量至~/.bashrc:

2.安裝PyTorch與依賴庫

使用pip安裝適配CUDA11.8的PyTorch:

安裝模型運行依賴:

三、下載與配置DeepSeek模型

1.獲取模型權重

官方渠道:

若已獲得DeepSeek官方授權,可通過提供的鏈接下載模型文件(通常為.bin或.safetensors格式)。

HuggingFaceHub:

若模型已開源,使用git-lfs克隆倉庫:

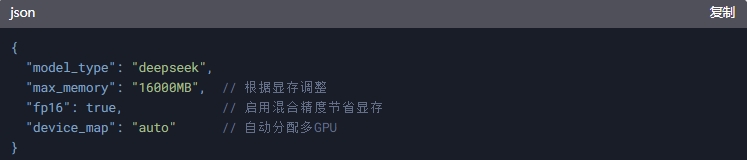

2.模型配置文件調整

修改config.json以適配硬件:

四、啟動模型推理服務

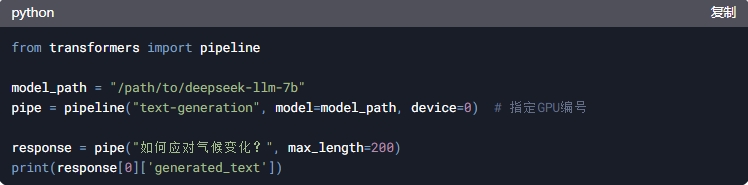

1.編寫推理腳本

創建inference.py,使用HuggingFace的pipeline快速調用:

2.運行測試

若輸出合理文本,說明模型部署成功。

五、優化與安全加固

1.性能優化技巧

多GPU并行:

使用accelerate庫啟動多卡推理:

量化壓縮:

啟用8位量化減少顯存占用:

2.安全防護措施

防火墻設置:

僅開放必要端口(如HTTPAPI的5000端口):

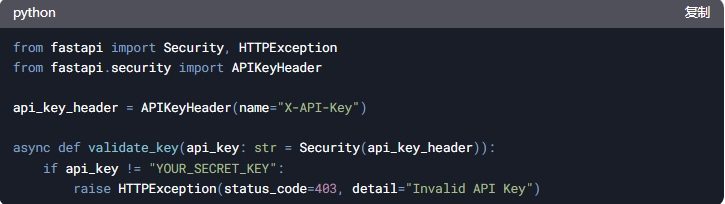

API訪問鑒權:

使用FastAPI添加API密鑰驗證:

六、總結

通過上述步驟,可以在RAKsmart服務器上部署DeepSeek AI大模型,并實現了基礎推理與安全防護。對于企業級應用,可進一步結合Kubernetes實現彈性擴縮容,或使用ONNXRuntime提升推理效率。

審核編輯 黃宇

-

AI大模型

+關注

關注

0文章

358瀏覽量

462 -

DeepSeek

+關注

關注

1文章

751瀏覽量

977

發布評論請先 登錄

相關推薦

RAKsmart高性能服務器集群:驅動AI大語言模型開發的算力引擎

RAKsmart服務器如何重塑AI高并發算力格局

存儲服務器怎么搭建?RAKsmart實戰指南

如何在RAKsmart服務器上實現企業AI模型部署

RAKsmart企業服務器上部署DeepSeek編寫運行代碼

DeepSeek企業級部署服務器資源計算 以raksmart裸機云服務器為例

依托raksmart服務器在多種系統上本地部署deepseek注意事項

利用RAKsmart服務器托管AI模型訓練的優勢

如何在RakSmart服務器上用Linux系統部署DeepSeek

RAKsmart美國裸機云服務器DeepSeek的高級定制化部署方案

DeepSeek企業級部署實戰指南:以Raksmart企業服務器為例

RK3588開發板上部署DeepSeek-R1大模型的完整指南

昇騰推理服務器+DeepSeek大模型 技術培訓在圖為科技成功舉辦

評論