Ceph--分布式存儲

一、存儲基礎

1.單機存儲設備

●DAS(直接附加存儲,是直接接到計算機的主板總線上去的存儲)

IDE、SATA、SCSI、SAS、USB 接口的磁盤

所謂接口就是一種存儲設備驅動下的磁盤設備,提供塊級別的存儲

●NAS(網絡附加存儲,是通過網絡附加到當前主機文件系統之上的存儲)

NFS、CIFS、FTP

文件系統級別的存儲,本身就是一個做好的文件系統,通過nfs接口在用戶空間輸出后,客戶端基于內核模塊與遠程主機進行網絡通信,把它轉為好像本地文件系統一樣來使用,這種存儲服務是沒辦法對它再一次格式化創建文件系統塊的

●SAN(存儲區域網絡)

SCSI協議(只是用來傳輸數據的存取操作,物理層使用SCSI線纜來傳輸)、FCSAN(物理層使用光纖來傳輸)、iSCSI(物理層使用以太網來傳輸)

也是一種網絡存儲,但不同之處在于SAN提供給客戶端主機使用的接口是塊級別的存儲

2.單機存儲的問題

●存儲處理能力不足

傳統的IDE的IO值是100次/秒,SATA固態磁盤500次/秒,固態硬盤達到2000-4000次/秒。即使磁盤的IO能力再大數十倍,也不夠抗住網站訪問高峰期數十萬、數百萬甚至上億用戶的同時訪問,這同時還要受到主機網絡IO能力的限制。

●存儲空間能力不足

單塊磁盤的容量再大,也無法滿足用戶的正常訪問所需的數據容量限制。

●單點故障問題

單機存儲數據存在單點故障問題

3.商業存儲解決方案

EMC、NetAPP、IBM、DELL、華為、浪潮

4.分布式存儲(軟件定義的存儲 SDS)

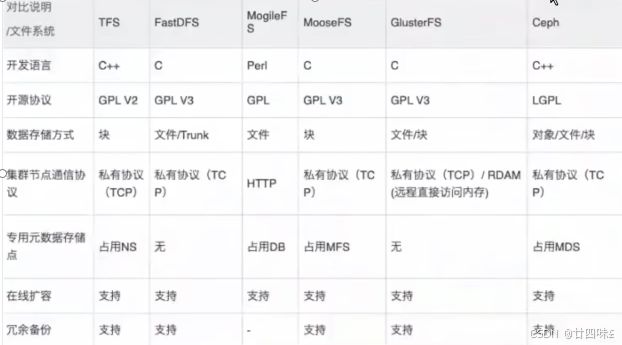

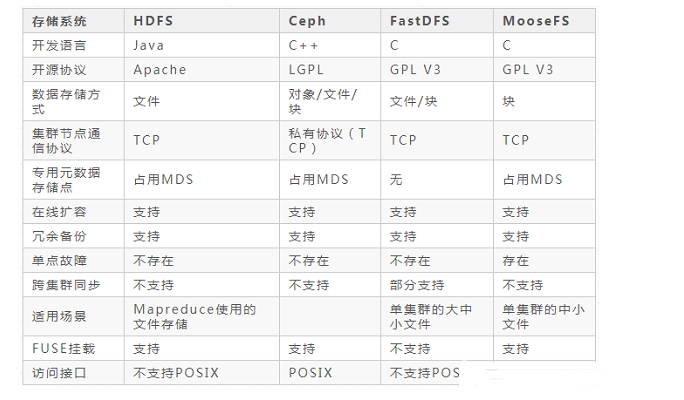

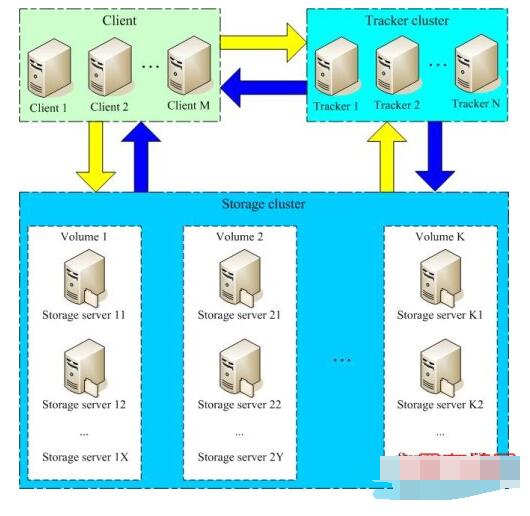

Ceph、TFS、FastDFS、MooseFS(MFS)、HDFS、GlusterFS(GFS)

存儲機制會把數據分散存儲到多個節點上,具有高擴展性、高性能、高可用性等優點。

5.分布式存儲的類型

●塊存儲(例如硬盤,一般是一個存儲被一個服務器掛載使用,適用于容器或虛擬機存儲卷分配、日志存儲、文件存儲)

就是一個裸設備,用于提供沒有被組織過的存儲空間,底層以分塊的方式來存儲數據

●文件存儲(例如NFS,解決塊存儲無法共享問題,可以一個存儲被多個服務器同時掛載,適用于目錄結構的存儲、日志存儲)

是一種數據的組織存放接口,一般是建立在塊級別的存儲結構之上,以文件形式來存儲數據,而文件的元數據和實際數據是分開存儲的

●對象存儲(例如OSS,一個存儲可以被多服務同時訪問,具備塊存儲的高速讀寫能力,也具備文件存儲共享的特性,適用圖片存儲、視頻存儲)

基于API接口提供的文件存儲,每一個文件都是一個對象,且文件大小各不相同的,文件的元數據和實際數據是存放在一起的

二、Ceph 概述

1.Ceph 簡介

Ceph使用C++語言開發,是一個開放、自我修復和自我管理的開源分布式存儲系統。具有高擴展性、高性能、高可靠性的優點。

Ceph目前已得到眾多云計算廠商的支持并被廣泛應用。RedHat及OpenStack,Kubernetes都可與Ceph整合以支持虛擬機鏡像的后端存儲。

粗略估計,我國70%—80%的云平臺都將Ceph作為底層的存儲平臺,由此可見Ceph儼然成為了開源云平臺的標配。目前國內使用Ceph搭建分布式存儲系統較為成功的企業有華為、阿里、中興、華三、浪潮、中國移動、網易、樂視、360、星辰天合存儲、杉巖數據等。

2.Ceph 優勢

●高擴展性:去中心化,支持使用普通X86服務器,支持上千個存儲節點的規模,支持TB到EB級的擴展。

●高可靠性:沒有單點故障,多數據副本,自動管理,自動修復。

●高性能:摒棄了傳統的集中式存儲元數據尋址的方案,采用 CRUSH 算法,數據分布均衡,并行度高。

●功能強大:Ceph是個大一統的存儲系統,集塊存儲接口(RBD)、文件存儲接口(CephFS)、對象存儲接口(RadosGW)于一身,因而適用于不同的應用場景。

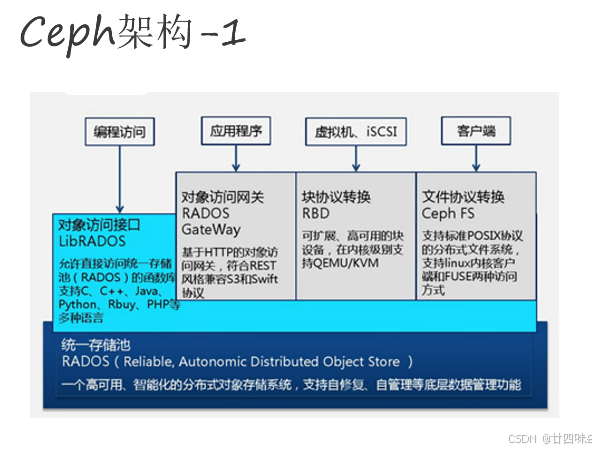

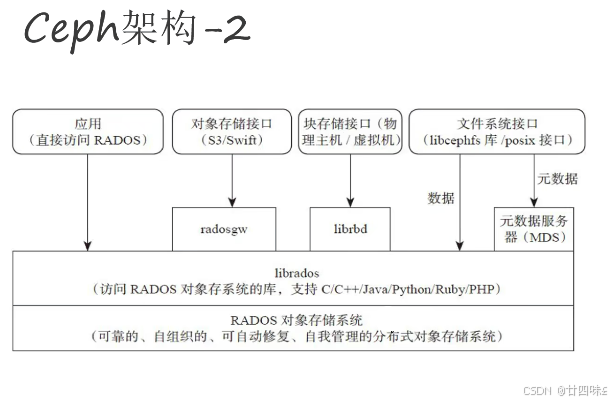

3.Ceph 架構

自下向上,可以將Ceph系統分為四個層次:

●RADOS 基礎存儲系統(Reliab1e,Autonomic,Distributed object store,即可靠的、自動化的、分布式的對象存儲)

RADOS是Ceph最底層的功能模塊,是一個無限可擴容的對象存儲服務,能將文件拆解成無數個對象(碎片)存放在硬盤中,大大提高了數據的穩定性。它主要由OSD和Monitor兩個組件組成,OSD和Monitor都可以部署在多臺服務器中,這就是ceph分布式的由來,高擴展性的由來。

●LIBRADOS 基礎庫

Librados提供了與RADOS進行交互的方式,并向上層應用提供Ceph服務的API接口,因此上層的RBD、RGW和CephFS都是通過Librados訪問的,目前提供PHP、Ruby、Java、Python、Go、C和C++支持,以便直接基于RADOS(而不是整個Ceph)進行客戶端應用開發。

●高層應用接口:包括了三個部分

1)對象存儲接口 RGW(RADOS Gateway)

網關接口,基于Librados開發的對象存儲系統,提供S3和Swift兼容的RESTful API接口。

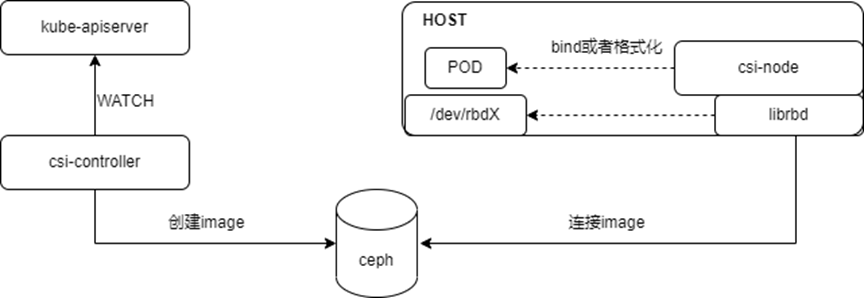

2)塊存儲接口 RBD(Reliable Block Device)

基于Librados提供塊設備接口,主要用于Host/VM。

3)文件存儲接口 CephFS(Ceph File System)

Ceph文件系統,提供了一個符合POSIX標準的文件系統,它使用Ceph存儲集群在文件系統上存儲用戶數據。基于Librados提供的分布式文件系統接口。

●應用層:基于高層接口或者基礎庫Librados開發出來的各種APP,或者Host、VM等諸多客戶端

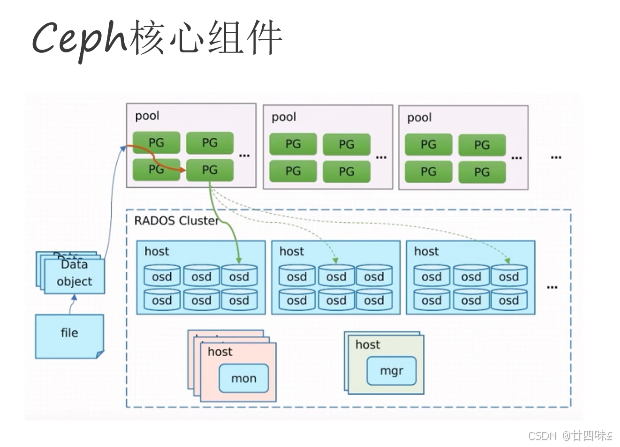

4.Ceph 核心組件

Ceph是一個對象式存儲系統,它把每一個待管理的數據流(如文件等數據)切分為一到多個固定大小(默認4兆)的對象數據(Object),并以其為原子單元(原子是構成元素的最小單元)完成數據的讀寫。

●OSD(Object Storage Daemon,守護進程 ceph-osd)

是負責物理存儲的進程,一般配置成和磁盤一一對應,一塊磁盤啟動一個OSD進程。主要功能是存儲數據、復制數據、平衡數據、恢復數據,以及與其它OSD間進行心跳檢查,負責響應客戶端請求返回具體數據的進程等。通常至少需要3個OSD來實現冗余和高可用性。

●PG(Placement Group 歸置組)

PG 是一個虛擬的概念而已,物理上不真實存在。它在數據尋址時類似于數據庫中的索引:Ceph 先將每個對象數據通過HASH算法固定映射到一個 PG 中,然后將 PG 通過 CRUSH 算法映射到 OSD。

●Pool

Pool 是存儲對象的邏輯分區,它起到 namespace 的作用。每個 Pool 包含一定數量(可配置)的 PG。Pool 可以做故障隔離域,根據不同的用戶場景統一進行隔離。

#Pool中數據保存方式支持兩種類型:

●多副本(replicated):類似 raid1,一個對象數據默認保存 3 個副本,放在不同的 OSD

●糾刪碼(Erasure Code):類似 raid5,對 CPU 消耗稍大,但是節約磁盤空間,對象數據保存只有 1 個副本。由于Ceph部分功能不支持糾刪碼池,此類型存儲池使用不多

#Pool、PG 和 OSD 的關系:

一個Pool里有很多個PG;一個PG里包含一堆對象,一個對象只能屬于一個PG;PG有主從之分,一個PG分布在不同的OSD上(針對多副本類型)

●Monitor(守護進程 ceph-mon)

用來保存OSD的元數據。負責維護集群狀態的映射視圖(Cluster Map:OSD Map、Monitor Map、PG Map 和 CRUSH Map),維護展示集群狀態的各種圖表, 管理集群客戶端認證與授權。一個Ceph集群通常至少需要 3 或 5 個(奇數個)Monitor 節點才能實現冗余和高可用性,它們通過 Paxos 協議實現節點間的同步數據。

●Manager(守護進程 ceph-mgr)

負責跟蹤運行時指標和 Ceph 集群的當前狀態,包括存儲利用率、當前性能指標和系統負載。為外部監視和管理系統提供額外的監視和接口,例如 zabbix、prometheus、 cephmetrics 等。一個 Ceph 集群通常至少需要 2 個 mgr 節點實現高可用性,基于 raft 協議實現節點間的信息同步。

●MDS(Metadata Server,守護進程 ceph-mds)

是 CephFS 服務依賴的元數據服務。負責保存文件系統的元數據,管理目錄結構。對象存儲和塊設備存儲不需要元數據服務;如果不使用 CephFS 可以不安裝。

5.OSD 存儲引擎

OSD 有兩種方式管理它們存儲的數據。在 Luminous 12.2.z 及以后的發行版中,默認(也是推薦的)后端是 BlueStore。在 Luminous 發布之前, 默認是 FileStore, 也是唯一的選項。

●Filestore

FileStore是在Ceph中存儲對象的一個遺留方法。它依賴于一個標準文件系統(只能是XFS),并結合一個鍵/值數據庫(傳統上是LevelDB,現在BlueStore是RocksDB),用于保存和管理元數據。

FileStore經過了良好的測試,在生產中得到了廣泛的應用。然而,由于它的總體設計和對傳統文件系統的依賴,使得它在性能上存在許多不足。

●Bluestore

從 Ceph 12.2.0(Luminous) 版本開始的。在 Luminous 版本中,BlueStore 被引入作為一種新的、高性能的 OSD 存儲引擎,以替代舊的 FileStore 引擎。

在 Ceph 中,BlueStore 可以提供更快的響應時間和更高的數據吞吐量,同時也具有更好的可靠性和穩定性。相比之下,舊的 FileStore 存儲引擎通常需要更多的 CPU 和內存資源,對 IO 延遲的敏感度也較高。

FileStore 將對象存儲為塊設備基礎上的文件系統(通常是 XFS)中的文件。

BlueStore 將對象直接存儲在原始塊設備上,免除了對文件系統層的需要,提高了讀寫操作速度,通過直接操作底層塊設備來管理數據,而不是傳統的文件系統。

這種方法提供了更好的性能和可靠性,因為可以將數據劃分為較小的塊并使用校驗和來檢測錯誤。此外,BlueStore可以直接與Solid State Drive(SSD)交互,并利用其快速讀寫速度。

BlueStore還具有可擴展性,可以處理數百萬個物理盤和千億個對象。它實現了動態負載平衡和自動恢復機制,以確保高可用性和數據可靠性。

6.Ceph 數據的存儲過程

1)客戶端從 mon 獲取最新的 Cluster Map

2)在 Ceph 中,一切皆對象。Ceph 存儲的數據都會被切分成為一到多個固定大小的對象(Object)。Object size 大小可以由管理員調整,通常為 2M 或 4M。

每個對象都會有一個唯一的 OID,由 ino 與 ono 組成:

●ino :即是文件的 FileID,用于在全局唯一標識每一個文件

●ono :則是分片的編號

比如:一個文件 FileID 為 A,它被切成了兩個對象,一個對象編號0,另一個編號1,那么這兩個文件的 oid 則為 A0 與 A1。

OID 的好處是可以唯一標示每個不同的對象,并且存儲了對象與文件的從屬關系。由于 Ceph 的所有數據都虛擬成了整齊劃一的對象,所以在讀寫時效率都會比較高。

3)通過對 OID 使用 HASH 算法得到一個16進制的特征碼,用特征碼與 Pool 中的 PG 總數取余,得到的序號則是 PGID 。

即 Pool_ID + HASH(OID) % PG_NUM 得到 PGID

4)PG 會根據設置的副本數量進行復制,通過對 PGID 使用 CRUSH 算法算出 PG 中目標主和次 OSD 的 ID,存儲到不同的 OSD 節點上(其實是把 PG 中的所有對象存儲到 OSD 上)。

即通過 CRUSH(PGID) 得到將 PG 中的數據存儲到各個 OSD 組中

CRUSH 是 Ceph 使用的數據分布算法,類似一致性哈希,讓數據分配到預期的地方。

7.Ceph 版本發行生命周期

Ceph從Nautilus版本(14.2.0)開始,每年都會有一個新的穩定版發行,預計是每年的3月份發布,每年的新版本都會起一個新的名稱(例如,“Mimic”)和一個主版本號(例如,13代表Mimic,因為“M”是字母表的第13個字母)。

版本號的格式為 x.y.z,x 表示發布周期(例如,13 代表 Mimic,17 代表 Quincy),y 表示發布版本類型,即

● x.0.z :y等于 0,表示開發版本

● x.1.z :y等于 1,表示發布候選版本(用于測試集群)

● x.2.z :y等于 2,表示穩定/錯誤修復版本(針對用戶)

8.Ceph 集群部署

目前 Ceph 官方提供很多種部署 Ceph 集群的方法,常用的分別是 ceph-deploy,cephadm 和 二進制:

●ceph-deploy :一個集群自動化部署工具,使用較久,成熟穩定,被很多自動化工具所集成,可用于生產部署。

●cephadm :從 Octopus 和較新的版本版本后使用 cephadm 來部署 ceph 集群,使用容器和 systemd 安裝和管理 Ceph 集群。目前不建議用于生產環境。

●二進制:手動部署,一步步部署 Ceph 集群,支持較多定制化和了解部署細節,安裝難度較大。

三、基于 ceph-deploy 部署 Ceph 集群

Ceph 生產環境推薦:

1、存儲集群全采用萬兆網絡

2、集群網絡(cluster-network,用于集群內部通訊)與公共網絡(public-network,用于外部訪問Ceph集群)分離

3、mon、mds 與 osd 分離部署在不同主機上(測試環境中可以讓一臺主機節點運行多個組件)

4、OSD 使用 SATA 亦可

5、根據容量規劃集群

6、至強E5 2620 V3或以上 CPU,64GB或更高內存

7、集群主機分散部署,避免機柜的電源或者網絡故障

Ceph 環境規劃

主機名 Public網絡 Cluster網絡 角色 admin 192.168.10.120 admin(管理節點負責集群整體部署)、client node01 192.168.10.121 192.168.100.11 mon、mgr、osd(/dev/sdb、/dev/sdc、/dev/sdd) node02 192.168.10.122 192.168.100.12 mon,mgr,osd(/dev/sdb、/dev/sdc、/dev/sdd) node03 192.168.10.123 192.168.100.13 mon,osd(/dev/sdb、/dev/sdc、/dev/sdd) client 192.168.10.124 client

環境準備

可選步驟:創建 Ceph 的管理用戶

useraddcephadm passwdcephadm visudo cephadmALL=(root) NOPASSWD:ALL

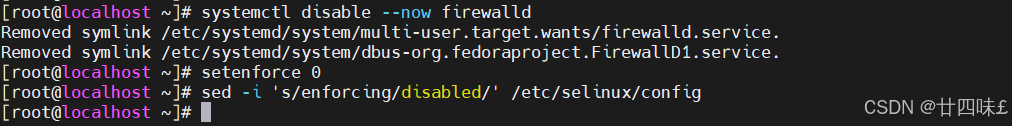

1.關閉 selinux 與防火墻

systemctl disable --now firewalld

setenforce 0

sed -i 's/enforcing/disabled/' /etc/selinux/config

2.根據規劃設置主機名

hostnamectl set-hostname admin

hostnamectl set-hostname node01

hostnamectl set-hostname node02

hostnamectl set-hostname node03

hostnamectl set-hostname client

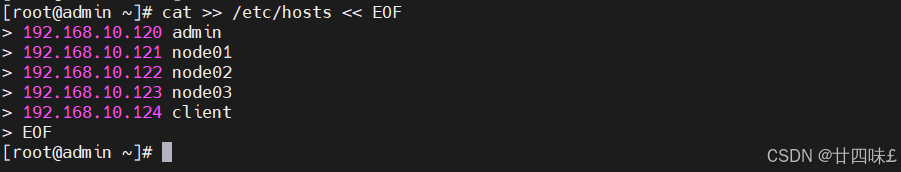

3.配置 hosts 解析

cat >> /etc/hosts << EOF

192.168.10.120 admin

192.168.10.121 node01

192.168.10.122 node02

192.168.10.123 node03

192.168.10.124 client

EOF

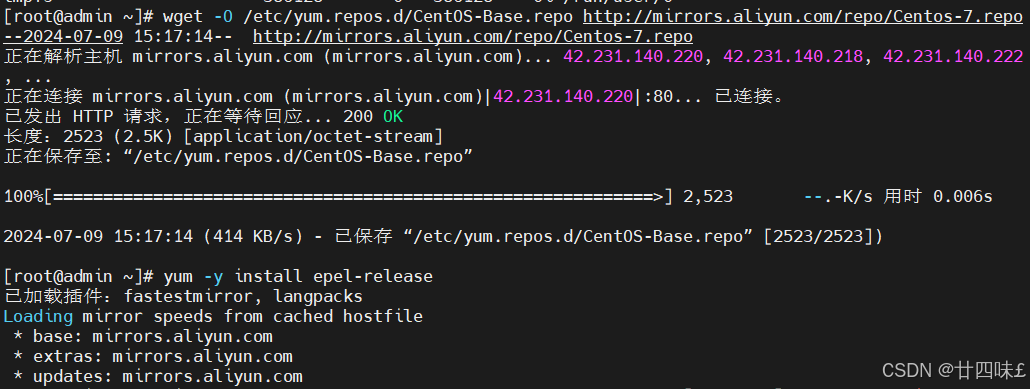

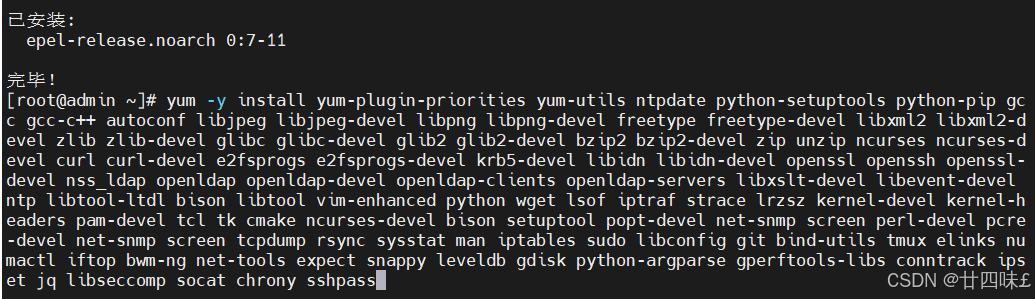

4.安裝常用軟件和依賴包

wget-O/etc/yum.repos.d/CentOS-Base.repo http://mirrors.aliyun.com/repo/Centos-7.repo yum-yinstall epel-release yum-yinstall yum-plugin-prioritiesyum-utilsntpdate python-setuptoolspython-pipgcc gcc-c++ autoconf libjpeg libjpeg-devellibpng libpng-develfreetype freetype-devellibxml2 libxml2-develzlib zlib-develglibc glibc-develglib2 glib2-develbzip2 bzip2-develzip unzip ncurses ncurses-develcurlcurl-devele2fsprogs e2fsprogs-develkrb5-devellibidn libidn-developenssl openssh openssl-develnss_ldap openldap openldap-developenldap-clientsopenldap-serverslibxslt-devellibevent-develntp libtool-ltdlbison libtool vim-enhancedpythonwgetlsof iptraf strace lrzsz kernel-develkernel-headerspam-develtcl tk cmake ncurses-develbison setuptool popt-develnet-snmpscreen perl-develpcre-develnet-snmpscreen tcpdump rsync sysstatmaniptables sudo libconfig git bind-utilstmux elinks numactl iftop bwm-ngnet-toolsexpect snappy leveldb gdisk python-argparsegperftools-libsconntrack ipset jq libseccomp socat chrony sshpass

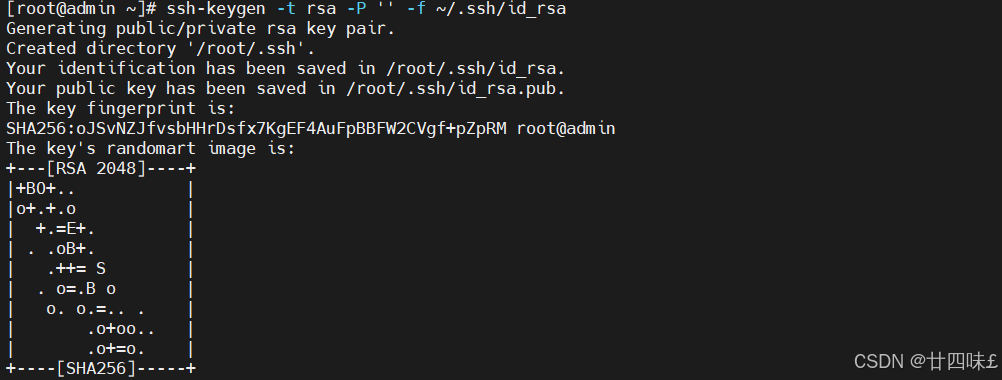

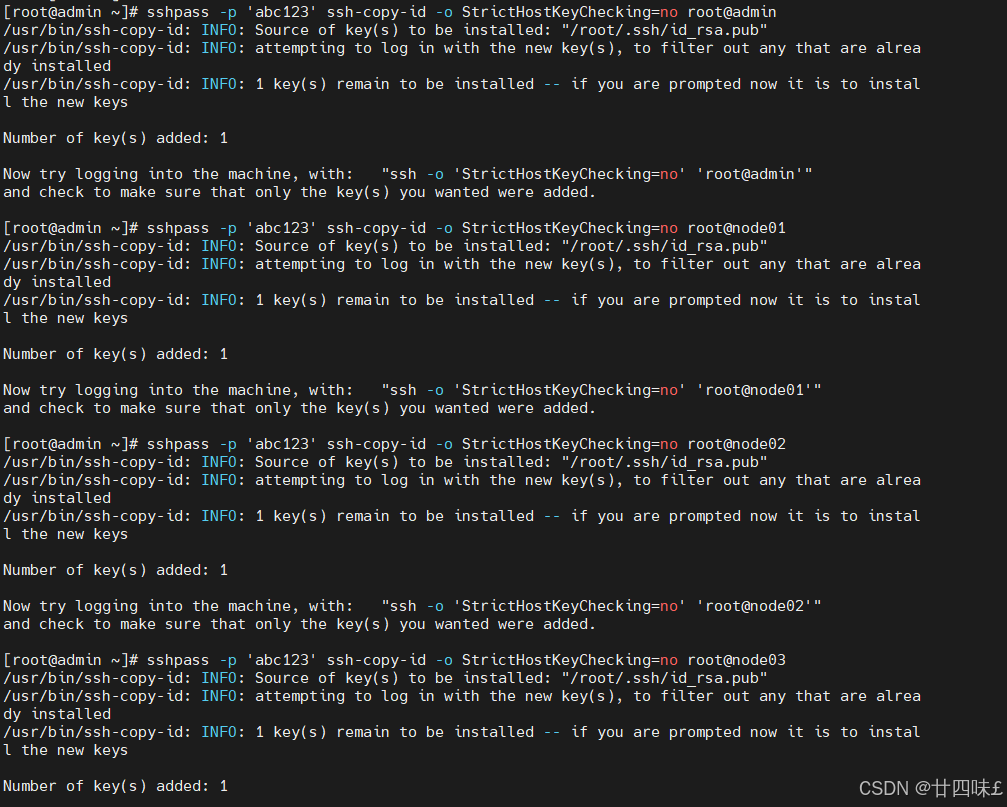

5.在 admin 管理節點配置 ssh 免密登錄所有節點

ssh-keygen -t rsa -P''-f ~/.ssh/id_rsasshpass -p'abc1234'ssh-copy-id -o StrictHostKeyChecking=noroot@adminsshpass -p'abc1234'ssh-copy-id -o StrictHostKeyChecking=noroot@node01sshpass -p'abc1234'ssh-copy-id -o StrictHostKeyChecking=noroot@node02sshpass -p'abc1234'ssh-copy-id -o StrictHostKeyChecking=noroot@node03

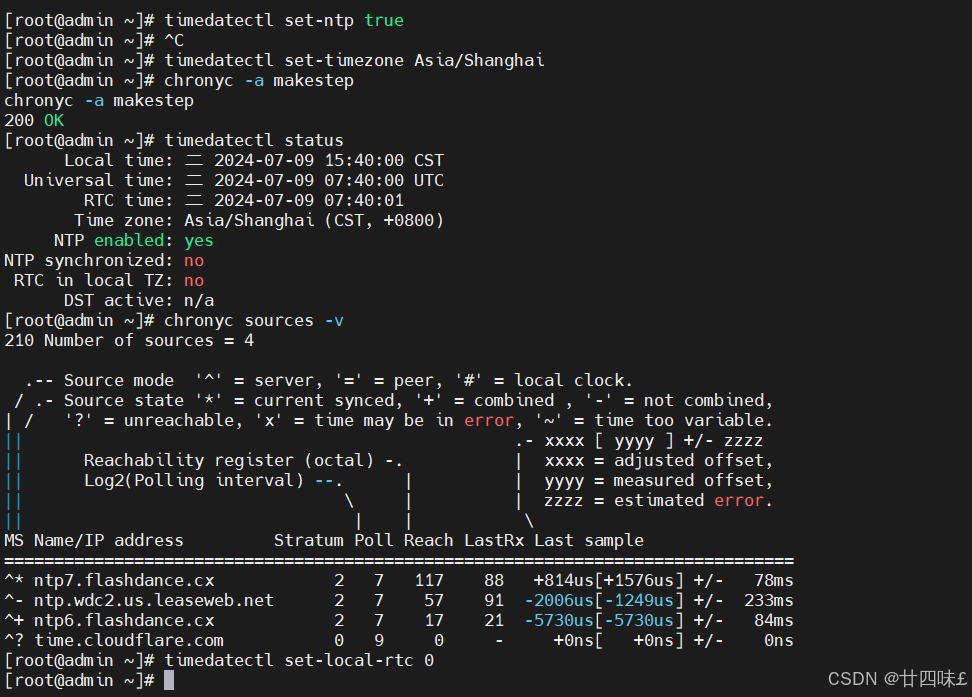

6.配置時間同步

systemctl enable --now chronydtimedatectl set-ntptrue #開啟 NTPtimedatectl set-timezone Asia/Shanghai #設置時區chronyc -a makestep #強制同步下系統時鐘timedatectl status #查看時間同步狀態chronyc sources -v #查看 ntp 源服務器信息timedatectl set-local-rtc0 #將當前的UTC時間寫入硬件時鐘

#重啟依賴于系統時間的服務

systemctl restart rsyslog

systemctl restart crond

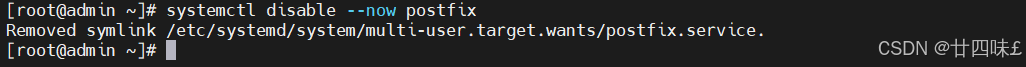

#關閉無關服務

systemctl disable --now postfix

7.配置 Ceph yum源

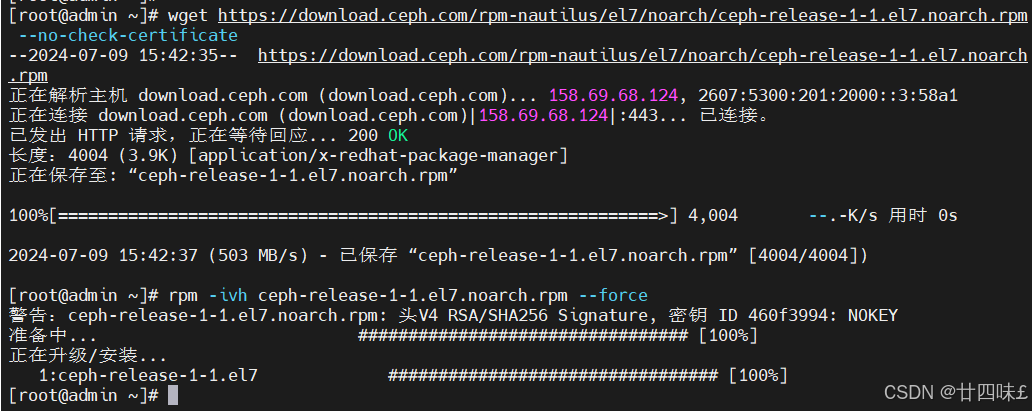

wget https://download.ceph.com/rpm-nautilus/el7/noarch/ceph-release-1-1.el7.noarch.rpm --no-check-certificate

rpm -ivh ceph-release-1-1.el7.noarch.rpm --force

8、執行完上面所有的操作之后重啟所有主機(可選)

sync

reboot

四、部署 Ceph 集群

1.為所有節點都創建一個 Ceph 工作目錄,后續的工作都在該目錄下進行

mkdir -p /etc/ceph

2.安裝 ceph-deploy 部署工具

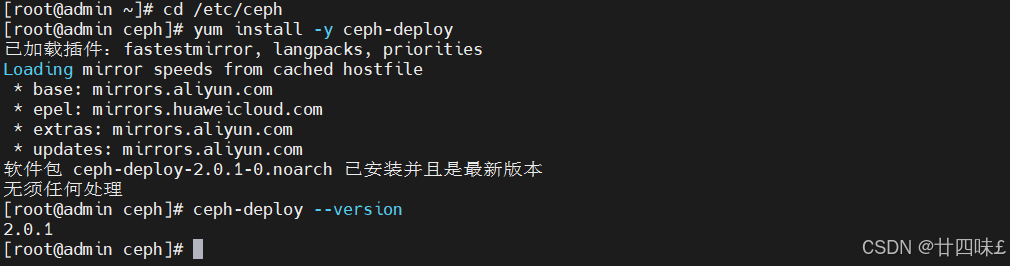

cd /etc/ceph

yum install -y ceph-deploy

ceph-deploy --version

3.在管理節點為其它節點安裝 Ceph 軟件包

#ceph-deploy 2.0.1 默認部署的是 mimic 版的 Ceph,若想安裝其他版本的 Ceph,可以用 --

release 手動指定版本

cd /etc/ceph

ceph-deploy install --release nautilus node0{1..3} admin

#ceph-deploy install 本質就是在執行下面的命令:

yum clean all

yum -y install epel-release

yum -y install yum-plugin-priorities

yum -y install ceph-release ceph ceph-radosgw

#也可采用手動安裝 Ceph 包方式,在其它節點上執行下面的命令將 Ceph 的安裝包都部署上:

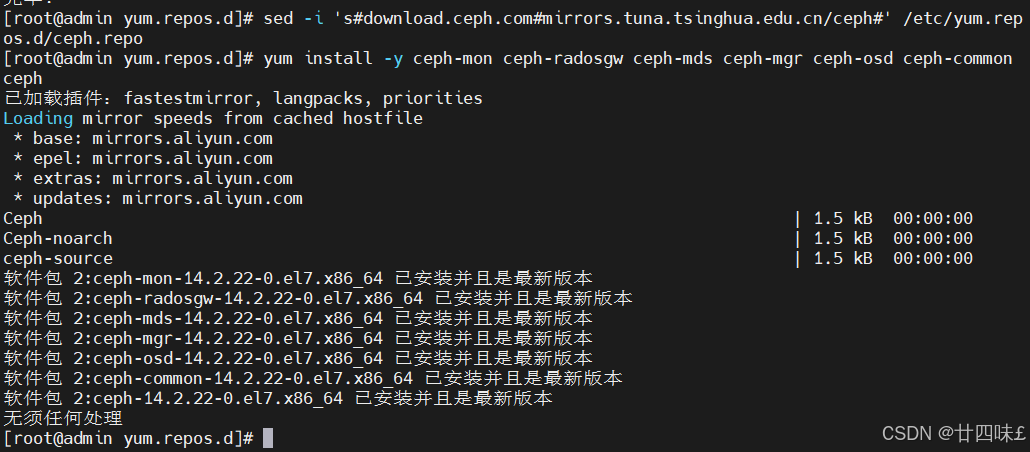

sed -i 's#download.ceph.com#mirrors.tuna.tsinghua.edu.cn/ceph#' /etc/yum.repos.d/ceph.repo

yum install -y ceph-mon ceph-radosgw ceph-mds ceph-mgr ceph-osd ceph-common ceph

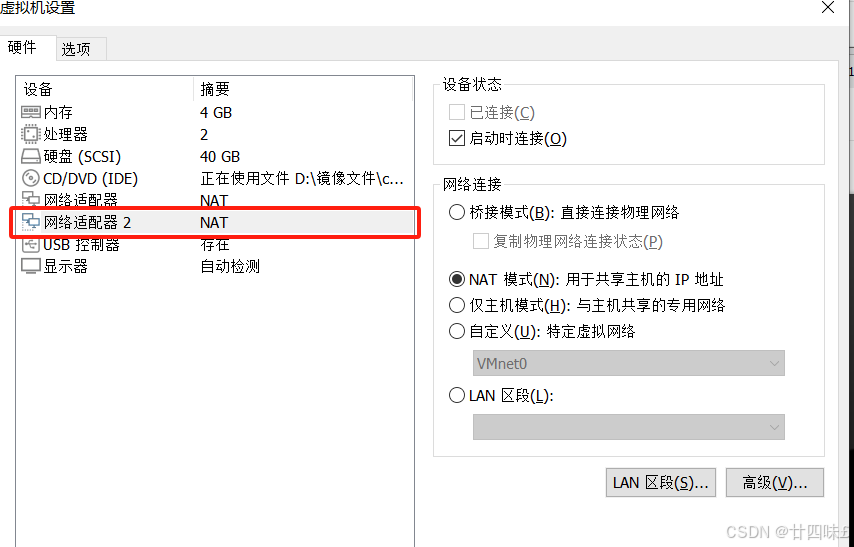

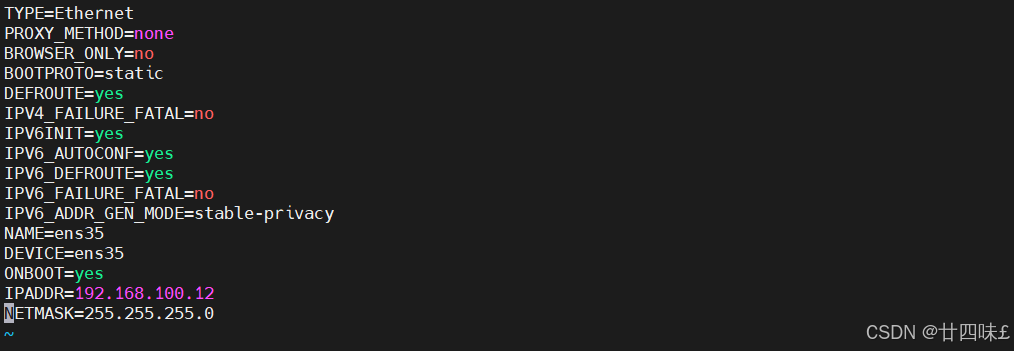

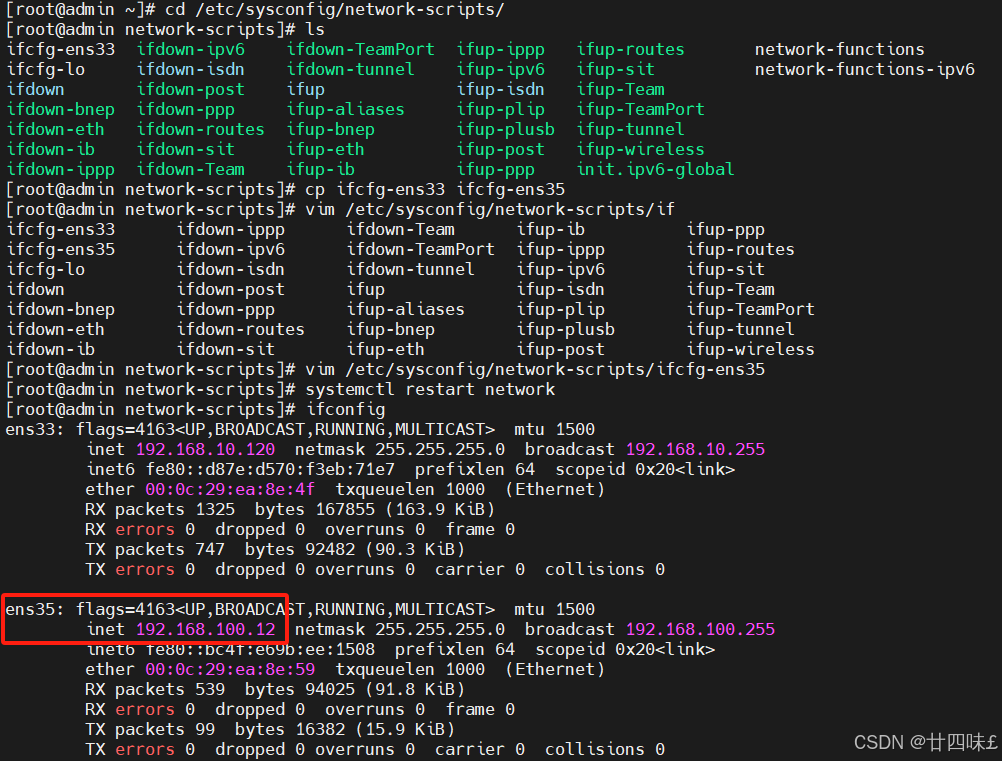

添加網絡適配器

4.生成初始配置

#在管理節點運行下述命令,告訴 ceph-deploy 哪些是 mon 監控節點

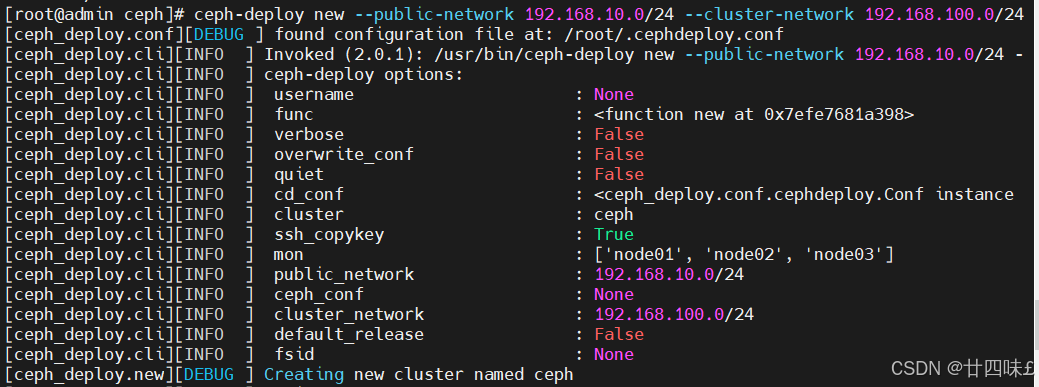

cd /etc/ceph

ceph-deploy new --public-network 192.168.10.0/24 --cluster-network 192.168.100.0/24 node01 node02 node03

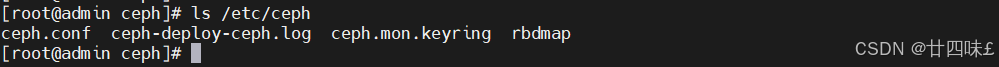

#命令執行成功后會在 /etc/ceph 下生成配置文件

ls /etc/ceph

ceph.conf #ceph的配置文件

ceph-deploy-ceph.log #monitor的日志

ceph.mon.keyring #monitor的密鑰環文件

5.在管理節點初始化 mon 節點

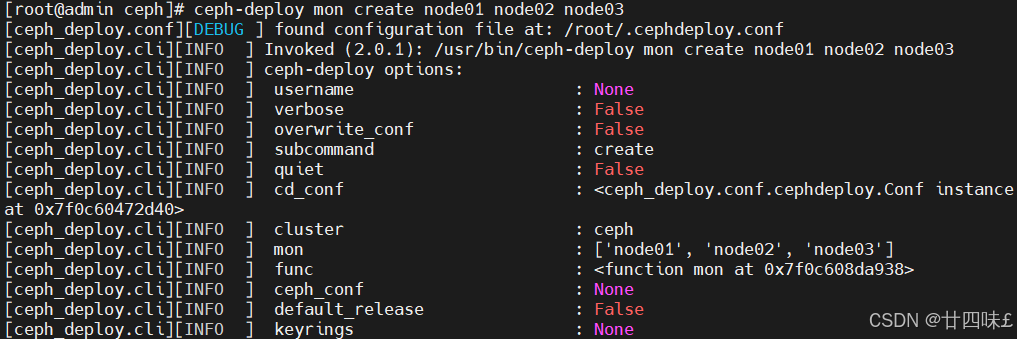

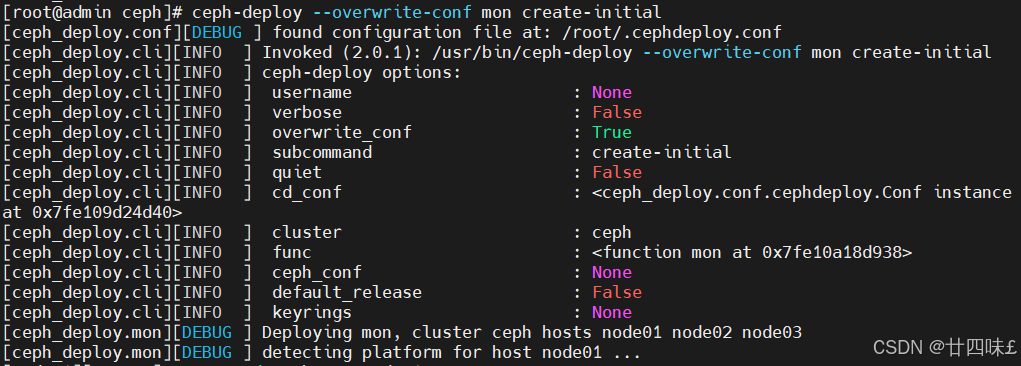

cd/etc/cephceph-deploy mon create node01 node02 node03 #創建 mon 節點,由于 monitor 使用 Paxos 算法,其高可用集群節點數量要求為大于等于 3 的奇數臺 ceph-deploy --overwrite-conf mon create-initial #配置初始化 mon 節點,并向所有節點同步配置 --overwrite-conf 參數用于表示強制覆蓋配置文件 ceph-deploy gatherkeys node01 #可選操作,向 node01 節點收集所有密鑰

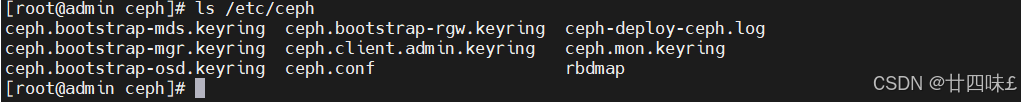

#命令執行成功后會在 /etc/ceph 下生成配置文件

ls/etc/cephceph.bootstrap-mds.keyring #引導啟動 mds 的密鑰文件ceph.bootstrap-mgr.keyring #引導啟動 mgr 的密鑰文件ceph.bootstrap-osd.keyring #引導啟動 osd 的密鑰文件ceph.bootstrap-rgw.keyring #引導啟動 rgw 的密鑰文件ceph.client.admin.keyring #ceph客戶端和管理端通信的認證密鑰,擁有ceph集群的所有權限ceph.confceph-deploy-ceph.logceph.mon.keyring

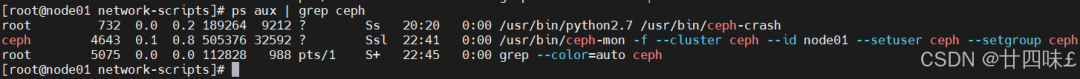

#在 mon 節點上查看自動開啟的 mon 進程ps aux | grep cephroot 1823 0.0 0.2 189264 9216 ? Ss 19:46 0:00 /usr/bin/python2.7 /usr/bin/ceph-crashceph 3228 0.0 0.8 501244 33420 ? Ssl 21:08 0:00 /usr/bin/ceph-mon -f --cluster ceph --idnode03 --setuser ceph --setgroupcephroot 3578 0.0 0.0 112824 988 pts/1 R+ 21:24 0:00 grep --color=auto ceph

#在管理節點查看 Ceph 集群狀態

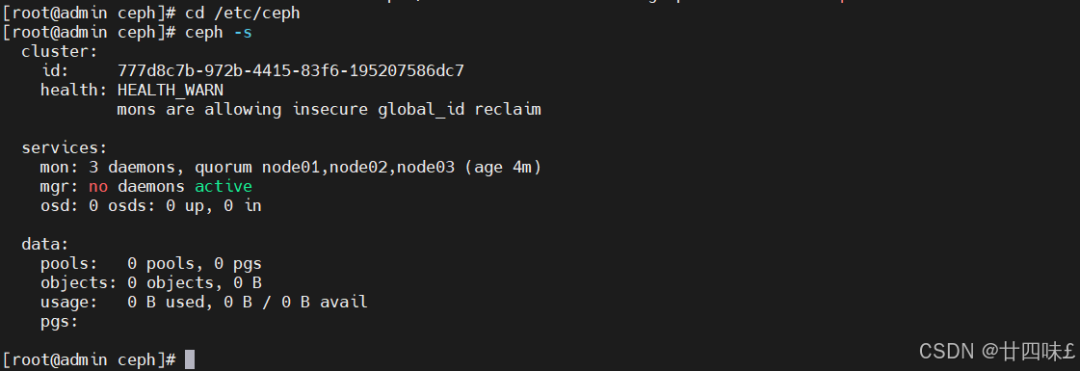

cd/etc/cephceph -s cluster: id: 7e9848bb-909c-43fa-b36c-5805ffbbeb39 health: HEALTH_WARN mons are allowing insecure global_id reclaim services: mon:3daemons, quorum node01,node02,node03 mgr: no daemons active osd:0osds:0up,0in data: pools: 0pools,0pgs objects:0objects,0B usage: 0B used,0B /0B avail pgs:

#查看 mon 集群選舉的情況

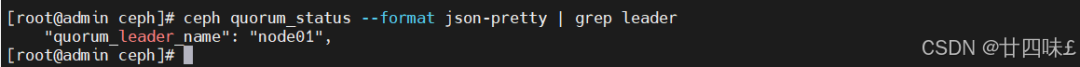

ceph quorum_status --format json-pretty | grep leader

"quorum_leader_name": "node01",

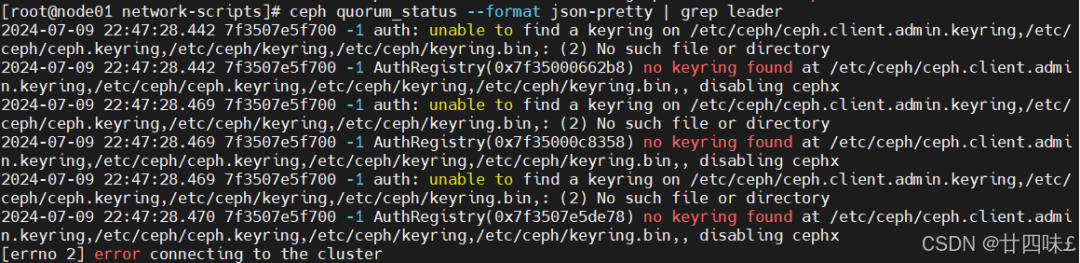

注意:這條命令只能在admin執行,其他節點執行會報錯,如下,因為ceph目錄里沒有配置文件

#擴容 mon 節點

ceph-deploy mon add <節點名稱>

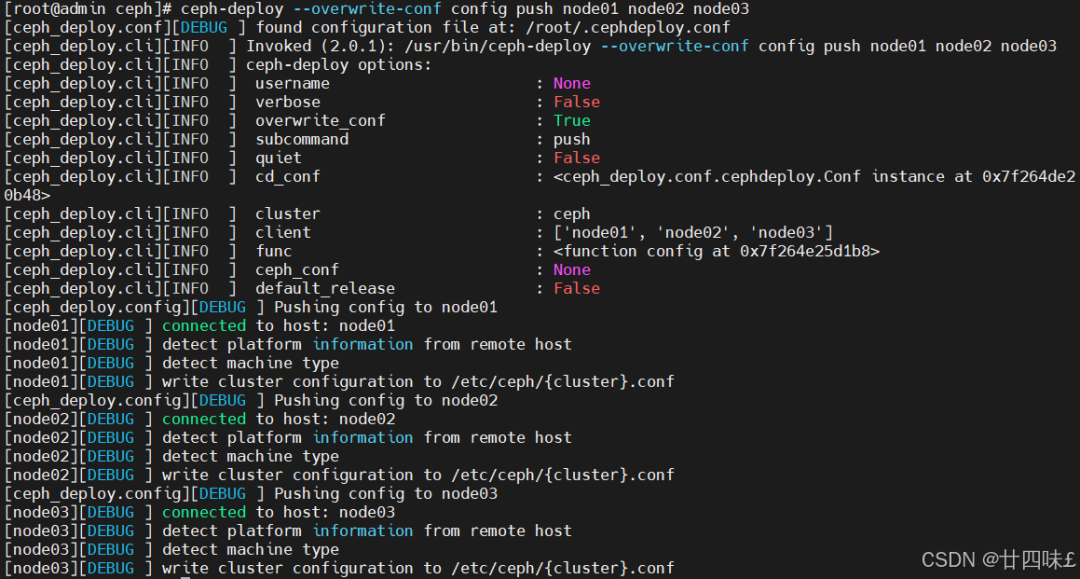

6.部署能夠管理 Ceph 集群的節點(可選)

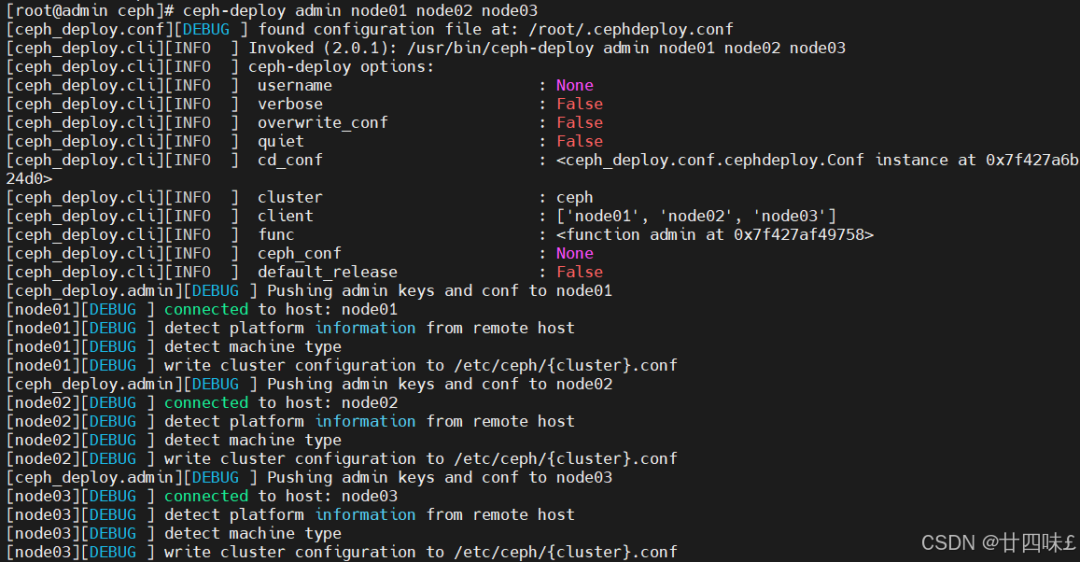

#可實現在各個節點執行 ceph 命令管理集群

cd /etc/ceph

ceph-deploy --overwrite-conf config push node01 node02 node03 #向所有 mon 節點同步配置,確保所有 mon 節點上的 ceph.conf 內容必須一致

ceph-deploy admin node01 node02 node03 #本質就是把 ceph.client.admin.keyring 集群認證文件拷貝到各個節點

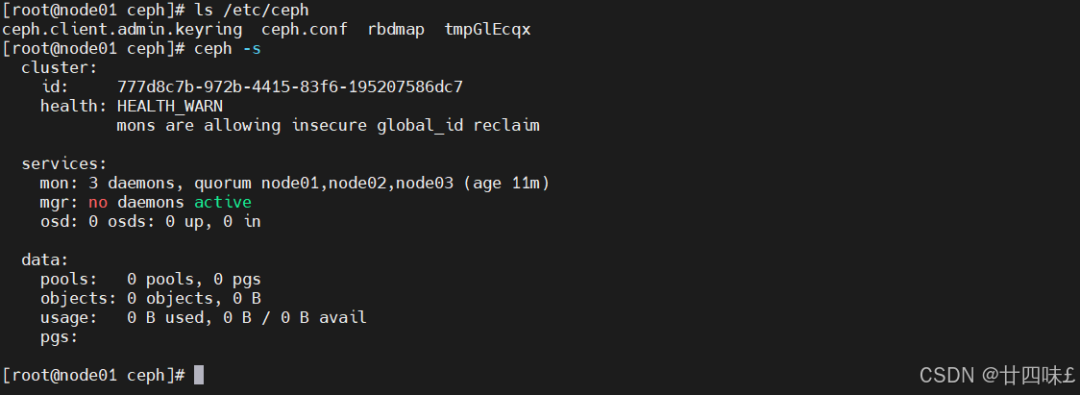

#在 mon 節點上查看

ls /etc/ceph

ceph.client.admin.keyring ceph.conf rbdmap tmpr8tzyc

cd /etc/ceph

ceph -s

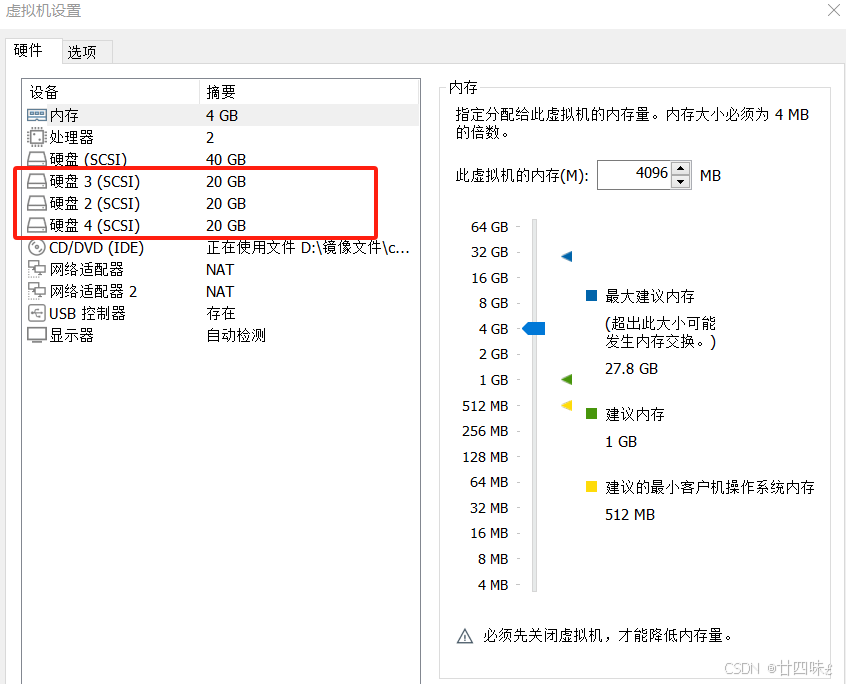

7.部署 osd 存儲節點

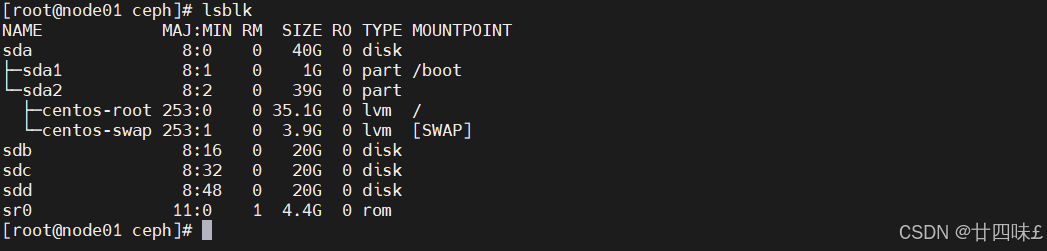

#主機添加完硬盤后不要分區,直接使用

lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 60G 0 disk

├─sda1 8:1 0 500M 0 part /boot

├─sda2 8:2 0 4G 0 part [SWAP]

└─sda3 8:3 0 55.5G 0 part /

sdb 8:16 0 20G 0 disk

sdc 8:32 0 20G 0 disk

sdd 8:48 0 20G 0 disk

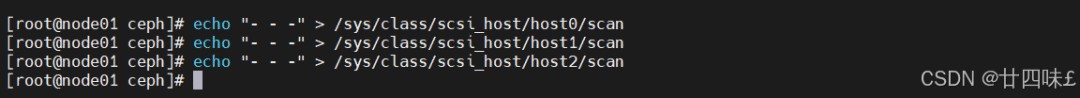

使用命令刷新硬盤

echo "- - -" > /sys/class/scsi_host/host0/scan

echo "- - -" > /sys/class/scsi_host/host1/scan

echo "- - -" > /sys/class/scsi_host/host2/scan

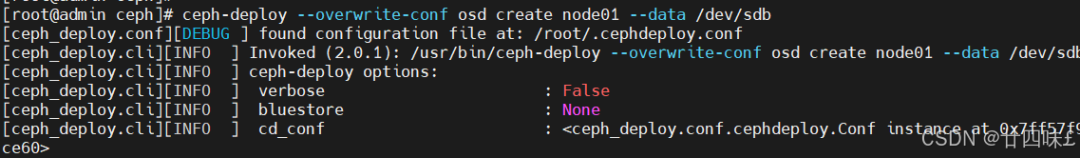

#如果是利舊的硬盤,則需要先擦凈(刪除分區表)磁盤(可選,無數據的新硬盤可不做)cd/etc/cephceph-deploy disk zap node01 /dev/sdbceph-deploy disk zap node02 /dev/sdbceph-deploy disk zap node03 /dev/sdb #添加 osd 節點ceph-deploy --overwrite-conf osd create node01 --data /dev/sdbceph-deploy --overwrite-conf osd create node02 --data /dev/sdbceph-deploy --overwrite-conf osd create node03 --data /dev/sdb

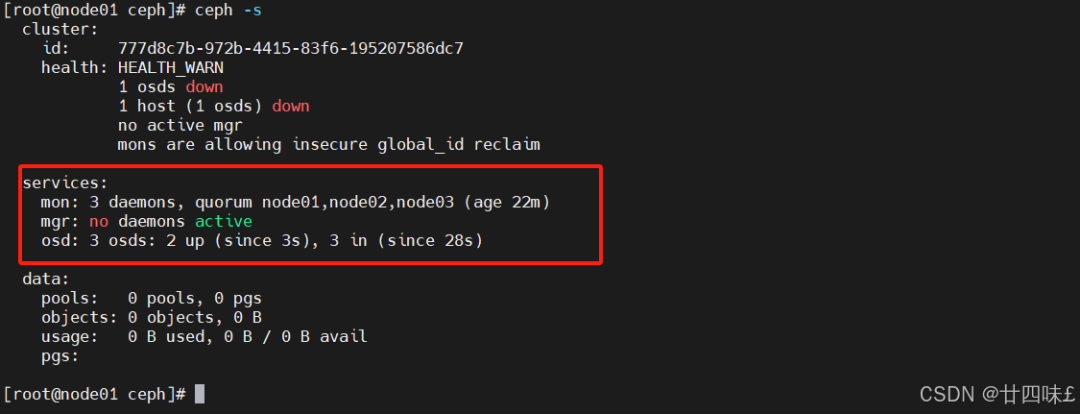

#查看 ceph 集群狀態

ceph-s cluster: id: 7e9848bb-909c-43fa-b36c-5805ffbbeb39 health: HEALTH_WARN no avtive mgr services: mon:3daemons, quorum node01,node02,node03 (age119m) mgr: no daemons active osd:3osds:3up (since35s),3in (since35s) data: pools: 0pools,0pgs objects:0objects,0B usage: 3.0GiB used,57GiB /60GiB avail pgs:

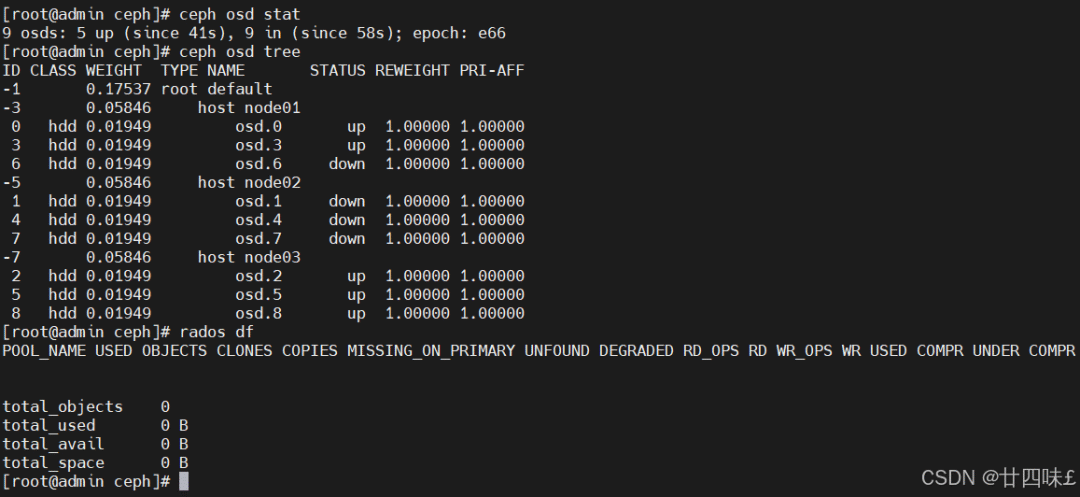

ceph osd stat

ceph osd tree

rados df

ssh root@node01 systemctl status ceph-osd@0

ssh root@node02 systemctl status ceph-osd@1

ssh root@node03 systemctl status ceph-osd@2

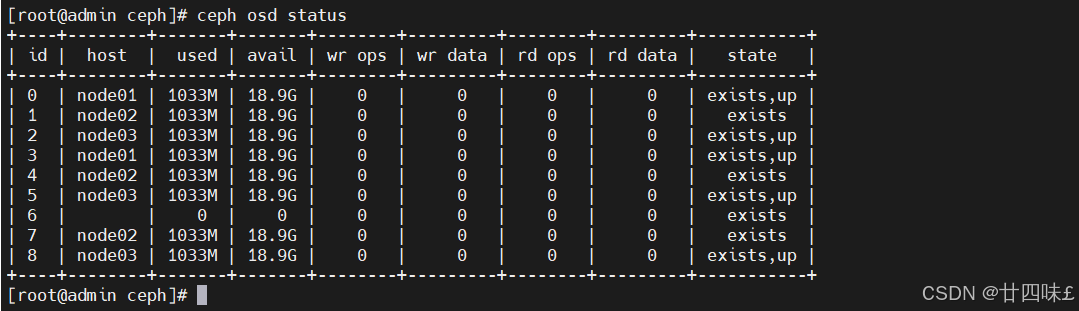

ceph osd status #查看 osd 狀態,需部署 mgr 后才能執行 +----+--------+-------+-------+--------+---------+--------+---------+-----------+| id | host | used | avail | wr ops | wr data | rd ops | rd data | state |+----+--------+-------+-------+--------+---------+--------+---------+-----------+|0 | node01 |1025M |18.9G | 0 | 0 | 0 | 0 |exists,up ||1 | node02 |1025M |18.9G | 0 | 0 | 0 | 0 |exists,up ||2 | node03 |1025M |18.9G | 0 | 0 | 0 | 0 |exists,up |+----+--------+-------+-------+--------+---------+--------+---------+-----------+

?

?

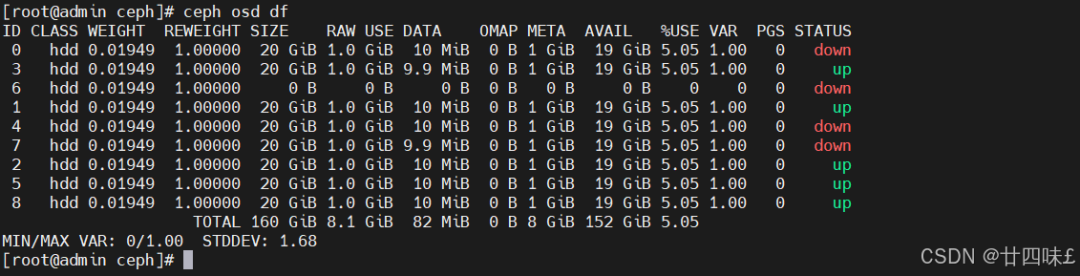

cephosd df #查看 osd 容量,需部署 mgr 后才能執行ID CLASS WEIGHT REWEIGHT SIZE RAW USE DATA OMAP META AVAIL %USE VAR PGS STATUS 0 hdd0.019491.0000020GiB1.0GiB1.8MiB 0B1GiB19GiB5.011.00 0 up 1 hdd0.019491.0000020GiB1.0GiB1.8MiB 0B1GiB19GiB5.011.00 0 up 2 hdd0.019491.0000020GiB1.0GiB1.8MiB 0B1GiB19GiB5.011.00 0 up TOTAL60GiB3.0GiB5.2MiB 0B3GiB57GiB5.01 MIN/MAX VAR:1.00/1.00 STDDEV:0

#擴容 osd 節點cd /etc/cephceph-deploy--overwrite-confosd create node01--data/dev/sdcceph-deploy--overwrite-confosd create node02--data/dev/sdcceph-deploy--overwrite-confosd create node03--data/dev/sdcceph-deploy--overwrite-confosd create node01--data/dev/sddceph-deploy--overwrite-confosd create node02--data/dev/sddceph-deploy--overwrite-confosd create node03--data/dev/sdd

添加 OSD 中會涉及到 PG 的遷移,由于此時集群并沒有數據,因此 health 的狀態很快就變成 OK,如果在生產環境中添加節點則會涉及到大量的數據的遷移。

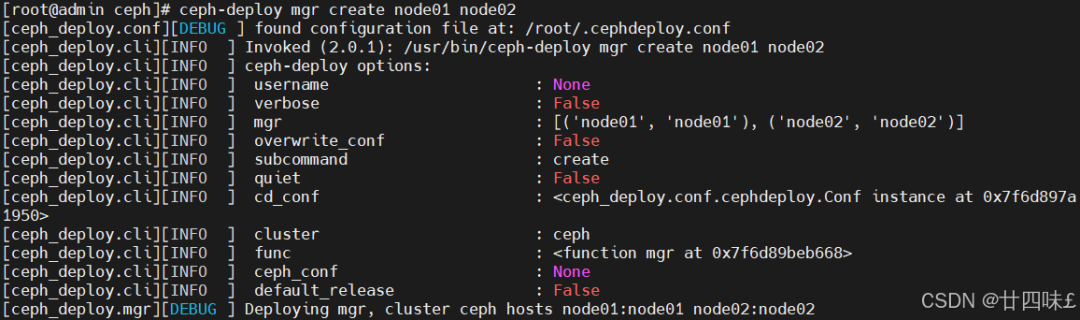

8.部署 mgr 節點

#ceph-mgr守護進程以Active/Standby模式運行,可確保在Active節點或其ceph-mgr守護進程故障時,其中的一個Standby實例可以在不中斷服務的情況下接管其任務。根據官方的架構原則,mgr至少要有兩個節點來進行工作。

cd /etc/ceph

ceph-deploy mgr create node01 node02

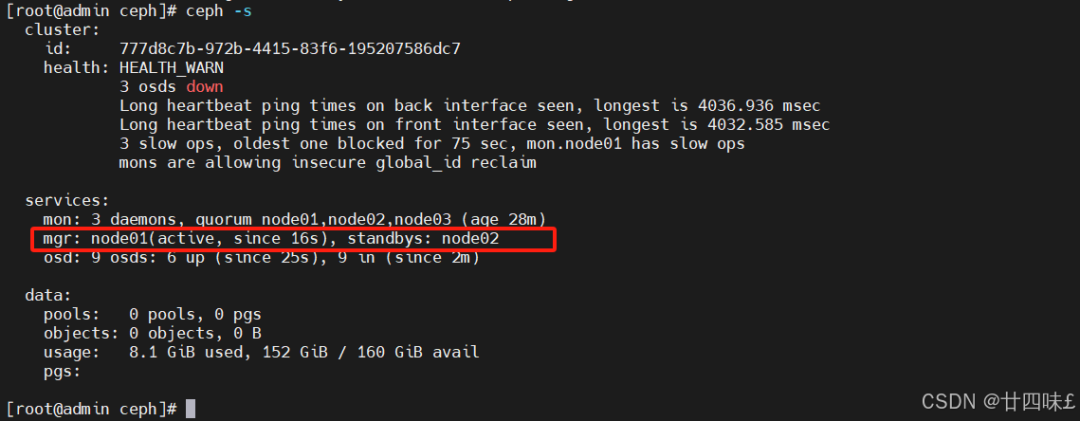

ceph -s

cluster:

id: 7e9848bb-909c-43fa-b36c-5805ffbbeb39

health: HEALTH_WARN

mons are allowing insecure global_id reclaim

services:

mon: 3 daemons, quorum node01,node02,node03

mgr: node01(active, since 10s), standbys: node02

osd: 0 osds: 0 up, 0 in

#解決 HEALTH_WARN 問題:mons are allowing insecure global_id reclaim問題:

禁用不安全模式:ceph config set mon auth_allow_insecure_global_id_reclaim false

#擴容 mgr 節點

ceph-deploy mgr create <節點名稱>

9.開啟監控模塊

#在 ceph-mgr Active節點執行命令開啟

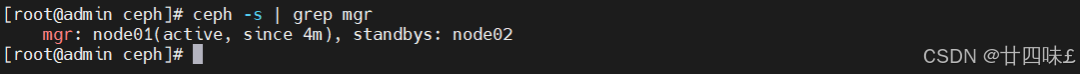

ceph -s | grep mgr

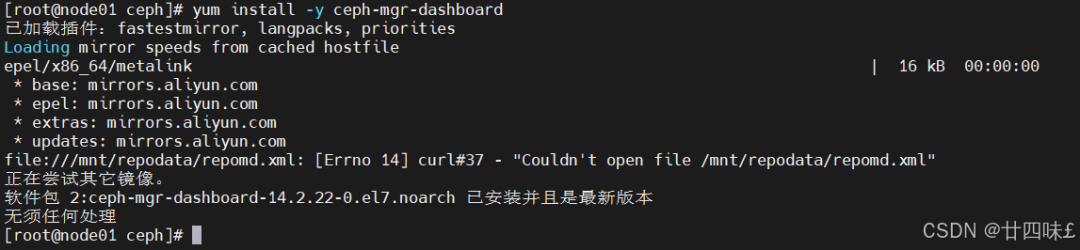

yum install -y ceph-mgr-dashboard

cd /etc/ceph

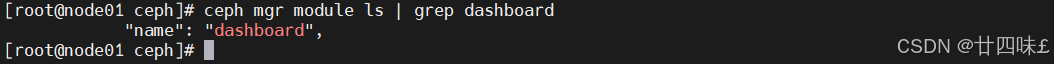

ceph mgr module ls | grep dashboard

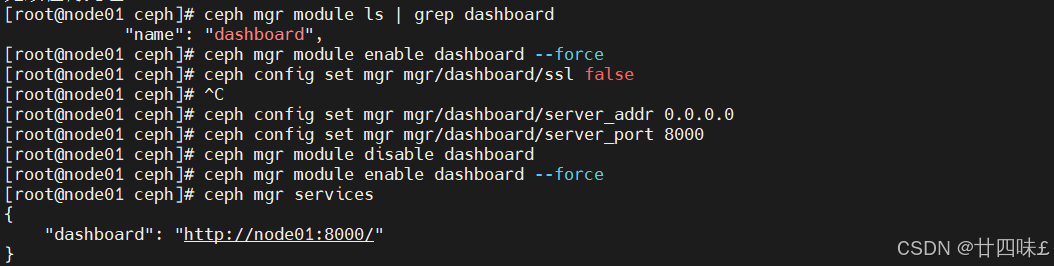

#開啟 dashboard 模塊 ceph mgr moduleenabledashboard --force #禁用 dashboard 的 ssl 功能 ceph configsetmgr mgr/dashboard/sslfalse #配置 dashboard 監聽的地址和端口 ceph configsetmgr mgr/dashboard/server_addr 0.0.0.0ceph configsetmgr mgr/dashboard/server_port 8000 #重啟 dashboardceph mgr module disable dashboardceph mgr module enable dashboard --force #確認訪問 dashboard 的 urlceph mgr services

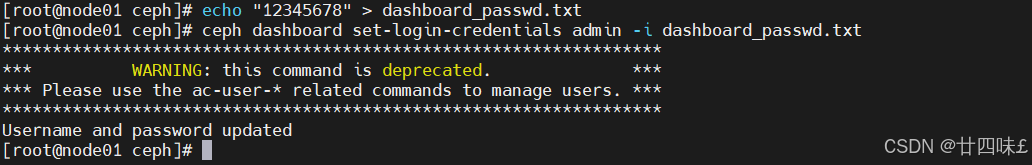

#設置 dashboard 賬戶以及密碼

echo "12345678" > dashboard_passwd.txt

ceph dashboard set-login-credentials admin -i dashboard_passwd.txt

或

ceph dashboard ac-user-create admin administrator -i dashboard_passwd.txt

-

接口

+關注

關注

33文章

8839瀏覽量

152769 -

存儲

+關注

關注

13文章

4451瀏覽量

86756 -

磁盤

+關注

關注

1文章

386瀏覽量

25488 -

Ceph

+關注

關注

1文章

23瀏覽量

9494

原文標題:史上最全的Ceph介紹、原理、架構

文章出處:【微信號:magedu-Linux,微信公眾號:馬哥Linux運維】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

分布式存儲架構:第十一節 Ceph 功能優勢??#分布式存儲?#大數據?#ceph分布式存儲?#硬聲創作季

分布式存儲架構:第十一節 Ceph 功能優勢??#分布式存儲?#大數據?#ceph分布式存儲?#硬聲創作季

分布式存儲架構:第十二節 Ceph 應用場景??#分布式存儲?#大數據?#ceph分布式存儲?#硬聲創作季

Ceph是什么?Ceph的統一存儲方案簡析

分布式存儲中HDFS與Ceph兩者的區別是什么,各有什么優勢?

常見的分布式文件存儲系統的優缺點

云存儲中的Ceph分布式文件系統及節點選擇

評論