日前,加州大學的研究人員攜手英偉達,共同推出了一款創新的視覺語言模型——NaVILA。該模型在機器人導航領域展現出了獨特的應用潛力,為智能機器人的自主導航提供了一種全新的解決方案。

視覺語言模型(VLM)是一種具備多模態生成能力的先進AI模型。它能夠智能地處理文本、圖像以及視頻等多種提示,并通過復雜的推理過程,實現對這些信息的準確理解和應用。NaVILA正是基于這一原理,通過將大型語言模型(LLM)與視覺編碼器進行巧妙的結合,從而賦予了LLM“視覺感知”的神奇能力。

這一創新性的結合,使得NaVILA在機器人導航領域展現出了卓越的性能。它能夠根據環境中的視覺信息,結合文本指令或描述,為機器人提供精確的定位和導航服務。這一特性不僅提高了機器人的自主性和智能化水平,還為機器人在復雜環境中的應用提供了更加廣闊的空間。

NaVILA的發布,標志著視覺語言模型在機器人導航領域取得了重要的突破。未來,隨著技術的不斷發展和完善,相信NaVILA將在更多領域展現出其獨特的價值和潛力,為人工智能技術的發展和應用貢獻更多的力量。

-

機器人

+關注

關注

211文章

28476瀏覽量

207414 -

語言模型

+關注

關注

0文章

527瀏覽量

10289 -

英偉達

+關注

關注

22文章

3783瀏覽量

91248

發布評論請先 登錄

相關推薦

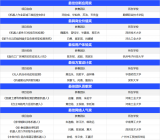

英偉達Blackwell可支持10萬億參數模型AI訓練,實時大語言模型推理

英偉達推出Eagle系列模型

英偉達推出Flextron AI框架:賦能靈活高效的AI模型部署

商湯科技與泰國DTGO集團聯合發布泰語大模型

NaVILA:加州大學與英偉達聯合發布新型視覺語言模型

NaVILA:加州大學與英偉達聯合發布新型視覺語言模型

評論