在TensorFlow中實現反卷積(也稱為轉置卷積或分數步長卷積)是一個涉及多個概念和步驟的過程。反卷積在深度學習領域,特別是在圖像分割、圖像超分辨率、以及生成模型(如生成對抗網絡GANs)等任務中,扮演著重要角色。以下將詳細闡述如何在TensorFlow中實現反卷積,包括其理論基礎、TensorFlow中的實現方式、以及實際應用中的注意事項。

一、理論基礎

1.1 卷積與反卷積的基本概念

- 卷積 :在圖像處理中,卷積是一種通過滑動窗口(卷積核)對圖像進行局部加權求和的操作,常用于特征提取。卷積操作會導致特征圖尺寸減小(如果步長大于1或不進行適當填充)。

- 反卷積 :反卷積并不是卷積的直接逆操作,因為它不能恢復卷積過程中丟失的信息(如絕對位置信息)。然而,反卷積可以通過特定的參數設置(如步長小于輸入特征圖尺寸),實現特征圖尺寸的增加,從而在某些應用場景下模擬“逆卷積”的效果。

1.2 反卷積的實現方式

- 分數步長卷積 :通過設置卷積的步長小于1(在TensorFlow中通常通過插值實現等效效果),可以實現特征圖尺寸的增加。

- 轉置卷積 :在矩陣運算的視角下,卷積操作可以看作是一個稀疏矩陣與輸入特征圖的乘積。反卷積則是這個乘積的轉置矩陣與輸出特征圖的乘積,通過調整這個轉置矩陣的形狀和步長,可以實現上采樣效果。

二、TensorFlow中的實現

在TensorFlow中,反卷積通常通過tf.nn.conv2d_transpose函數實現,該函數允許用戶指定輸出特征圖的尺寸、卷積核的大小、步長和填充方式,從而實現反卷積操作。

2.1 函數參數詳解

input:輸入的特征圖,四維張量,形狀為[batch_size, height, width, in_channels]。filter:卷積核,四維張量,形狀為[height, width, out_channels, in_channels]。output_shape:輸出特征圖的形狀,四維張量,形狀為[batch_size, height', width', out_channels]。注意,這里的batch_size可以是-1,表示自動計算。strides:卷積操作的步長,四維列表,通常為[1, stride_height, stride_width, 1]。padding:填充方式,可以是'VALID'或'SAME'。'SAME'表示輸出特征圖的高度和寬度能被步長整除時,會在邊緣進行適當填充以保持尺寸;'VALID'則不進行填充。- 其他參數包括數據格式、卷積核的初始化等,可根據具體需求設置。

2.2 示例代碼

import tensorflow as tf

# 假設輸入特征圖

input_shape = [1, 4, 4, 1] # [batch_size, height, width, in_channels]

input_tensor = tf.random.normal(input_shape)

# 定義卷積核

kernel_shape = [3, 3, 1, 2] # [height, width, in_channels, out_channels]

kernel = tf.random.normal(kernel_shape)

# 設置反卷積參數

strides = [1, 2, 2, 1] # 步長為2,用于上采樣

output_shape = [1, 8, 8, 2] # 期望的輸出特征圖尺寸

# 執行反卷積操作

output_tensor = tf.nn.conv2d_transpose(

input=input_tensor,

filters=kernel,

output_shape=output_shape,

strides=strides,

padding='SAME'

)

print(output_tensor.shape) # 應為(1, 8, 8, 2)

三、實際應用中的注意事項

3.1 棋盤效應

在某些配置下(特別是步長不為1且卷積核大小不是步長的整數倍時),反卷積操作可能會產生明顯的棋盤狀偽影。這通常是由于卷積核的周期性采樣導致的。為了減輕這種效應,可以嘗試調整卷積核大小、步長或填充方式。

3.2 參數調整

反卷積的參數調整對于實現高質量的上采樣效果至關重要。除了前面提到的步長(strides)和填充(padding)之外,卷積核(filter)的大小和初始化方式也對輸出結果的質量有著顯著影響。

- 卷積核大小 :卷積核的大小決定了反卷積操作時的感受野大小,進而影響上采樣結果的平滑度和細節保留程度。較大的卷積核能夠捕獲更多的上下文信息,但也可能導致計算量增加和過平滑。相反,較小的卷積核計算效率更高,但可能無法充分恢復細節。

- 初始化方式 :卷積核的初始化方式對于訓練過程的穩定性和收斂速度至關重要。在TensorFlow中,可以使用

tf.keras.initializers中的不同初始化器來初始化卷積核,如隨機正態分布(RandomNormal)、均勻分布(RandomUniform)或Glorot/He初始化器等。選擇合適的初始化器可以幫助模型更快地收斂到較好的解。

3.3 激活函數

在反卷積層之后,通常會跟隨一個激活函數來增加模型的非線性。在圖像生成和分割任務中,常用的激活函數包括ReLU、LeakyReLU、sigmoid和tanh等。選擇合適的激活函數取決于具體任務和模型架構的需求。

- ReLU及其變體 :ReLU(Rectified Linear Unit)及其變體(如LeakyReLU)在大多數深度學習模型中都很常見,因為它們能夠加速訓練過程并緩解梯度消失問題。然而,在需要輸出范圍在特定區間(如[0, 1])的任務中,ReLU可能不是最佳選擇。

- sigmoid和tanh :sigmoid和tanh激活函數能夠將輸出限制在特定范圍內(sigmoid為[0, 1],tanh為[-1, 1]),這在需要概率輸出或歸一化輸出的任務中非常有用。然而,它們也可能導致梯度消失問題,特別是在深層網絡中。

3.4 批量歸一化(Batch Normalization)

在反卷積層之后加入批量歸一化層可以幫助加速訓練過程,提高模型泛化能力,并減少過擬合的風險。批量歸一化通過對每個小批量數據的輸出進行歸一化處理,使得每層的輸入數據具有相同的分布,從而加快訓練收斂速度。

3.5 實際應用場景

反卷積在多個實際應用場景中發揮著重要作用:

- 圖像分割 :在圖像分割任務中,反卷積通常用于構建編碼器-解碼器架構中的解碼器部分,以恢復輸入圖像的空間分辨率并生成分割圖。

- 圖像超分辨率 :在圖像超分辨率任務中,反卷積用于將低分辨率圖像上采樣到高分辨率,同時保持或增強圖像的細節。

- 生成對抗網絡(GANs) :在GANs中,生成器通常包含多個反卷積層,用于從隨機噪聲向量生成逼真的圖像。反卷積層幫助生成器逐步增加圖像的分辨率和細節。

四、結論

在TensorFlow中實現反卷積是一個涉及多個步驟和參數調整的過程。通過理解反卷積的理論基礎、掌握TensorFlow中的實現方式以及注意實際應用中的關鍵事項,我們可以有效地利用反卷積技術來實現高質量的圖像上采樣和其他相關任務。未來隨著深度學習技術的不斷發展,反卷積技術也將繼續演進和完善,為更多領域的應用提供有力支持。

-

函數

+關注

關注

3文章

4365瀏覽量

63837 -

反卷積

+關注

關注

0文章

4瀏覽量

6333 -

tensorflow

+關注

關注

13文章

330瀏覽量

60928

發布評論請先 登錄

相關推薦

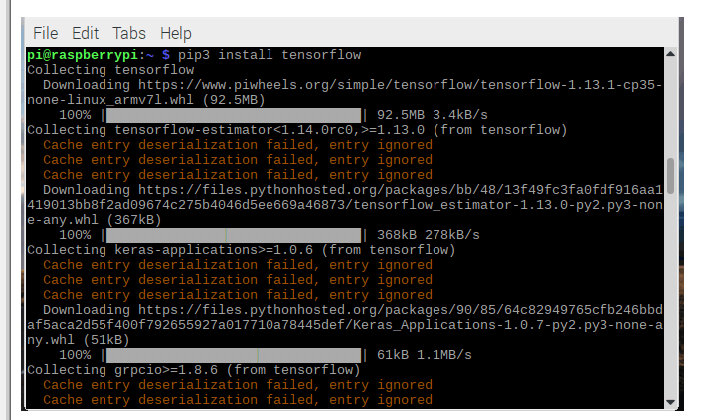

如何在Raspberry Pi上安裝TensorFlow

急求用matlab實現卷積的編程

關于對信號的反卷積問題

TensorFlow是什么

反卷積deconvolution引起的棋盤效應及存在的弊端

LED光譜測量值的反卷積

CNN誤差反傳時旋轉卷積核的簡明分析

深入理解深度學習中的反(轉置)卷積

評論