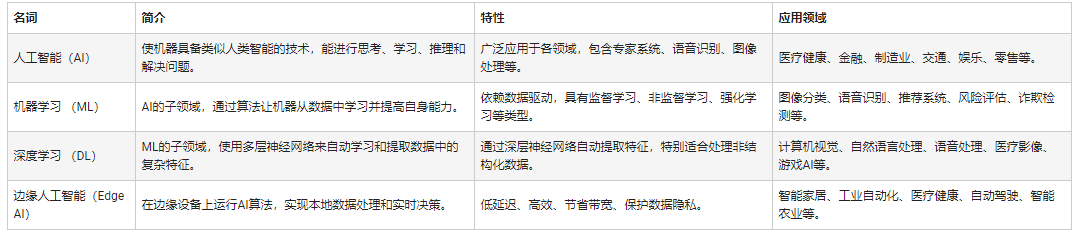

機器學習(ML)和深度學習(DL)技術正在迅速推動傳感技術的發展,顯著提升了其準確性、靈敏度和適應性。這些進步正在對包括工業自動化、機器人、生物醫學工程和民用基礎設施監測等在內的諸多領域產生重大影響。這種變革性轉變的核心在于人工智能(AI)與傳感器技術的緊密融合,著重于開發高效算法,以推動器件性能的提升并在各類生物醫學和工程領域加速新應用場景的落地。機器學習/深度學習技術對傳感技術的貢獻主要分為四個方面:傳感器設計、校準和補償、目標識別和分類、行為預測。

據麥姆斯咨詢報道,近日,浙江大學的科研團隊深入研究了機器學習/深度學習算法與傳感器技術的融合,揭示了它們對傳感器設計、校準和補償、目標識別以及行為預測所產生的深遠影響。通過一系列示例應用,這項研究展示了人工智能算法在顯著升級傳感器功能和擴大其應用范圍方面的潛力。此外,該研究還探討了在利用這些技術進行傳感應用時所面臨的挑戰,并對未來趨勢和潛在進展提出了見解。這篇綜述以“AI-Driven Sensing Technology: Review”為主題發表在Sensors期刊上。Long Chen和Chenbin Xia為該論文的共同第一作者,付浩然特聘研究員為通訊作者。

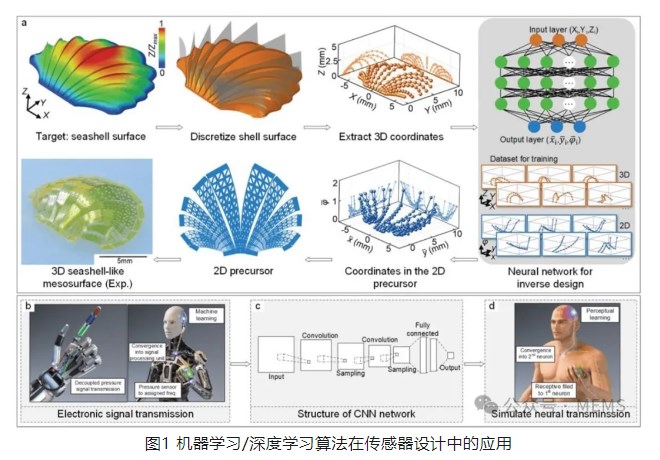

機器學習/深度學習輔助傳感器設計

機器學習/深度學習主要通過兩個方面輔助傳感器設計。首先,開發了如人工神經網絡等逆向工程模型,以根據所需性能結果來設計目標傳感器的幾何架構。其次,在設計過程中,利用卷積神經網絡(CNN)等算法優化傳感器性能,解決諸如測量范圍小、信噪比低以及精度不足等問題。

將人工智能方法融入傳感器的設計過程,可以縮短設計時間、降低計算成本,同時最大限度地減少迭代,從而快速開發出滿足特定環境或功能需求的架構。此外,將機器學習/深度學習算法集成到信號處理階段可以顯著改善關鍵參數。然而,人工智能在傳感器設計中的作用面臨著挑戰,包括為促進設計的人工智能算法需要大量訓練。此外,由于算法無法解釋器件的多場響應的復雜相互作用,導致其無法預測性能隨時間發生的變化,例如老化,因此預先訓練的模型有過時的風險。這凸顯了人工智能驅動的傳感器設計在通用性方面的局限性。

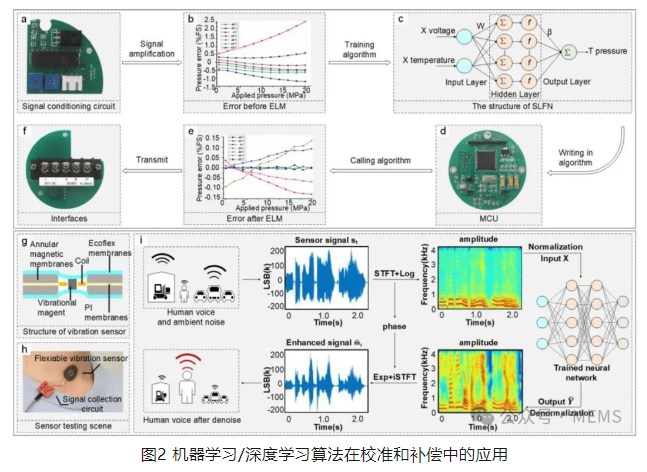

校準和補償

在工作過程中,傳感器經常會因電壓波動、溫度變化或其它環境因素而出現信號漂移,從而導致測量結果失真。為了解決這一問題,機器學習/深度學習算法采用了兩種策略:首先,在校準過程中采用極限學習機(ELM)和多層感知機(MLP)等算法來考慮各種環境因素的影響,從而減少重復校準測試的需求,縮短校準時間,并提高精度;其次,在使用過程中引入多層感知機和卷積神經網絡等算法,自動補償環境中遇到的各種干擾。

人工智能算法可以在傳感器校準過程中減少因環境變化、電壓波動和其他因素造成的誤差,或者在傳感器使用過程中自動補償因環境變化、電壓波動和器件老化等因素造成的誤差。然而,人工智能在校準和自動補償中的應用面臨著一些挑戰。機器學習/深度學習模型的本質是黑箱模型,難以定量解釋導致器件漂移的各種因素的比例,從而限制了對傳感器設計改進的指導。此外,機器學習/深度學習模型訓練通常需要大量的數據和計算資源,而且模型的有限通用性可能導致其在新環境中表現不佳。

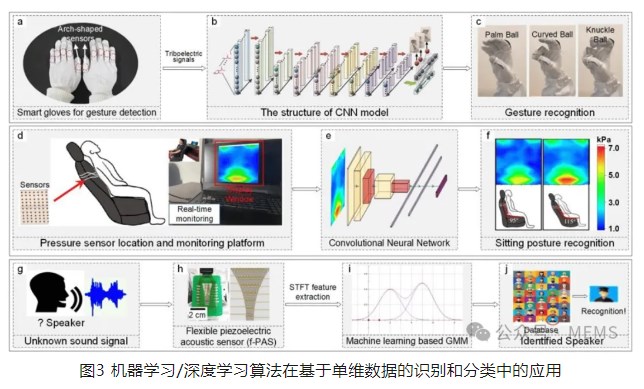

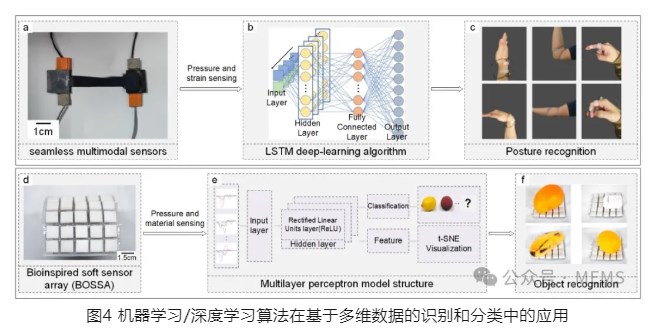

識別和分類

在傳感器應用中,人工智能不僅僅局限于信號收集,還能夠對目標和應用場景進行識別和分類。人工智能輔助識別和分類流程通常包括傳感器的數據收集、特征提取、特征匹配和識別。通過采用隨機森林(RF)、K-最近鄰(KNN)、支持向量機(SVM)和深度信念網絡(DBN)等算法,可以縮短識別中的決策時間,提高準確性,降低人工識別成本,并且最大限度地減少環境干擾,從而實現更精確的特征提取。應用場景的復雜性決定了對傳感器信息的需求;例如,語音識別可以僅通過振動信號實現,而運動識別通常需要結合視覺和壓力傳感器的信號。

機器學習/深度學習算法在識別和分類中的應用范圍很廣,包括機器人感知、目標識別、行為識別、健康監測、身份驗證和機械故障檢測。

在人類行為識別、目標識別或故障監測等實際應用中,僅依靠單一類型的信號數據進行分析可能會導致準確性問題或適用性受限。利用人工智能融合和分析來自傳感器的各種信號類型的數據,可以提高識別的準確性。

將人工智能用于識別和分類中可以提高準確率,減少環境因素造成的誤差,即使在處理復雜任務時也能保持較高的響應速度。然而,機器學習/深度學習模型需要大量的訓練數據,但是從傳感器數據中獲取的樣本有限,可能導致模型過度擬合。此外,樣本的稀缺性使得確定最合適的模型架構(如最佳層數和參數)變得更加復雜。

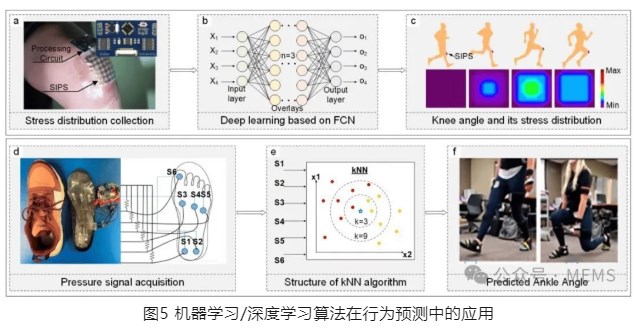

行為預測

利用傳感器收集的數據來預測未來行為是人工智能在傳感技術中的重要應用。將行為預測與預警系統相結合,可以顯著降低事故發生的可能性。

將人工智能與傳感器相結合來進行預測,可以提高預測的準確性和實時性,即使在復雜、非線性的情況下也是如此。然而,這些預測都是基于監測數據而非機理分析模型。因此,針對未知數據或場景進行預測時,模型的準確性和靈敏度無法保證,這對機器學習/深度學習模型的通用性和穩定性提出了很高的要求。

綜上所述,這項研究全面概述了機器學習/深度學習算法輔助傳感技術的增強和工程應用。這顯著提高了傳感器的準確性和對環境變化的適應性。盡管,機器學習/深度學習輔助的傳感技術取得了重大進展,但仍然存在一些挑戰,這為未來研究提供了機遇。為了解決這些問題,有必要在數據收集過程中采用數據增強(data augmentation)和對抗性訓練等技術,以優化數據集的質量和數量。此外,在模型訓練過程中引入噪聲和干擾可以提高模型對未知數據的通用性。此外,開發多場耦合模擬方法對于提高數值數據的全面性和準確性,同時增強機器學習/深度學習模型的可解釋性來說至關重要。最后,需要通過推進模型壓縮和邊緣計算技術的發展來降低模型復雜性,并將某些模型計算任務從傳感器端卸載,從而降低傳感器功耗。

論文鏈接:

https://doi.org/10.3390/s24102958

審核編輯:劉清

-

傳感器

+關注

關注

2560文章

52158瀏覽量

761468 -

人工智能

+關注

關注

1804文章

48418瀏覽量

244711 -

機器學習

+關注

關注

66文章

8478瀏覽量

133819 -

AI驅動

+關注

關注

0文章

62瀏覽量

4262

原文標題:綜述:人工智能(AI)驅動的傳感技術發展

文章出處:【微信號:MEMSensor,微信公眾號:MEMS】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

評論