IBM 的新型模擬內存芯片證明了 AI 操作的性能和能源效率都是可能的。

8 月,由 30 名 IBM 研究科學家組成的團隊推出了一款全新芯片,旨在大幅提高耗電深度學習推理的能源效率,同時保持運算精度。這款名為 Hermes 的模擬內存芯片將數字電路與相變內存 (PCM) 相結合,因此神經網絡計算可以在內存電路內進行。

這種處理器和內存配對消除了在內存和處理單元之間無休止地洗牌大量數據的需要,就像典型的人工智能加速器芯片中發生的那樣。重要的是,分析表明該芯片與計算機視覺人工智能任務的數字芯片一樣擅長,而且功耗卻低得多。

率先推出該芯片的 IBM 歐洲研究院團隊負責人 Abu Sebastian 及其同事 Manuel Le Gallo-Bourdeau 和 Vijay Narayanan 在最近的博客中明確表示,他們現在已經展示了實現快速、低功耗模擬AI芯片的架構愿景所需的許多構建模塊。正如該團隊的一位 IBM 科學家所言,“我們的芯片仍處于研究階段,但我們現在將構建盡可能多的硬件,以準確了解它的功能并了解它的性能。”

耗電的人工智能

人工智能功耗問題的根源在于馮·諾依曼瓶頸,該瓶頸以現代計算機架構的先驅約翰·馮·諾依曼的名字命名。在這里,CPU 和內存是獨立的實體,因此數據和計算必須不斷地在兩者之間來回穿梭。此過程會產生瓶頸,因為處理速度通常比檢索數據或將數據寫入內存的速度更快。

長期以來,設計人員一直在使用內存緩存、流水線和分層內存方案等解決方法來應對瓶頸。最近,芯片巨頭專門開發了加速器芯片來承擔新興的人工智能處理任務。例如,英偉達已經從其 GPU 技術中取得了長足的進步。谷歌開發了張量處理單元;英特爾提供多種解決方案,包括可針對人工智能計算進行編程的 FPGA;高通則為移動設備設計了人工智能加速器芯片。

盡管如此,人工智能的高能耗需求及其不斷增加的操作數量,需要一種更節能的方法,而這正是模擬內存計算似乎將發揮關鍵作用的地方。

模擬內存芯片可以通過直接在內存內執行計算來規避馮·諾依曼瓶頸。模擬計算方案只需要幾個電阻或電容器,因此可以將它們重新定位到存儲器中,消除了存儲器和處理器之間的分離,從而提高了能源效率,遠遠超過了數字芯片。

IBM 在其最新的模擬人工智能芯片中采用了這種方法。該芯片采用 14 nm CMOS 設計和制造,包含 64 個計算核心,每個核心都有自己的 PCM 陣列以及用于額外神經網絡操作(例如激活和累加)的輕型數字處理器。片上通信網絡將核心連接在一起,芯片中心的進一步數字處理單元可以處理更苛刻的神經網絡計算。

盡管使用 PCM 技術使其與眾不同,但 IBM 并不是唯一一家致力于模擬 AI 芯片的公司。例如,英特爾實驗室的研究人員一直在研究靜態隨機存取存儲器和其他技術;美國初創公司Mythic專注于多級閃存;來自斯坦福大學、圣母大學、加州大學圣地亞哥分校和清華大學的研究人員開發了一種神經形態芯片,稱為 NeuRRAM,它使用電阻式隨機存取存儲器。

PCM 是 IBM 的合理選擇,因為該公司至少花了十年時間開發這些用于存儲應用的材料,包括多級 PCM 芯片。PCM 本身是一種非易失性隨機存取存儲器,加熱時會在低導電非晶相和高導電晶相之間切換。基于這些材料的設備可以利用相變,將電導的變化編碼為突觸權重,然后用于計算操作。

正如 IBM 的最新結果所示,這種連續的值(而不僅僅是數字設備中的 1 或 0)非常適合深度神經網絡操作。

當與基于類似技術的其他芯片(包括 NeuRRAM 以及 Mythic 和 TSMC 開發的芯片)進行基準測試時,IBM 的技術可以執行矩陣向量乘法(這是人工智能運算的基礎),速度至少提高 15 倍,并且能效相當。值得注意的是,在使用人工智能訓練彩色圖像數據庫 CIFAR-10 進行測試時,該芯片還被證明在圖像識別方面比其他芯片更準確,挑戰了模擬內存計算雖然節能但容易出現計算錯誤的觀念。

“相變存儲器的優勢在于它足夠穩定,可以進行一些相對準確的計算,”IBM 科學家說。“我們開發了精確編程的技術,并且還詳細描述了錯誤的特征。我們的精度對于神經網絡來說已經足夠了。”

英特爾實驗室研究科學家 Hechen Wang 也多年來一直致力于模擬內存計算,他同意該方法可以實現卓越的能源效率。“研究人員大約五年前開始研究模擬內存,現在 IBM、imec、GlobalFoundries、臺積電、三星和其他公司和學術團體開始研究這項技術,”他說。“如果我們想要進行非常高效的AI計算,我們需要將處理單元放入內存陣列,甚至內存單元中。”

Hechen Wang說,英特爾實驗室正在尋求內存計算的多種途徑,并探索一系列內存技術。“對于哪種記憶才是正確的方向,我們還沒有得出結論。”

盡管如此, Hechen Wang相信 IBM 和其他公司的最新模擬內存開發正在對這個“熱門”領域產生積極影響。“IBM 的研究成果已經發表在 Nature 論文上,說實話,我從來沒想過會發生這種事,”他說。“很多人閱讀了這些出版物,我希望這些結果能夠開闊他們的視野,并吸引更多人對該領域的關注。”

下一步

自從在《自然電子》雜志上發表研究結果以來,IBM 歐洲研究人員明確表示,他們的工作證明模擬 AI 可以提供與傳統數字加速器相媲美的必要計算精度,而且能效更高。隨著基于人工智能的技術的興起,節能且準確的推理硬件變得至關重要,研究人員的目標是創建能夠執行端到端推理操作的模擬內存芯片。

與此同時,IBM 歐洲研究院表示,它打算利用 PCM 設備可達到的高突觸密度,構建更大的芯片,能夠比競爭對手的數字加速器運行整個網絡操作。

IBM 科學家表示:“一旦我們真正展示了這項技術的前景,并且更多的人想要投資(該領域),那么我們就可以組建由數百名研究人員組成的團隊來從事這項工作,這樣我們就可以將芯片投入生產模式。”

審核編輯:劉清

-

處理器

+關注

關注

68文章

19293瀏覽量

229919 -

PCM

+關注

關注

1文章

195瀏覽量

53241 -

人工智能

+關注

關注

1791文章

47314瀏覽量

238599 -

計算機視覺

+關注

關注

8文章

1698瀏覽量

46004 -

AI芯片

+關注

關注

17文章

1887瀏覽量

35040

原文標題:IBM 的AI芯片能否重塑深度學習推理?

文章出處:【微信號:ICViews,微信公眾號:半導體產業縱橫】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

IBM光學技術新進展:光電共封裝提升AI模型效率

虛擬內存對計算機性能的影響

DDR內存頻率對性能的影響

IBM推出高性能AI模型Granite 3.0

《AI for Science:人工智能驅動科學創新》第6章人AI與能源科學讀后感

IBM Cloud將部署英特爾Gaudi 3 AI芯片

HDS-6智能型模擬斷路器使用說明

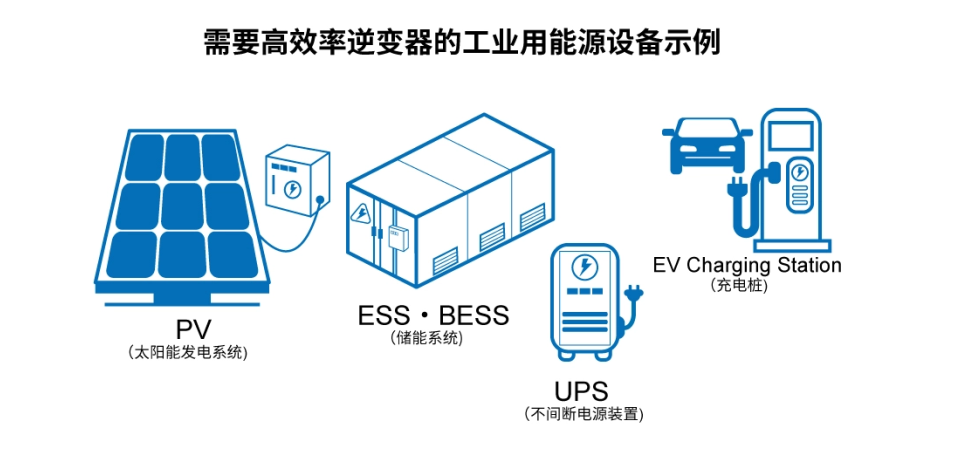

先進的半導體功率元器件和模擬IC助力工業用能源設備節能

IBM的新型模擬內存芯片能否證明AI操作的性能和能源效率呢?

IBM的新型模擬內存芯片能否證明AI操作的性能和能源效率呢?

評論