1. 基本概念

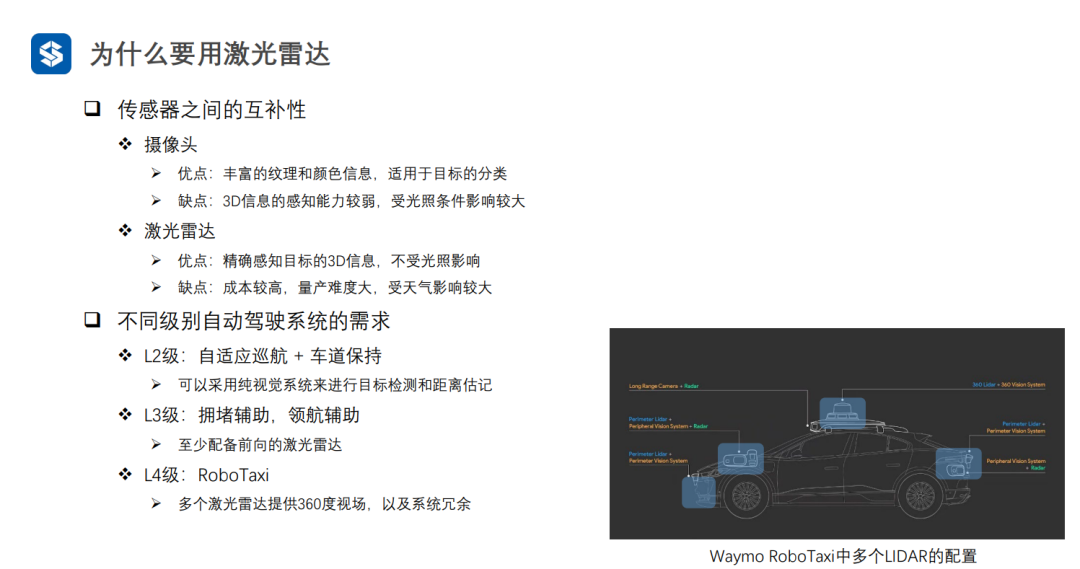

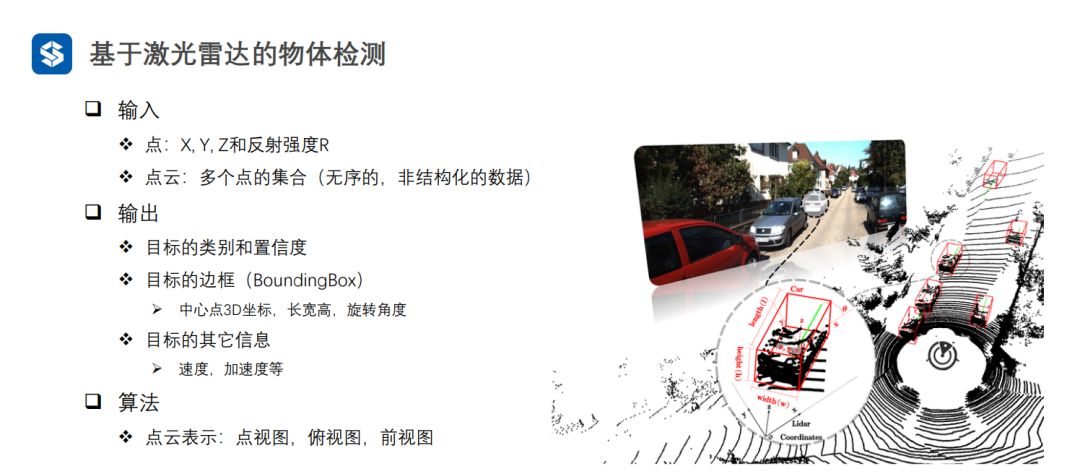

相比于視覺間接地獲取3D信息,激光雷達可以直接獲取目標及場景的3D信息,但是激光雷達不能獲取紋理、顏色等特征,因此激光雷達和相機是互補的

調(diào)頻連續(xù)波是毫米波雷達測距的原理。

隨著自動駕駛級別的提高,對于激光雷達的需求也逐漸提高。

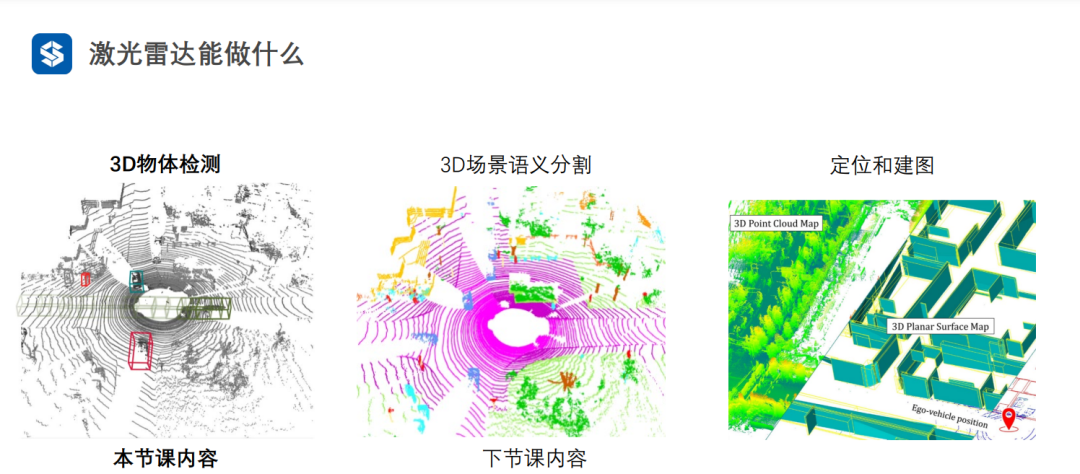

激光雷達不僅可以做到多視圖融合,還能進行多傳感器融合(此時是一個狀態(tài)估計問題,將不同傳感器的感知結(jié)果看成是觀測)。

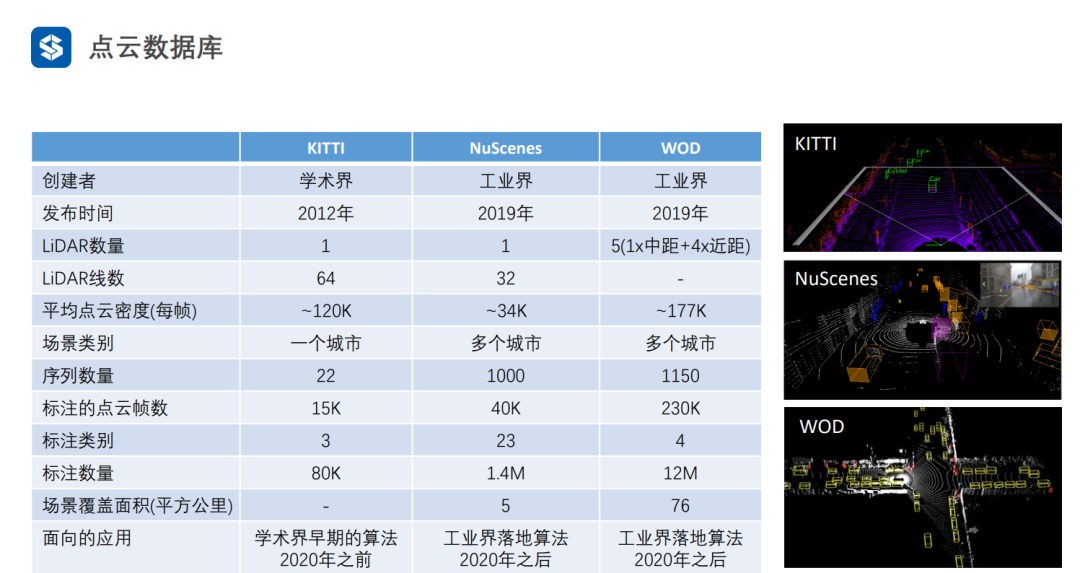

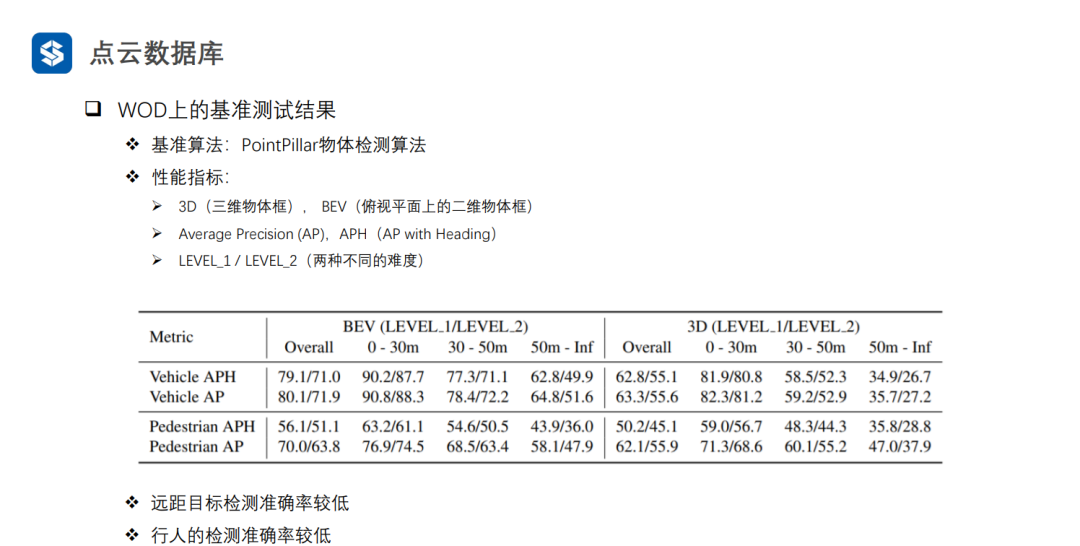

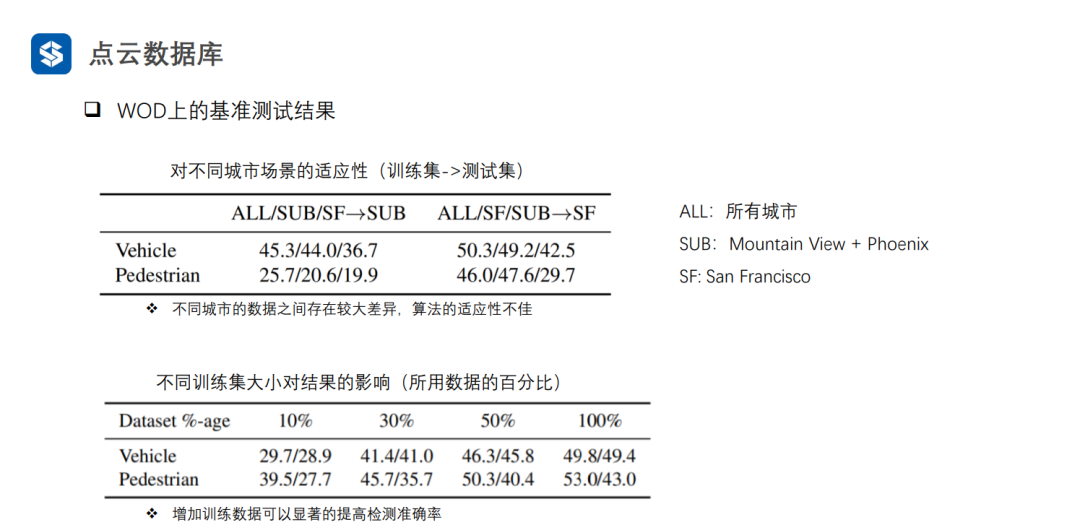

2. 點云數(shù)據(jù)庫

隨著工業(yè)界落地需求的增加,數(shù)據(jù)集的規(guī)模也越來越大。

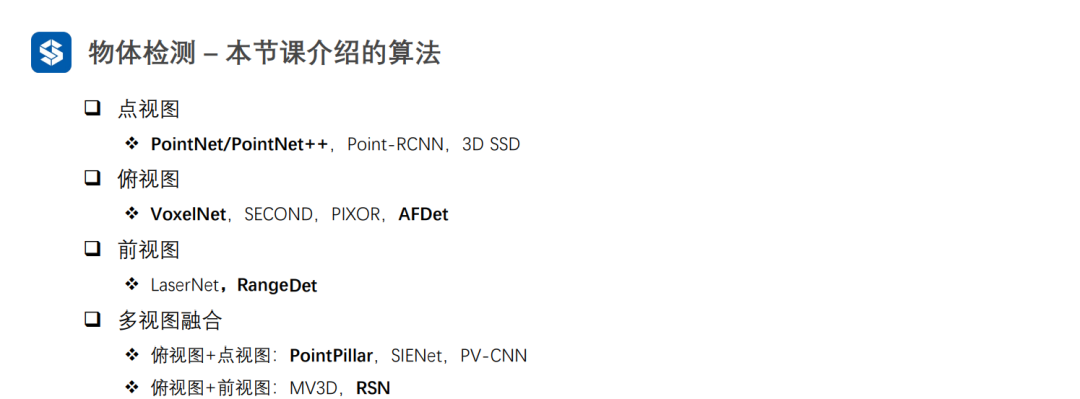

3.1點視圖

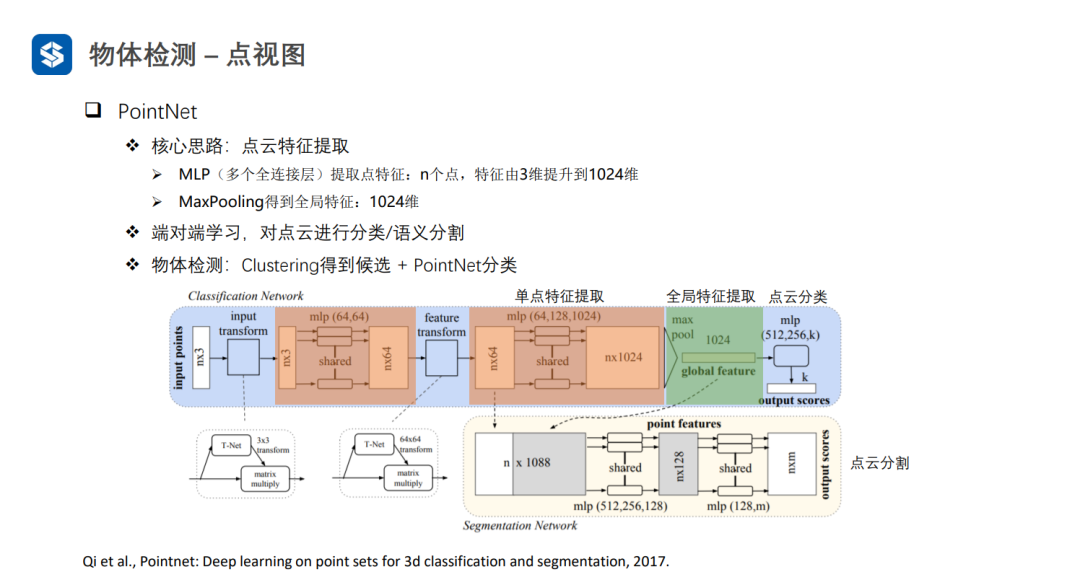

PointNet直接處理無序點云,因此在最后需要借助一個操作(例如max_poolingaverage_pooling)來消除最終的結(jié)果與點云輸入順序間的關(guān)聯(lián)

PointNet++逐層提取特征擴大感受野。PointNet++可以將聚類結(jié)果作為候選框生成的依據(jù):對聚類結(jié)果中的每個點關(guān)聯(lián)一組錨框,并且進行分類與回歸的操作(類似RPN網(wǎng)絡(luò))

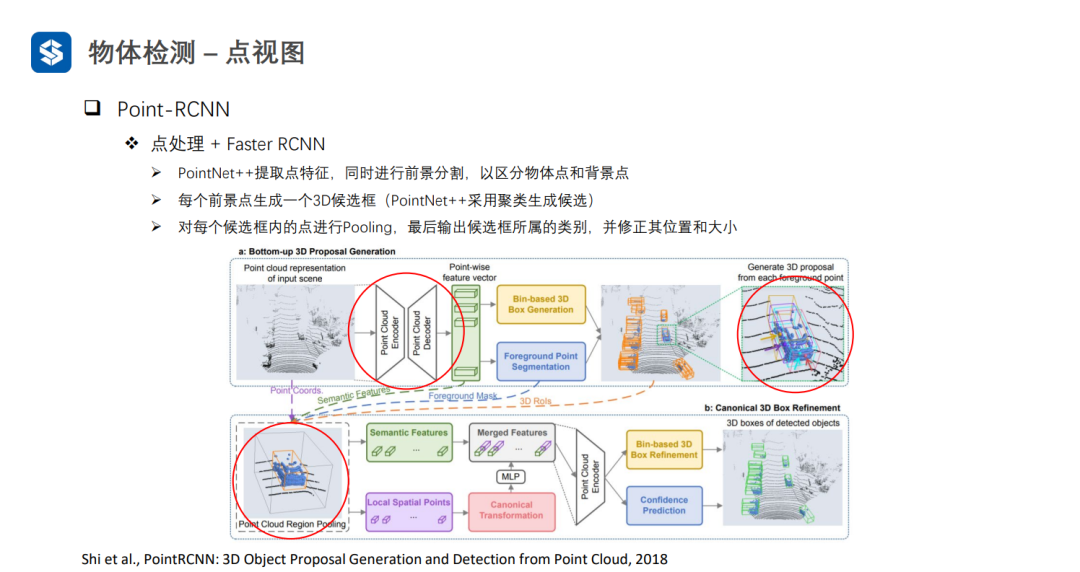

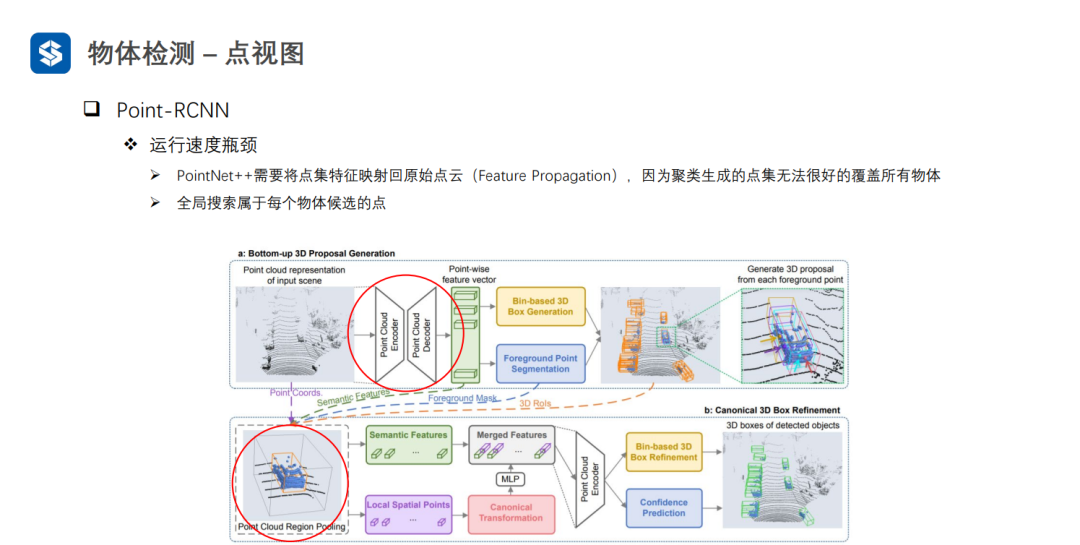

Point-RCNN通過前景分割的方式來避免耗時的聚類過程,但是也會存在較為耗時的全局搜索過程。

3D-SSD通過改進聚類的質(zhì)量,直接在聚類結(jié)果上生成候選框。

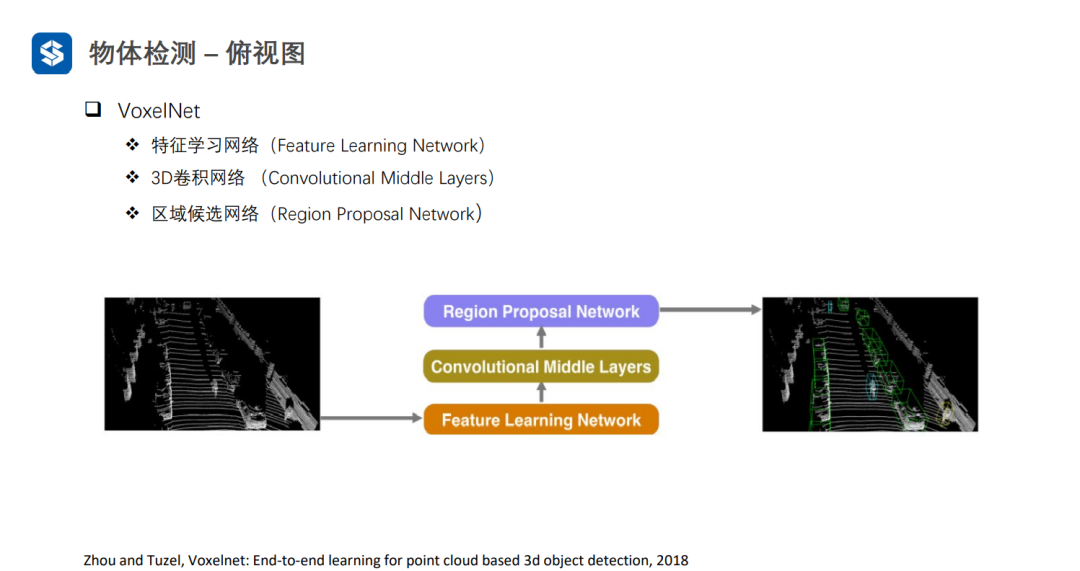

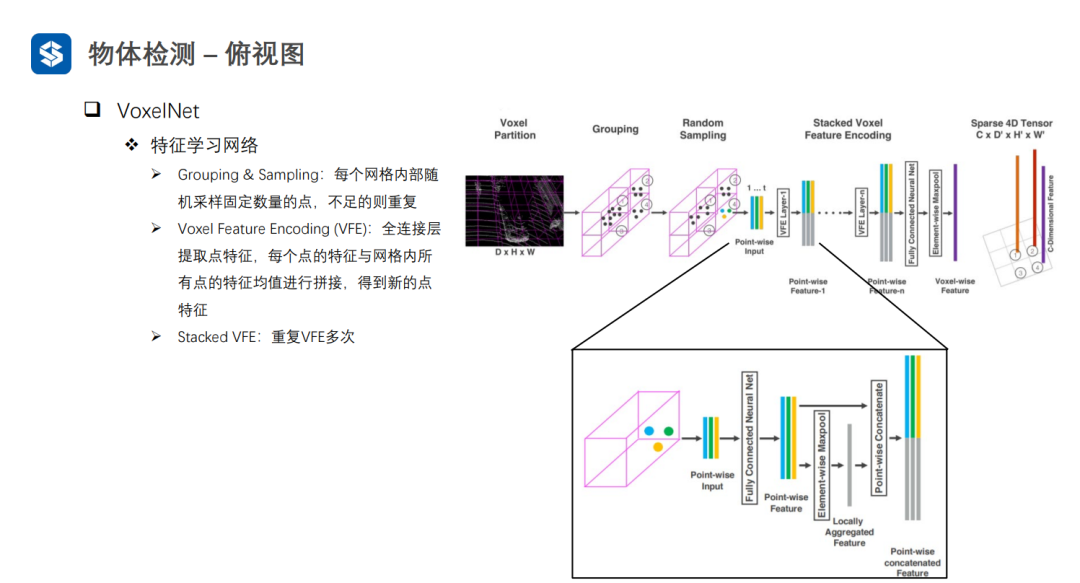

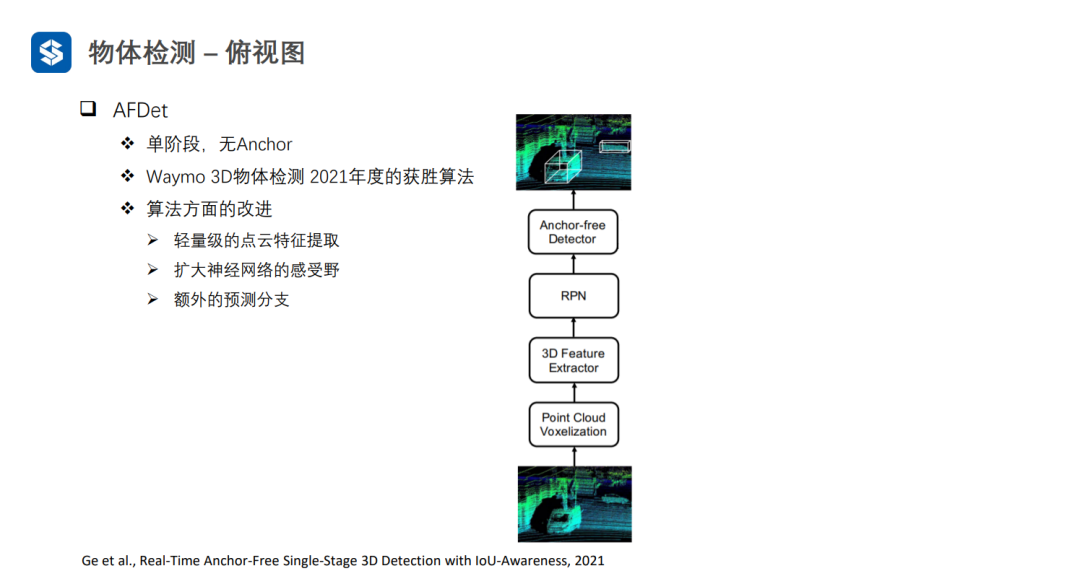

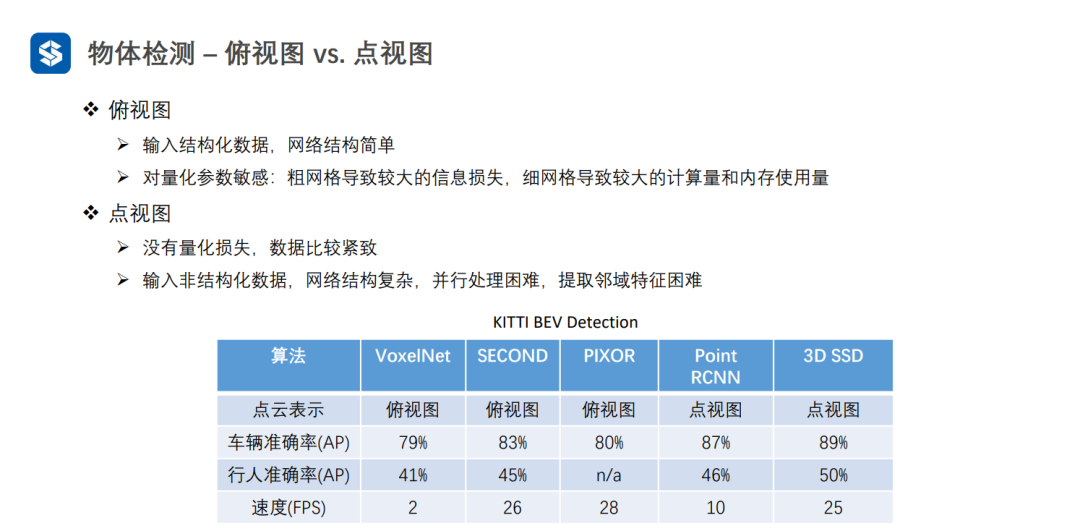

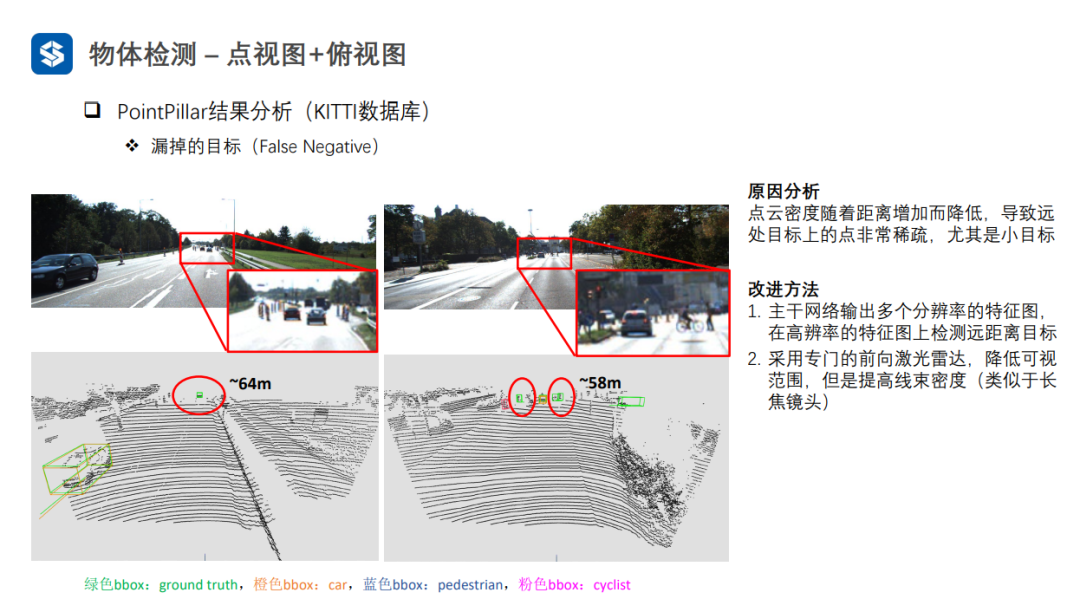

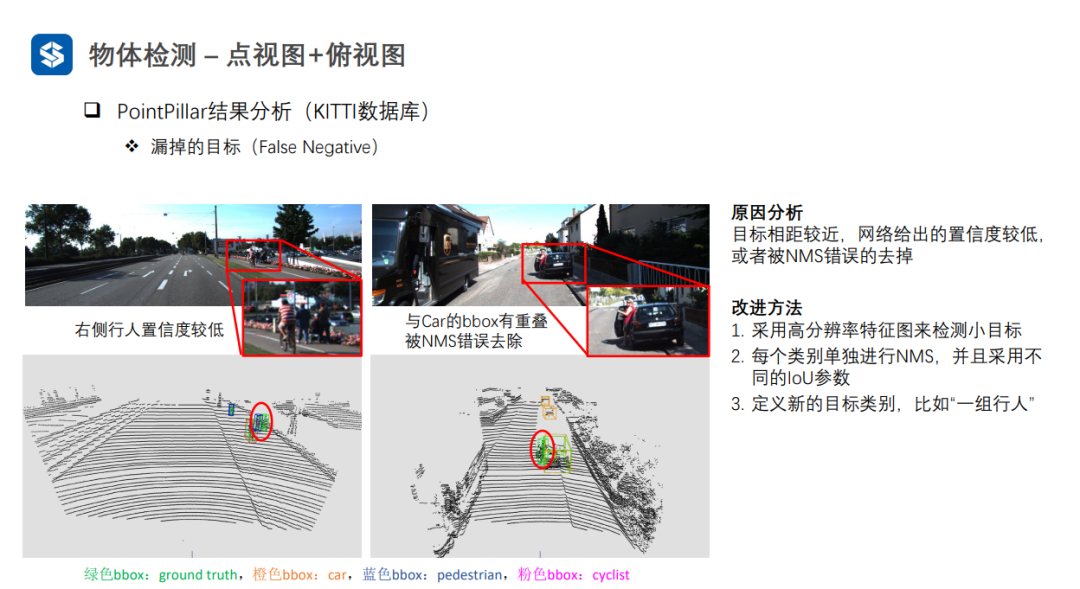

3.2俯視圖

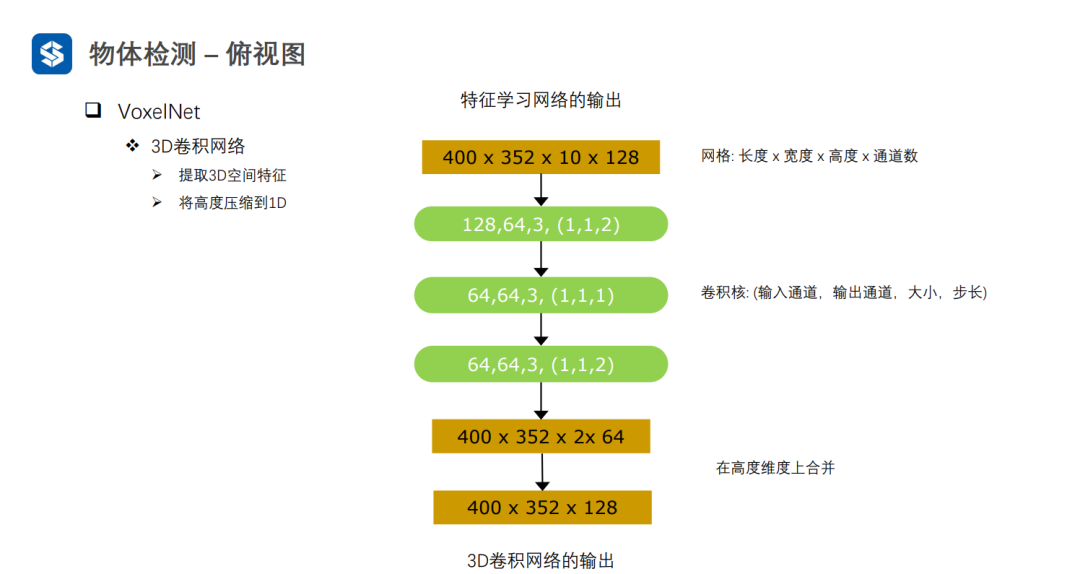

VoxelNet通過將三維空間劃分成體素,并在每個體素內(nèi)進行特征提取,形成四維張量(D, H, W, C)。

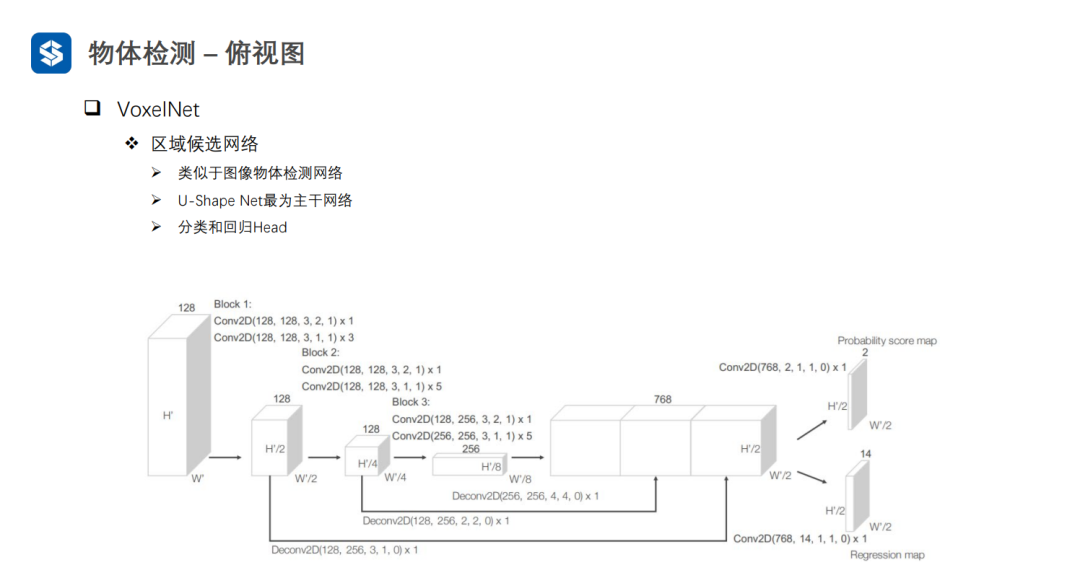

利用3D-CNN對四維張量進行特征提取,并將高度方向上壓縮為1D,得到三維張量(H', W', C')。最后,利用2D視覺感知算法進行檢測任務(wù)。

VoxelNet在劃分體素時,由于點云是稀疏的,會導致大量體素是空白的,這樣在進行3D卷積時會造成很多無效計算。

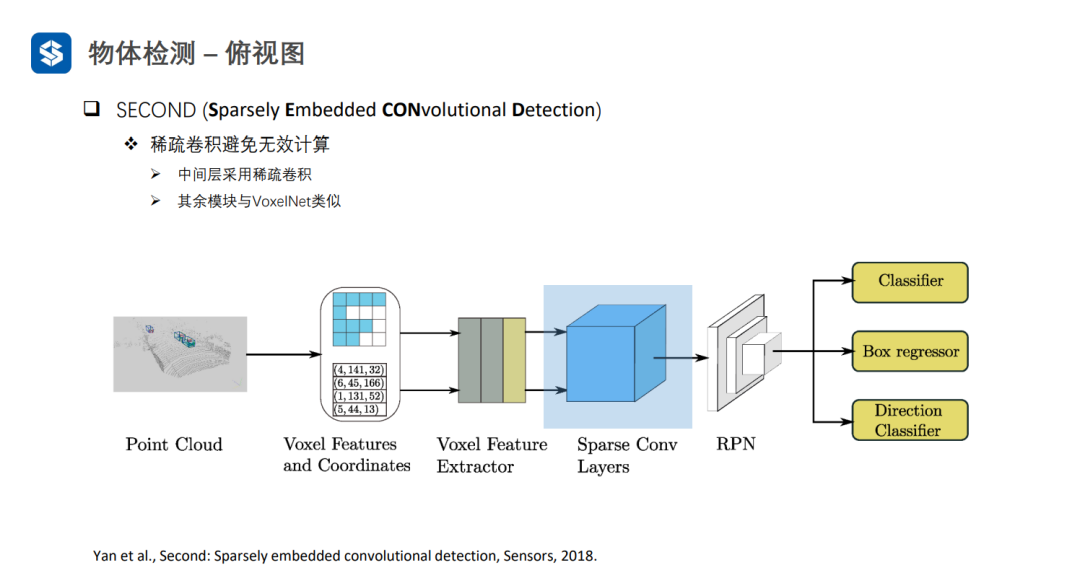

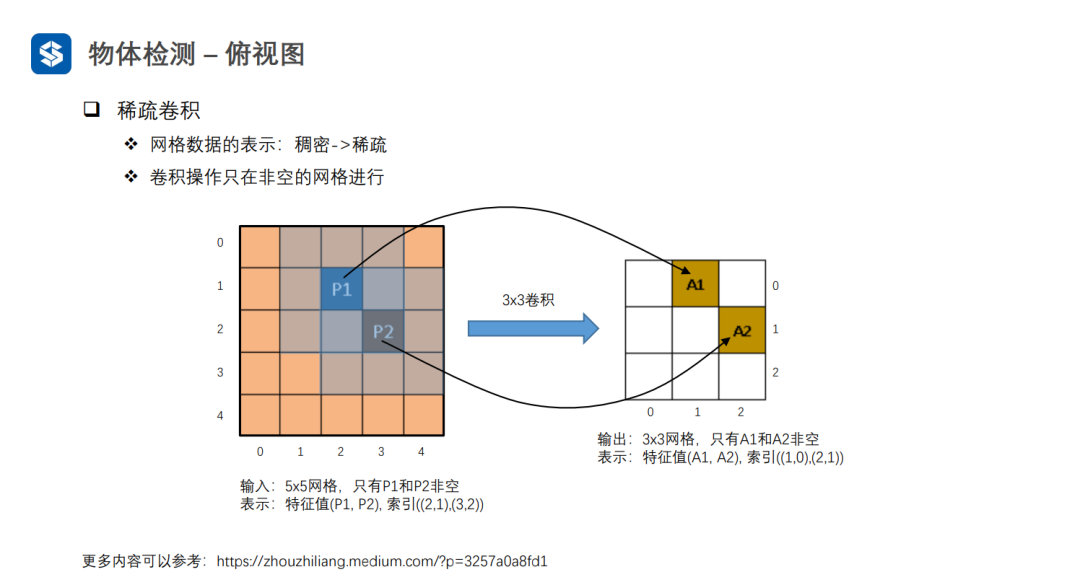

SECOND采用稀疏卷積避免空白體素區(qū)域的無效計算

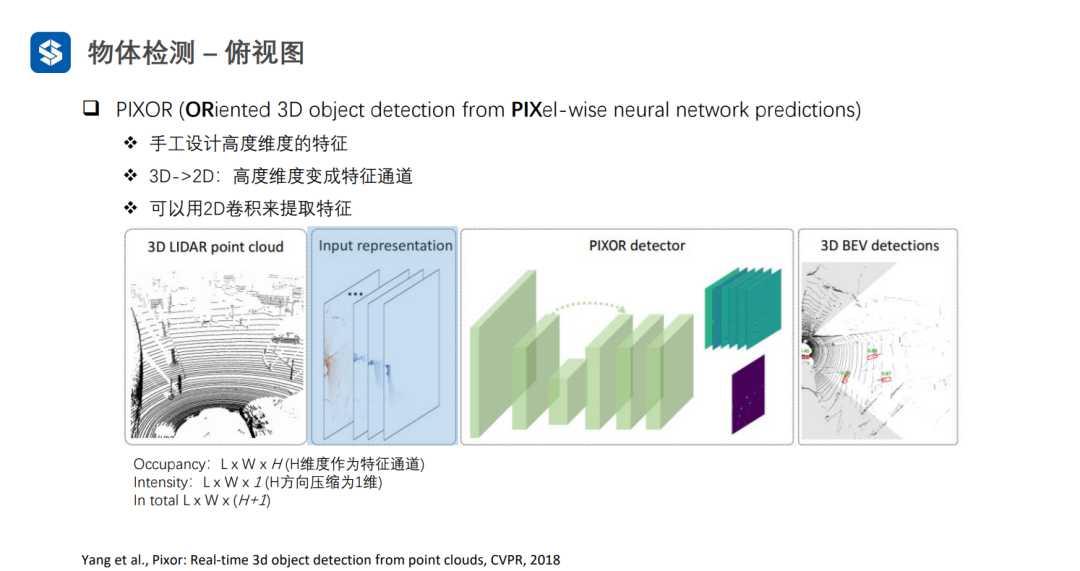

PIXOR將高度方向劃分為H個等級,如果有點云落在某個格子里,此處的Occupancy為1,且Intensity為格子里點云強度的均值。

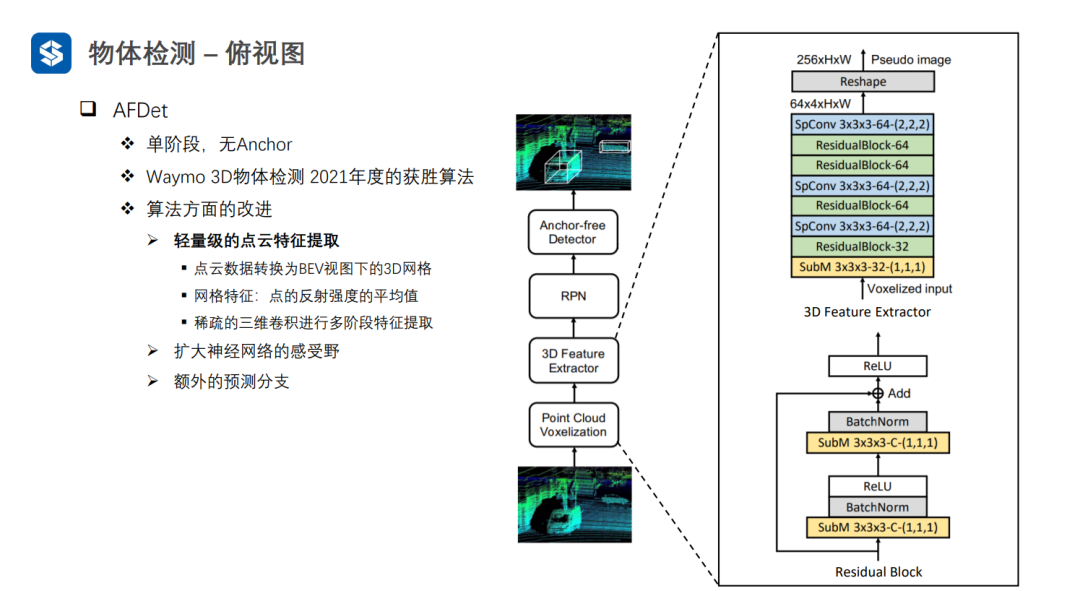

AFDet經(jīng)過輕量級的點云特征提取,首先將點云體素化,并且每個體素的特征為點云反射強度的均值,再用稀疏3D卷積進行特征提取。這樣,可以將四維張量變?yōu)閭螆D像的三維張量。

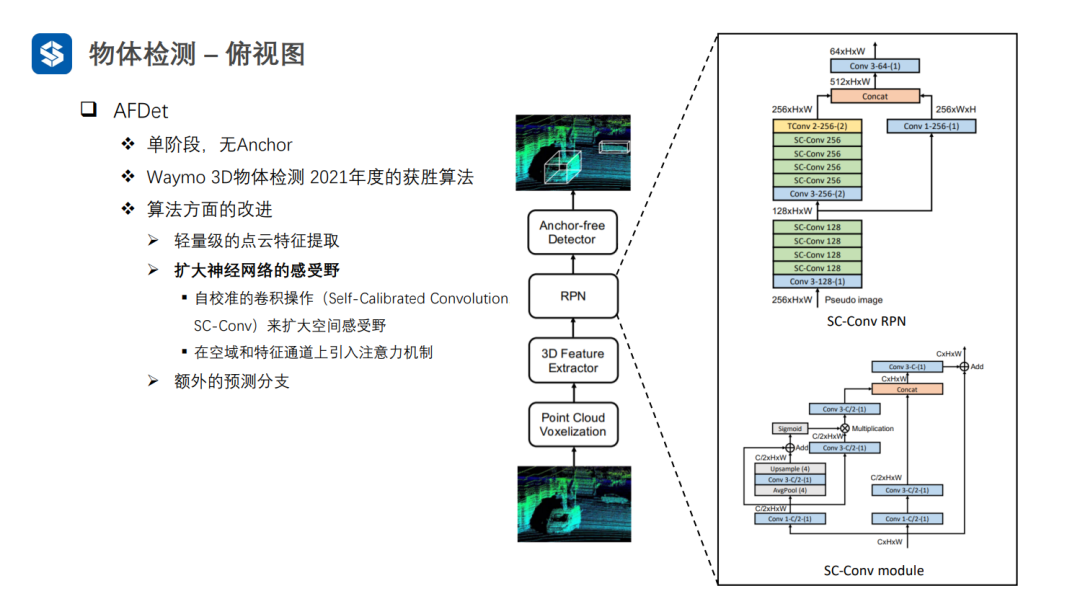

AFDet中的自校準卷積其實就是對三維張量施加了注意力機制。

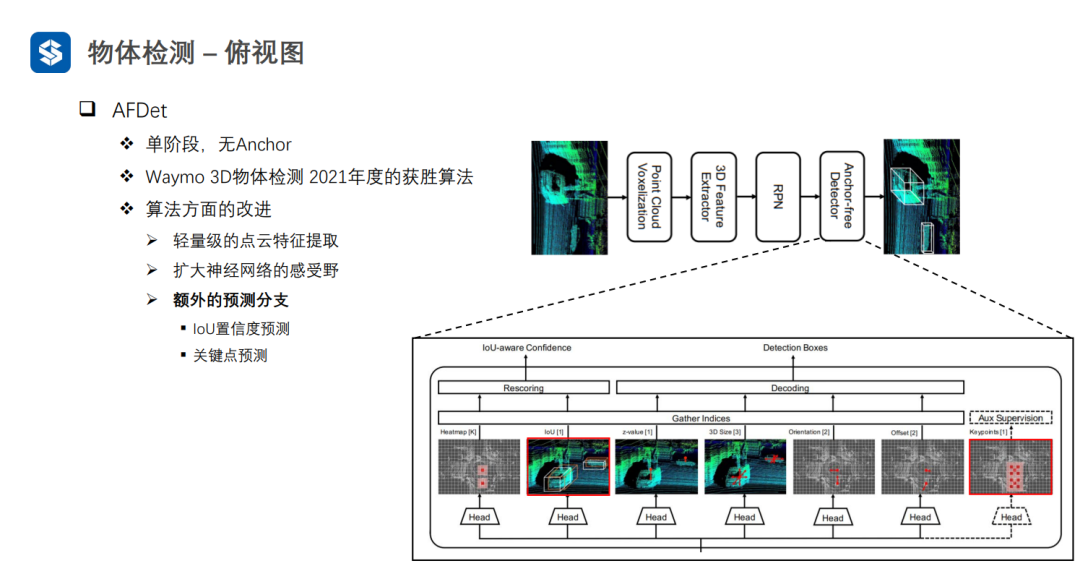

AFDet與CenterNet比較類似:先預測中心點的objectiveness,然后結(jié)合z軸方向的預測,可以得到物體在三維坐標系中的位置;接著預測物體框的大小和朝向,以及物體中心點的偏移;同時,會加入物體框的IOU置信度預測(衡量框的質(zhì)量好壞,因為中心點objectiveness不包含框質(zhì)量的信息)和關(guān)鍵點預測

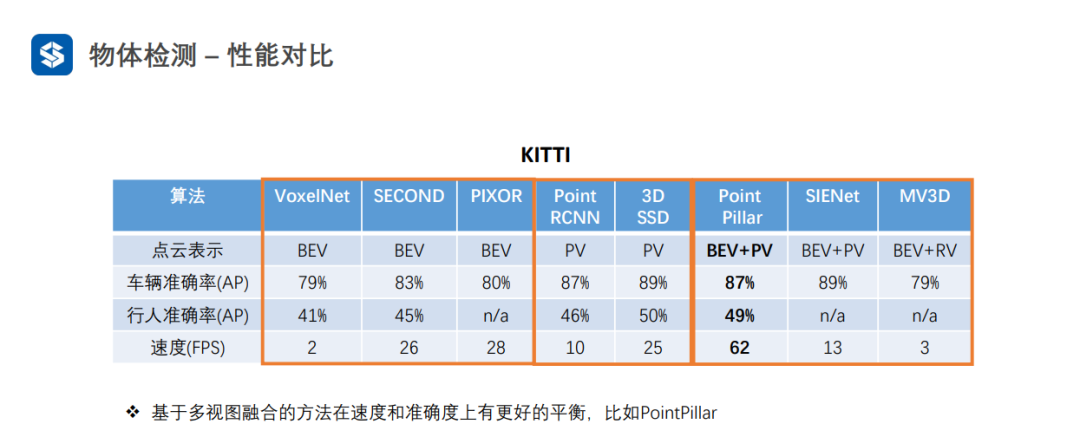

點視圖的精度一般較高,因為沒有量化損失

俯視圖可以并行優(yōu)化,一般速度較快

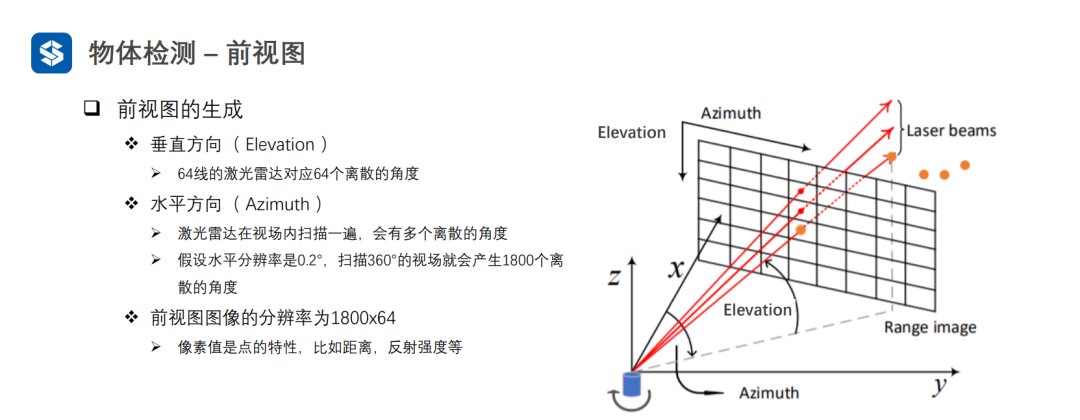

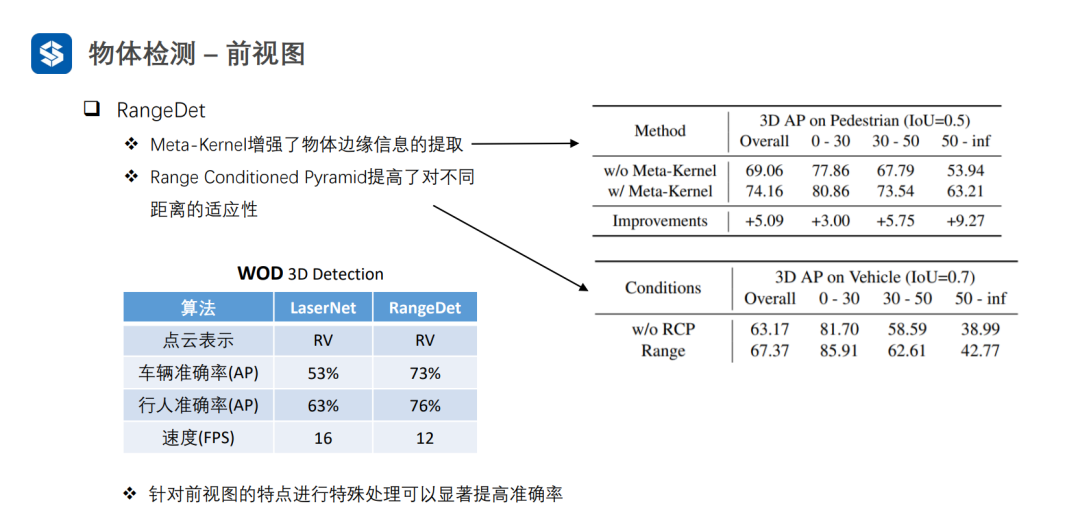

3.3 前視圖

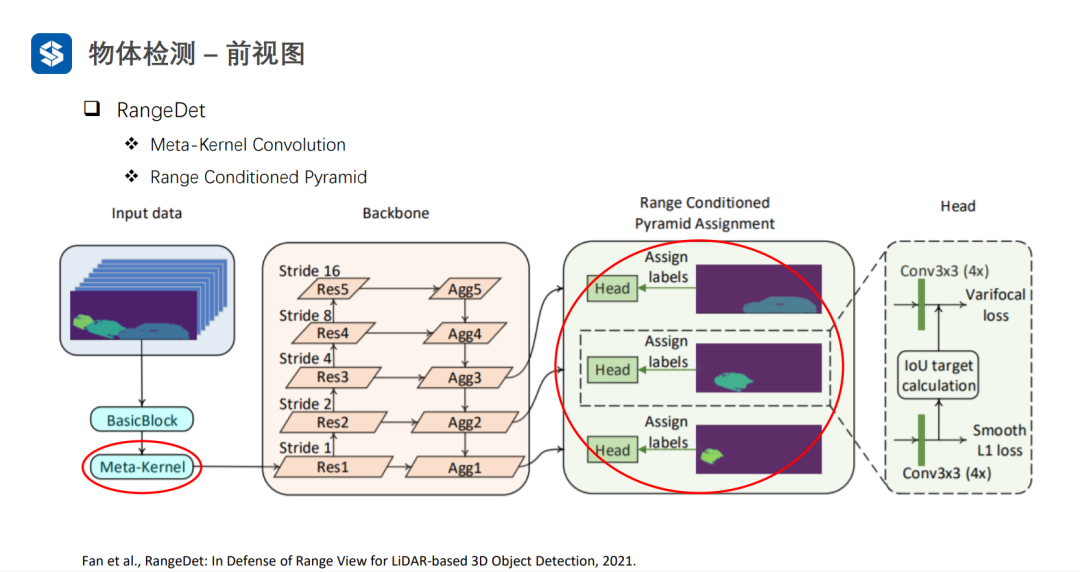

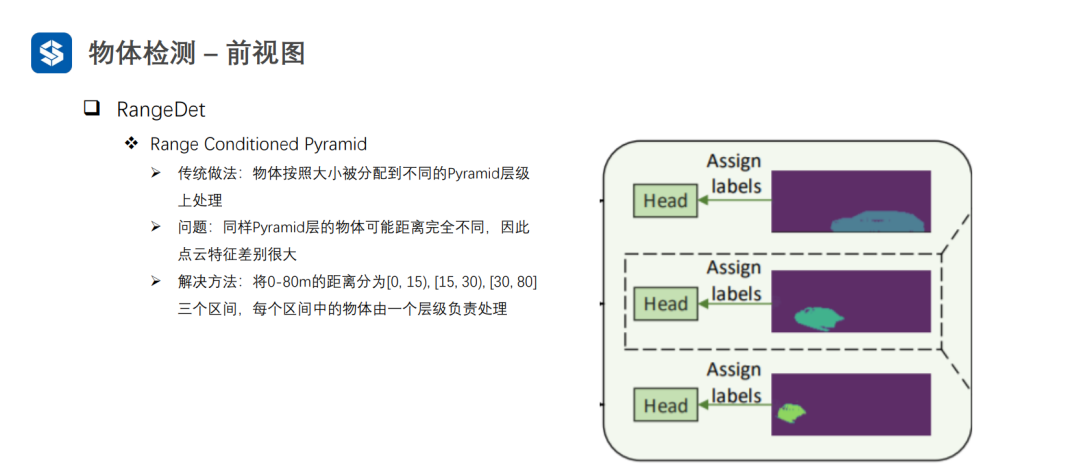

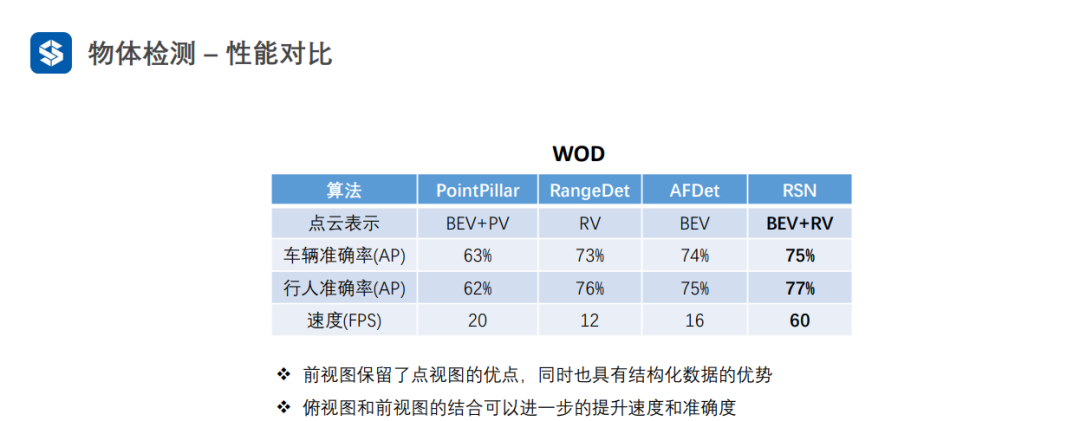

前視圖雖然是網(wǎng)格結(jié)構(gòu),但是編碼了三維空間信息,因此需要設(shè)計額外的操作來提取空間信息。

采用普通卷積提取特征,會損失空間信息

Meta-Kernel是動態(tài)變化的:1)對于同一樣本的不同位置是不同的;2)對于不同樣本相同位置也是不同的。普通卷積對于不同樣本的相同位置都是一樣的。因此,Meta-Kernel可以看作是對樣本和位置的一種注意力機制。

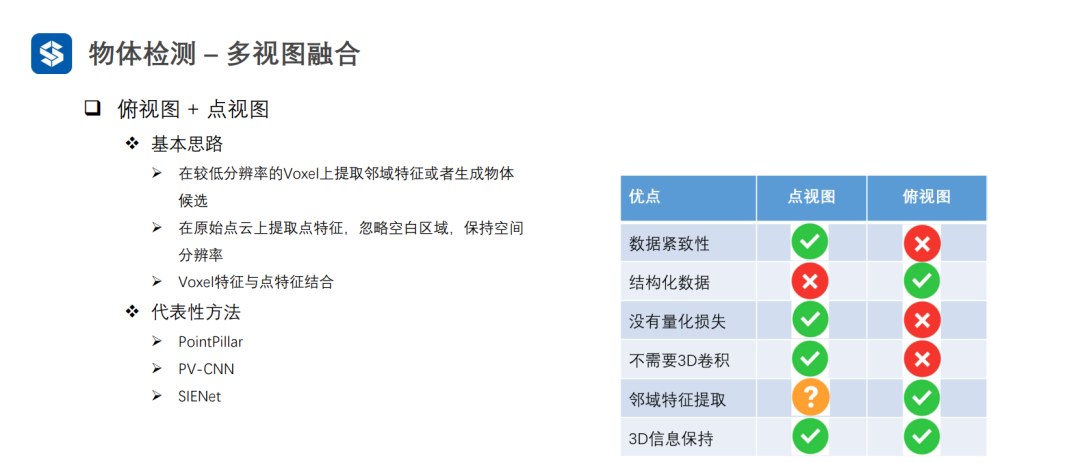

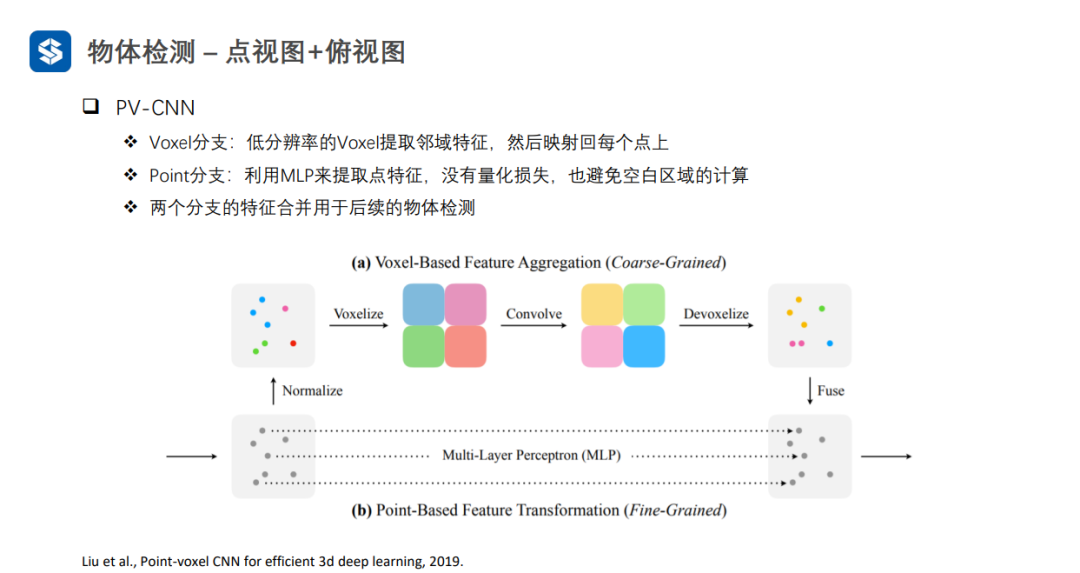

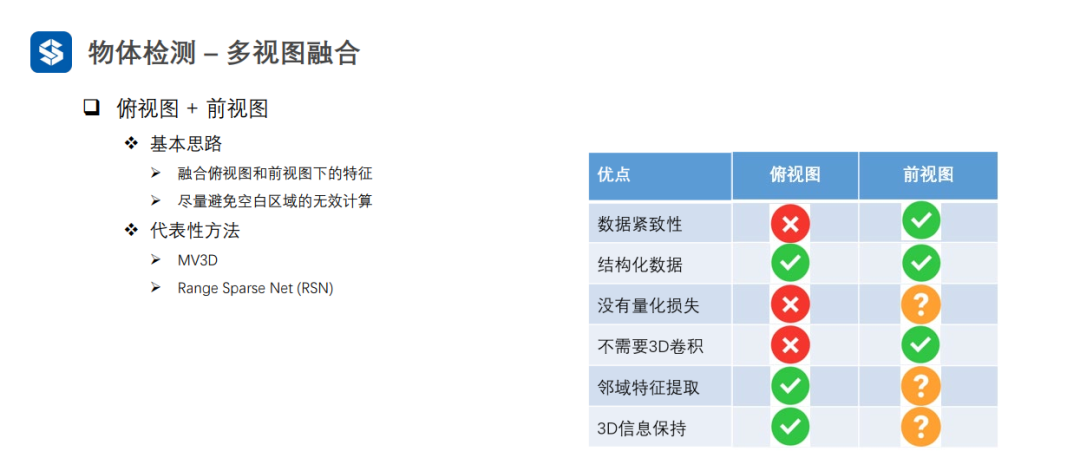

3.4 多視圖融合

Voxel特征可看作粗粒度的特征,而點特征可看作細粒度特征

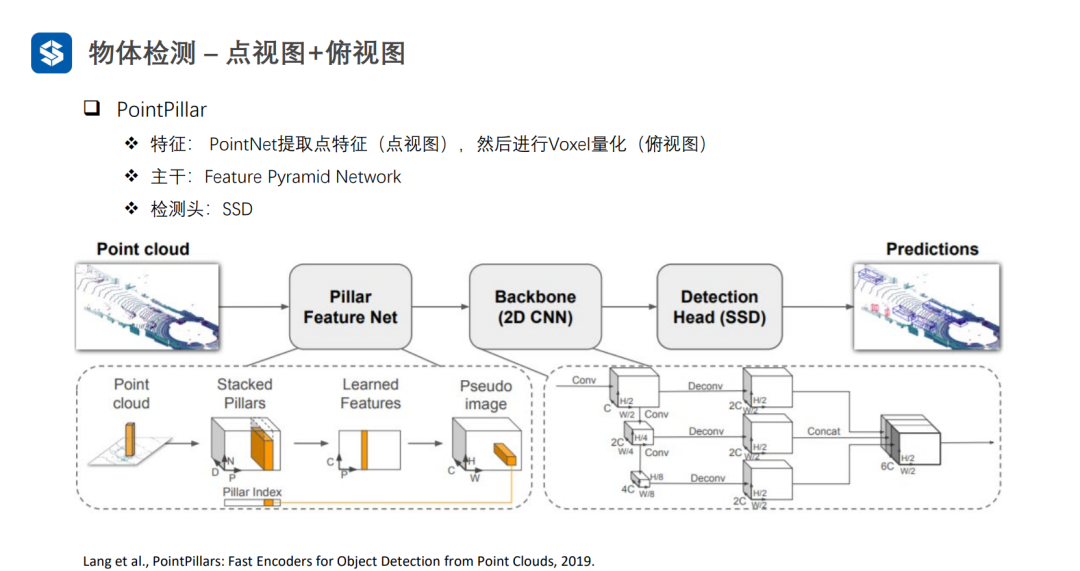

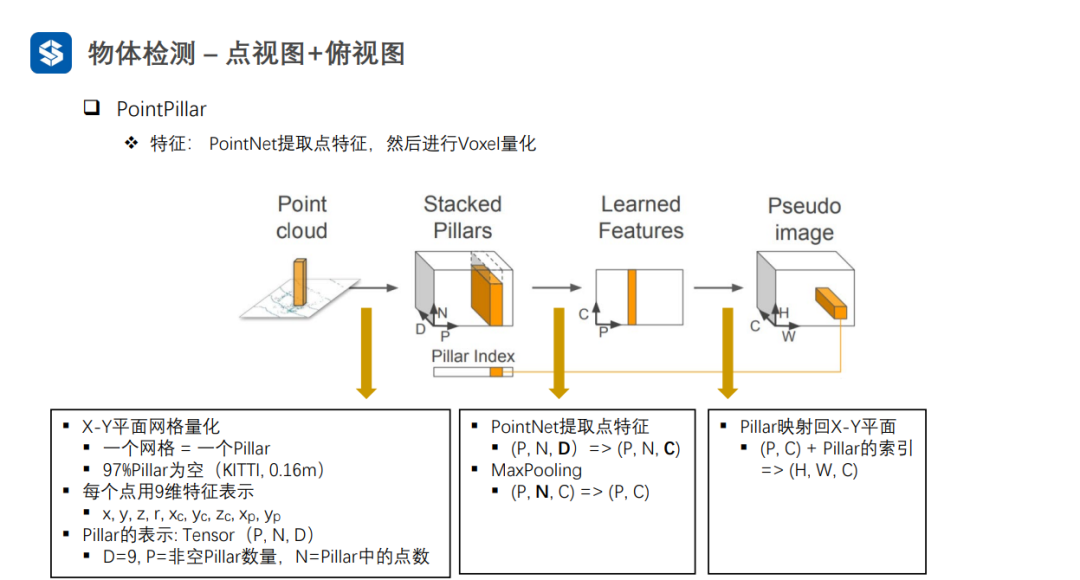

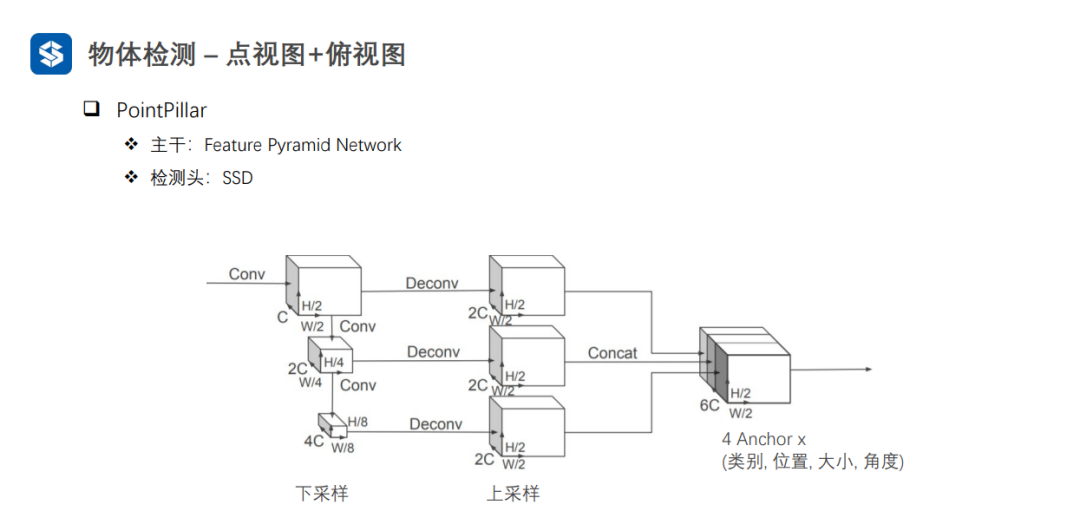

每個Pillar內(nèi)部采用PointNet進行特征提取,并采用MaxPooling將同一個Pillar內(nèi)部多個點的特征壓縮成一個全局特征,從而形成偽圖像

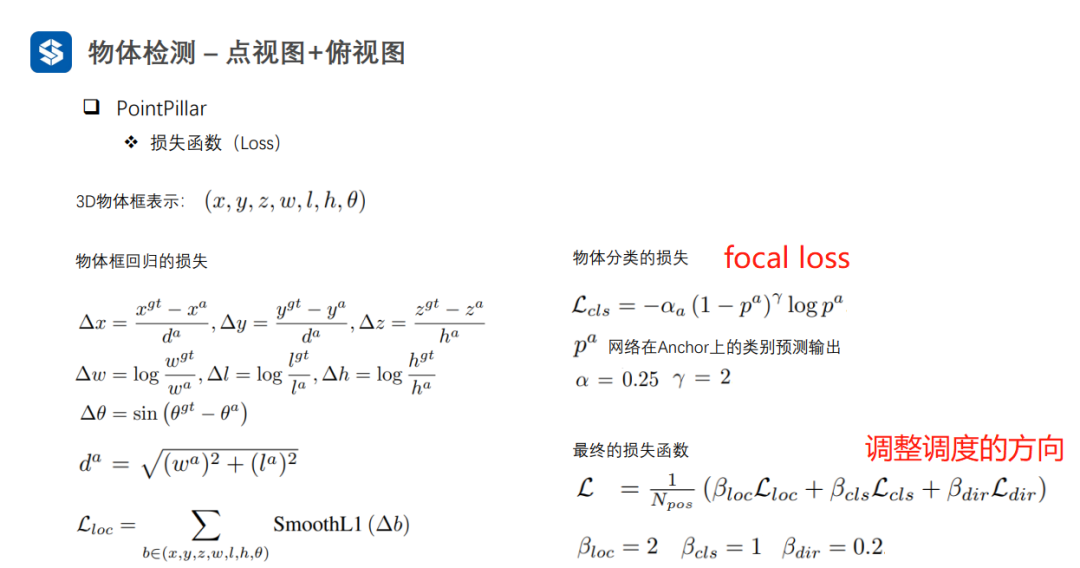

當預測的角度與真實的角度相差180°時,Δθ的損失值一樣,因此加入L_dir彌補這一缺點,但是權(quán)重要小一點。

粗粒度與細粒度特征的融合

對候選框中的稀疏點集進行擴展

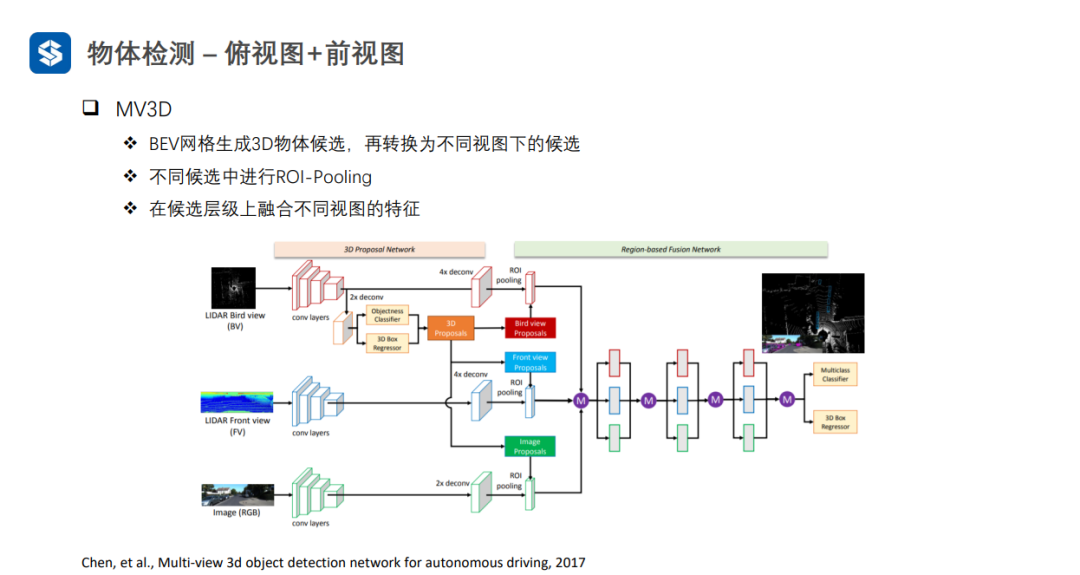

將3D proposal分別向bevfront viewimage上投影

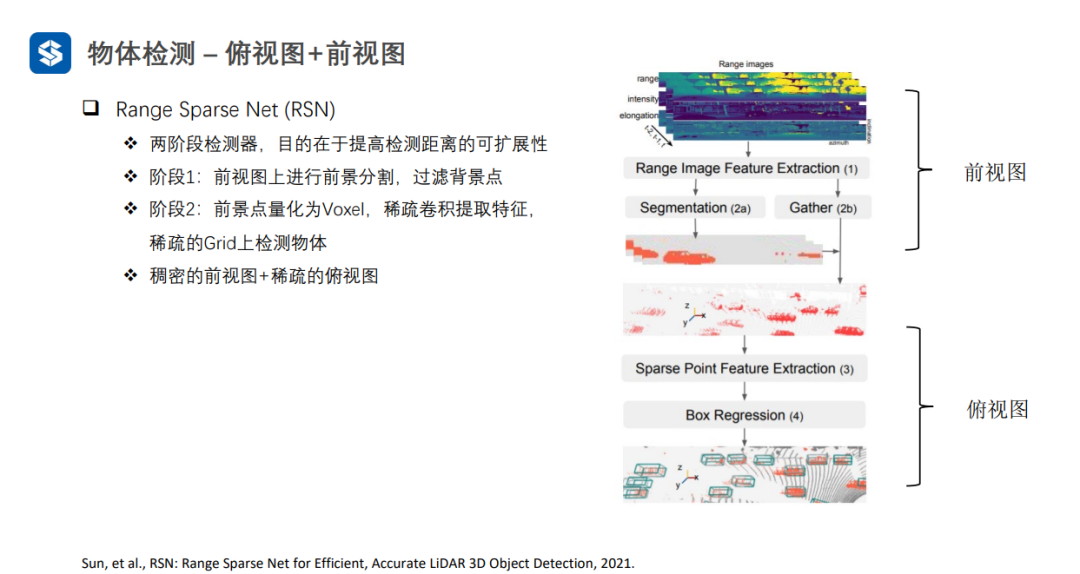

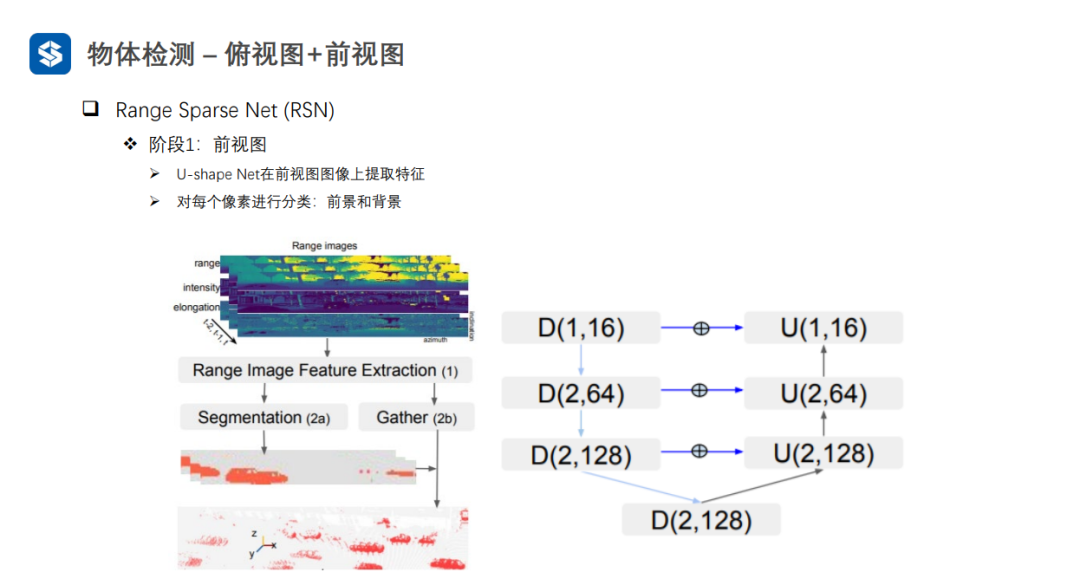

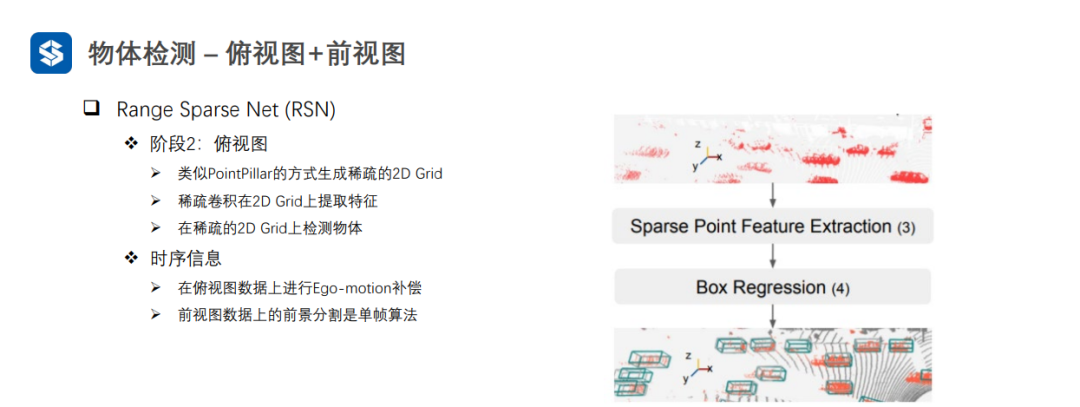

在俯視圖上通過自車運動的補償,融合多幀信息進行檢測(可以將多幀圖像拼接在一起送入檢測網(wǎng)絡(luò)提取特征,并進行檢測)

-

激光雷達

+關(guān)注

關(guān)注

968文章

3991瀏覽量

190080 -

自動駕駛

+關(guān)注

關(guān)注

784文章

13877瀏覽量

166613 -

毫米波雷達

+關(guān)注

關(guān)注

107文章

1049瀏覽量

64426

原文標題:自動駕駛環(huán)境感知——激光雷達物體檢測(chapter4)

文章出處:【微信號:vision263com,微信公眾號:新機器視覺】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

【「具身智能機器人系統(tǒng)」閱讀體驗】2.具身智能機器人的基礎(chǔ)模塊

毫米波雷達與激光雷達比較 毫米波雷達在自動駕駛中的作用

激光雷達技術(shù)的發(fā)展趨勢

激光雷達在自動駕駛中的應(yīng)用

激光雷達與純視覺方案,哪個才是自動駕駛最優(yōu)選?

L4自動駕駛需求迭代,360°激光雷達也要進入芯片化時代

聊聊自動駕駛離不開的感知硬件

激光雷達濾光片:自動駕駛的“眼睛之選”

FPGA在自動駕駛領(lǐng)域有哪些應(yīng)用?

百度蘿卜快跑第六代無人車攜手禾賽AT128激光雷達,共筑自動駕駛新篇章

基于FPGA的激光雷達控制板

自動駕駛環(huán)境感知——激光雷達物體檢測(chapter4)

自動駕駛環(huán)境感知——激光雷達物體檢測(chapter4)

評論