AI大模型的量化技術(shù),讓消費(fèi)產(chǎn)品端側(cè)大模型成為現(xiàn)實(shí)

近日聯(lián)想集團(tuán)董事長兼首席執(zhí)行官楊元慶在媒體溝通會(huì)上表示,隨著人工智能的發(fā)展,尤其是AIGC的爆發(fā)會(huì)促進(jìn)智能設(shè)備的升級(jí)。他認(rèn)為,今年還不會(huì)有太大的影響,明年一定是革命性的影響,促進(jìn)電腦的升級(jí)換代,他預(yù)計(jì)到明年可以見到AI的手機(jī)和電腦。

隨著OPEN AI推出ChatGPT以來,行業(yè)一直在試圖突破大模型在單個(gè)強(qiáng)大的消費(fèi)類GPU上運(yùn)行的限制。

通常,運(yùn)行GPT-3需要多個(gè)數(shù)據(jù)中心級(jí)英偉達(dá)A100 GPU。但是META、谷歌和微軟等科技大公司為了推動(dòng)終端產(chǎn)品市場的發(fā)展,在端運(yùn)行大模型的研發(fā)項(xiàng)目陸續(xù)出臺(tái)。

最早是META2月份發(fā)布的LLaMA引起了轟動(dòng),因?yàn)樗梢栽趩蝹€(gè)強(qiáng)大的消費(fèi)類GPU上運(yùn)行。現(xiàn)在,通過一種被稱為量化的技術(shù)來進(jìn)行優(yōu)化、使模型縮小后,LLaMA可以在配備M1芯片的蘋果電腦或較小的英偉達(dá)消費(fèi)級(jí)GPU上運(yùn)行。LLaMA是一個(gè)參數(shù)大小范圍從7B到65B的大型語言模型(“B”是指“十億參數(shù)”,是存儲(chǔ)在矩陣中的浮點(diǎn)數(shù),表示模型“知道”的內(nèi)容)。LLaMA較小尺寸的模型在輸出質(zhì)量和速度方面可以與GPT-3相媲美。

時(shí)隔半年后,Meta AI在周二發(fā)布了最新一代開源大模型Llama 2。相較于今年2月發(fā)布的Llama 1,訓(xùn)練所用的token翻了一倍至2萬億,同時(shí)對于使用大模型最重要的上下文長度限制,Llama 2也翻了一倍。Llama 2包含了70億、130億和700億參數(shù)的模型。Meta同樣在周二宣布,與微軟云服務(wù)Azure合作,向全球開發(fā)者首發(fā)基于Llama 2模型的云服務(wù)。另外,Meta也與高通宣布,Llama 2將能夠在高通芯片上運(yùn)行,打破市場上英偉達(dá)、AMD處理器對AI產(chǎn)業(yè)的壟斷。

而另一巨頭谷歌在5月11日召開 的“2023 Google I/O”技術(shù)大會(huì)上,谷歌首席執(zhí)行官Sundar Pichai介紹了最新發(fā)布的大語言模型PaLM 2,主要功能包括支持100多種語言、具備邏輯推理、代碼生成等,基本上與ChatGPT的最新模型GPT-4類似,PaLM 2提供了Gecko、Otter、Bison和Unicorn四種模型。其中,Gecko非常非常輕巧,可以在移動(dòng)設(shè)備端運(yùn)行快速運(yùn)行(手機(jī)、Pad等),即便是離線狀態(tài)也能與應(yīng)用程序進(jìn)行交互。谷歌希望開發(fā)者通過Gecko模型,加速生成式AI在移動(dòng)端的開發(fā)進(jìn)程。

PaLM 2采用了一種“計(jì)算最優(yōu)縮放”技術(shù),能在最小的參數(shù)實(shí)現(xiàn)最大的性能,也就是說開發(fā)者可以用最少的算力資源,開發(fā)強(qiáng)大的生成式AI應(yīng)用。AI 大模型的加入,讓 Android 14成為真正內(nèi)置 AI 大模型的操作系統(tǒng)。

其實(shí)國內(nèi)早在3月份元語智能團(tuán)隊(duì)又開源了一個(gè)ChatYuan系列大模型:ChatYuan-large-v2,支持在單張消費(fèi)級(jí)顯卡、PC甚至手機(jī)上進(jìn)行推理使用。ChatYuan-large-v2是ChatYuan系列中以輕量化實(shí)現(xiàn)高質(zhì)量效果的代表模型,僅僅通過0.7B參數(shù)量可以實(shí)現(xiàn)業(yè)界10B模型的基礎(chǔ)效果,并且大大降低了推理成本,提高了使用效率。用戶可以在消費(fèi)級(jí)顯卡、 PC甚至手機(jī)上進(jìn)行推理(INT4 最低只需 400M )。同時(shí),為了更好的提升使用體驗(yàn),團(tuán)隊(duì)已經(jīng)封裝了工具,Chatyuan-large-v2實(shí)現(xiàn)了本地可運(yùn)行,下載后可以直接在本地使用h5版本,進(jìn)行網(wǎng)頁交互。

智能手機(jī)產(chǎn)業(yè)積極擁抱端側(cè)AI大模型

智能手機(jī)的算力早已經(jīng)超出很多消費(fèi)電子終端產(chǎn)品,包括平板電腦、筆記本電腦、甚至PC產(chǎn)品,甚至很多芯片廠商的CPUGPU產(chǎn)品設(shè)計(jì),已完成兼容了智能手機(jī)、平板電腦、筆記本電腦、PC產(chǎn)品、ARVRMR智能手表智能機(jī)器人等所有能接入物聯(lián)網(wǎng)的硬件平臺(tái)產(chǎn)品。

作為推動(dòng)智能手機(jī)等物聯(lián)網(wǎng)物種進(jìn)化的先進(jìn)技術(shù),與單純在云端部署生成式 AI 應(yīng)用和服務(wù)相比,端側(cè)部署生成式 AI 在節(jié)約服務(wù)器成本、保護(hù)用戶信息安全、提升實(shí)時(shí)性和實(shí)現(xiàn)個(gè)性化用戶體驗(yàn)等方面帶來了更加廣闊的應(yīng)用前景。

在設(shè)備上使用生成式AI有很多好處,比如所搜索記錄和個(gè)人數(shù)據(jù)是保密的,不會(huì)通過遠(yuǎn)程服務(wù)器中轉(zhuǎn)。本地AI也比云端更快,而且可以在飛機(jī)上等缺少移動(dòng)網(wǎng)絡(luò)服務(wù)的地區(qū)工作。因此端側(cè)AI大模型在包括智能手機(jī)在內(nèi)的物聯(lián)網(wǎng)行業(yè)一直有著巨大的需求。

早在今年2月份,高通就已經(jīng)發(fā)布了全球首個(gè)運(yùn)行在安卓手機(jī)上的圖片生成軟件Stable Diffusion的終端演示,該手機(jī)搭載了驍龍8 Gen2芯片。

目前高通等芯片廠商,正在針對AI大模型端側(cè)部署研發(fā)專用的芯片。目前,高通正在將AIGC嵌入下一代高端芯片驍龍8 Gen3中,該芯片將于今年10月底在夏威夷舉行的高通驍龍峰會(huì)上首次亮相。

在Asghar的實(shí)驗(yàn)室中,高通芯片能夠處理70億個(gè)參數(shù)的AI模型,雖然遠(yuǎn)遠(yuǎn)低于OpenAI GPT-3模型的1750億個(gè)參數(shù),但應(yīng)該適合移動(dòng)搜索。

高通表示,本年度將能夠支持參數(shù)達(dá)100億的生成式AI模型在手機(jī)上運(yùn)行,這意味著未來大多數(shù)的用例將能夠完全依靠手機(jī)端就能夠完成。高通在技術(shù)層面已經(jīng)做好了準(zhǔn)備。

100億-150億參數(shù)級(jí)別的模型可以覆蓋絕大多數(shù)生成式AI的用例。如果終端已經(jīng)可以支持這一參數(shù)級(jí)別,那么運(yùn)算可全部在終端上進(jìn)行,無需云端處理運(yùn)算。屆時(shí)包括智能手機(jī)在內(nèi)的消費(fèi)電子產(chǎn)品和其它物聯(lián)網(wǎng)終端產(chǎn)品會(huì)擁有非常豐富的使用場景,會(huì)成為真正的個(gè)人助理。

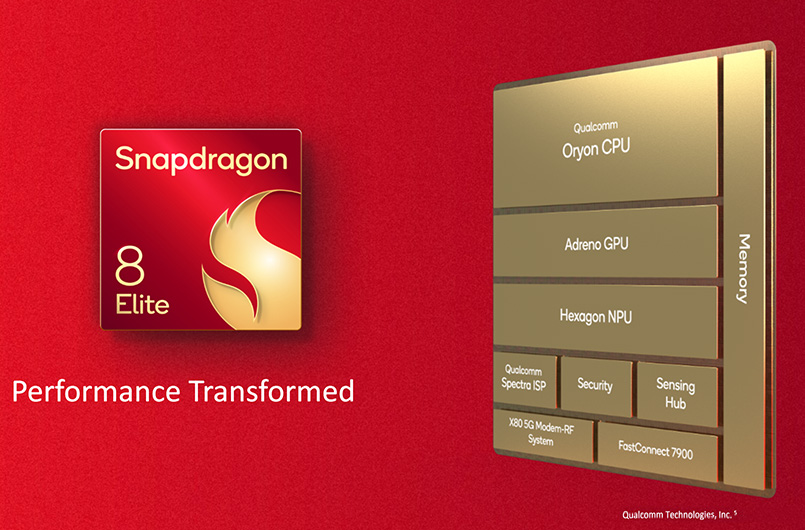

高通AI引擎由多個(gè)硬件和軟件組件組成,用于在驍龍移動(dòng)平臺(tái)上為終端側(cè)AI推理加速。它采用異構(gòu)計(jì)算架構(gòu),包括高通Hexagon處理器、Adreno GPU、Kryo CPU和傳感器中樞,共同支持在終端上運(yùn)行AI應(yīng)用程序。

在2023年世界人工智能大會(huì)上,高通展示了全球首個(gè)在終端側(cè)運(yùn)行生成式AI(AIGC)模型Stable Diffusion的技術(shù)演示,和全球最快的終端側(cè)語言-視覺模型(LVM)ControlNet運(yùn)行演示。這兩款模型的參數(shù)量已經(jīng)達(dá)到10億-15億,僅在十幾秒內(nèi)就能夠完成一系列推理,根據(jù)輸入的文字或圖片生成全新的AI圖像。

高通認(rèn)為在數(shù)據(jù)產(chǎn)生的地方直接進(jìn)行高效推理才是大趨勢。而數(shù)據(jù)產(chǎn)生的地方正是在端側(cè),比如手機(jī)端或電腦端。在高通AI軟件棧(Qualcomm AI Stack)的幫助下,手機(jī)端的能力更是可以在其他設(shè)備端實(shí)現(xiàn)復(fù)制,如PC、AR/VR、汽車和物聯(lián)網(wǎng)IoT設(shè)備。

同時(shí)另一智能移動(dòng)產(chǎn)品芯片巨頭聯(lián)發(fā)科也在近期宣布聯(lián)合百度發(fā)起飛槳和文心大模型硬件生態(tài)共創(chuàng)計(jì)劃,共同推進(jìn)聯(lián)發(fā)科硬件平臺(tái)與飛槳和文心大模型適配。本月聯(lián)發(fā)科還宣布運(yùn)用Meta LIama 2大語言模型和聯(lián)發(fā)科先進(jìn)的AI處理器(APU)以及完整的AI開發(fā)平臺(tái)(NeuroPilot),建立完整的終端側(cè)AI計(jì)算生態(tài),賦能終端設(shè)備生成式AI應(yīng)用。

聯(lián)發(fā)科與百度合作已久,雙方合作完成了 Paddle Lite 輕量化推理引擎基于 MediaTek NeuroPilot 人工智能通用軟件平臺(tái)的適配。NeuroPilot 是 MediaTek 為開發(fā)者提供的基于本地端側(cè)的 AI 運(yùn)算解決方案,它為內(nèi)建 CPU、GPU 和 APU(獨(dú)立AI 處理器)等異構(gòu)運(yùn)算單元的 MediaTek SoC 平臺(tái)提供完整且強(qiáng)大的軟件解決方案。

聯(lián)發(fā)科將于年末推出新一代旗艦移動(dòng)芯片,將采用針對Llama 2模型而優(yōu)化的軟件棧(NeuroPilot),與搭配支持Transformer模型做骨干網(wǎng)絡(luò)加速的升級(jí)版AI處理器(APU),可減少動(dòng)態(tài)隨機(jī)存取內(nèi)存(DRAM)的讀寫消耗和帶寬占用,進(jìn)一步強(qiáng)化大語言模型和生成式AI應(yīng)用的性能,助力開發(fā)者打造令人驚艷的AI應(yīng)用,加速終端設(shè)備AI應(yīng)用落地發(fā)展,持續(xù)為智能手機(jī)、汽車、智能家居、物聯(lián)網(wǎng)等終端設(shè)備用戶帶來振奮人心的生成式AI應(yīng)用體驗(yàn)。

智能手機(jī)廠商聞AI大模型起舞

近年來手機(jī)產(chǎn)業(yè)發(fā)展進(jìn)入創(chuàng)新瓶頸期,手機(jī)廠商正試圖尋找新的差異化出路。特別今年以來,隨著ChatGPT的橫空出世和全民級(jí)應(yīng)用發(fā)展趨勢,眾多手機(jī)廠商紛紛入局AI大模型賽道,除谷歌外,榮耀、OPPO、vivo、小米、華為等國產(chǎn)手機(jī)巨頭。

據(jù)業(yè)內(nèi)人士表示,榮耀已經(jīng)把AI大模型引入端側(cè),賦能YOYO智慧助手,打造更加個(gè)人化、人性化,隱私保護(hù)更周全的端側(cè)個(gè)人模型;小米將小愛同學(xué)升級(jí)大模型,小米手機(jī)端側(cè)大模型已初步跑通;OPPO、vivo 也計(jì)劃在系統(tǒng)中整合AI 大模型能力。

8月4日,華為對外發(fā)布HarmonyOS 4,將AI大模型能力內(nèi)置在了系統(tǒng)底層。HarmonyOS 4由華為盤古大模型提供底層支持,希望給用戶帶來智慧終端交互、高階生產(chǎn)力效率、個(gè)性化服務(wù)的全新AI體驗(yàn)變革。

在8月14日晚舉辦的小米年度演講中,雷軍表示,小米AI大模型最新一個(gè)13億參數(shù)大模型已經(jīng)成功在手機(jī)本地跑通,部分場景可以媲美60億參數(shù)模型在云端運(yùn)行結(jié)果。小米旗下人工智能助手小愛同學(xué)已開始升級(jí)AI大模型能力,正在開啟邀請測試。

而OPPO推出了基于 AndesGPT 打造的全新小布助手也即將開啟大型體驗(yàn)活動(dòng)。據(jù)介紹, AndesGPT 是 OPPO 安第斯智能云團(tuán)隊(duì)打造的基于混合云架構(gòu)的生成式大語言模型,升級(jí)后的小布助手將具備 AI 大模型能力,擁有更強(qiáng)的語義理解對話能力。此外,vivo將在今年10月左右推出新的OriginOS 4.0系統(tǒng),新系統(tǒng)將內(nèi)置AI大模型。

INT4量化技術(shù)讓端模型進(jìn)化成通用智能體

量化(quantization)和定點(diǎn)數(shù)計(jì)算取得了不錯(cuò)的成果。一方面是節(jié)省了空間,另外硬件定點(diǎn)數(shù)的計(jì)算效率也通常更高。

模型參數(shù)可以采用32位/比特浮點(diǎn)(FP32)格式表示,但不如以定點(diǎn)(fixed point)格式表示,因?yàn)檫@幾乎沒有精度損失,甚至更高,但計(jì)算量卻較低。定點(diǎn)數(shù)量化模型的位/比特越小,模型存儲(chǔ)越小,執(zhí)行加速越大,這種策略不僅可以減少占用的內(nèi)存,還可以減少與計(jì)算相關(guān)的功耗。

在CPU和DSP上對量化網(wǎng)絡(luò)延遲進(jìn)行基準(zhǔn)測試:與CPU浮點(diǎn)數(shù)相比,量化模型實(shí)現(xiàn)的速度提高了2-3倍;具有定點(diǎn)數(shù)SIMD功能的專用處理器(例如帶HVX的Qualcomm QDSP)提速高達(dá)10倍。

現(xiàn)在人們已經(jīng)證明,F(xiàn)P32訓(xùn)練的參數(shù)可以改成4位/比特整數(shù)(INT4)做推理,沒有顯著精度損失,甚至訓(xùn)練時(shí)候采用INT4也可以。與服務(wù)器上訓(xùn)練的模型一般采用32位浮點(diǎn)運(yùn)算(FP32)不同,端側(cè)大模型端基本上采用INT4計(jì)算,大大提高了端側(cè)的處理能力。

在量化技術(shù)的支持下,支持INT4計(jì)算的端側(cè)AI大模型很快會(huì)成功運(yùn)用到智能手機(jī)上,未來也將很快延伸到與智能手機(jī)芯片平臺(tái)相關(guān)的其它物聯(lián)終端產(chǎn)業(yè),如電腦、汽車電子、機(jī)器人、智能家居等,端側(cè)AI大模型將引領(lǐng)包括智能手機(jī)在內(nèi)的物聯(lián)網(wǎng)終端產(chǎn)品,加入到AI進(jìn)化的下一場產(chǎn)業(yè)革命中。

業(yè)內(nèi)人士表示,受限能耗、系統(tǒng)性能、模型迭代效率,邊際效益遞減等因素,模型的規(guī)模增長不會(huì)像過去幾年一樣高速,而是朝更高效的模型結(jié)構(gòu)(e.g. Sparse Activation),訓(xùn)練方式(Self-supervise),更高效的部署(e.g. Distillation)發(fā)展。

模型的感知和記憶能力會(huì)快速、全面超過人類水平,并且固化下來,形成通用化的應(yīng)用場景。而模型的動(dòng)態(tài)決策能力,復(fù)雜場景的應(yīng)變能力還有較大的發(fā)展空間。模型的可解釋性、可控性短期可能不會(huì)有比較大的突破,但是大的研究機(jī)構(gòu)會(huì)持續(xù)投入,并形成一些差異化的競爭力。

在虛擬世界(或者說是現(xiàn)在比較火的元宇宙),未來5~10年可能會(huì)先出現(xiàn)比較通用的智能體。原因是基于強(qiáng)化學(xué)習(xí)的相關(guān)技術(shù)在虛擬世界有較低的迭代成本和安全顧慮。

-

智能手機(jī)

+關(guān)注

關(guān)注

66文章

18504瀏覽量

180472 -

AI

+關(guān)注

關(guān)注

87文章

31141瀏覽量

269478 -

人工智能

+關(guān)注

關(guān)注

1792文章

47436瀏覽量

238981 -

大模型

+關(guān)注

關(guān)注

2文章

2490瀏覽量

2865

原文標(biāo)題:端側(cè)大模型到通用智能體——智能手機(jī)AI進(jìn)化的下一場革命(一)

文章出處:【微信號(hào):AIOT大數(shù)據(jù),微信公眾號(hào):AIOT大數(shù)據(jù)】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評(píng)論請先 登錄

相關(guān)推薦

全球智能手機(jī)中端市場份額大幅下滑

把握關(guān)鍵節(jié)點(diǎn),美格智能持續(xù)推動(dòng)端側(cè)AI規(guī)模化拓展

把握關(guān)鍵節(jié)點(diǎn),美格智能持續(xù)推動(dòng)端側(cè)AI規(guī)模化拓展

探索智能手機(jī)上的生成式AI

圖為大模型一體機(jī)新探索,賦能智能家居行業(yè)

能效比較GPGPU高一個(gè)數(shù)量級(jí),國產(chǎn)AI芯片讓端側(cè)AI大模型高質(zhì)量落地

谷歌Tensor G5芯片代工轉(zhuǎn)向臺(tái)積電,強(qiáng)化AI智能手機(jī)競爭力

后摩智能引領(lǐng)AI芯片革命,推出邊端大模型AI芯片M30

OPPO引領(lǐng)AI手機(jī)新時(shí)代,全面普及智能生活

英偉達(dá)宣布拆股 黃仁勛:下一場工業(yè)革命已開始

生成式 AI令智能手機(jī)UFS4.0進(jìn)階

OPPO發(fā)布1+N 智能體生態(tài)戰(zhàn)略,聯(lián)發(fā)科攜手OPPO打造AI手機(jī)生態(tài)

高通CEO:結(jié)合生成式AI的智能手機(jī)將引領(lǐng)新升級(jí)周期

AI技術(shù)的“革命”進(jìn)入智能手機(jī)市場,“魔法大模型”加持榮耀MagicOS 8.0

端側(cè)大模型到通用智能體——智能手機(jī)AI進(jìn)化的下一場革命(一)

端側(cè)大模型到通用智能體——智能手機(jī)AI進(jìn)化的下一場革命(一)

評(píng)論