原理講解

根據目標物塊的特征,首先通過機械結構使目標物塊每次被識別時,目標物塊都出現在攝像頭的固定角度,固定距離。這樣就保證了攝像頭每次識別目標物塊時,目標物塊都會出現在拍攝照片的固定像素范圍。

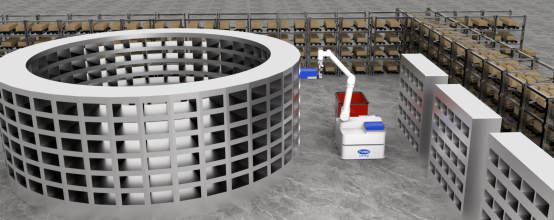

其次,根據目標物塊的特點(物塊之間只有顏色差異)只要完成對目標物塊出現范圍的像素點顏色的識別,就能判斷出具體是哪一個目標物塊。所以采用了對特定區(qū)域像素點的顏色識別算法。從演示視頻中可以看出,每次抓取物塊之前,都會先通過U型推手把目標物塊先固定在車身正前方的U型推手內如下圖。

此時補光燈進行補光,以減少環(huán)境光對識別結果的影響。從圖片也可以看出,識別環(huán)節(jié),攝像頭是正對目標物塊,而且距離很近,這個設計就保證了攝像頭拍攝到的大部分像素點都被目標物塊的顏色所填滿,增加了識別面積。

可以看到,攝像頭拍攝到的圖片,目標物塊幾乎填滿了整個圖片。接下來就通過旭日X3派進行顏色識別,使用旭日X3派借助OpenCV,通過HSV顏色模型,實現對目標物塊的顏色識別。

顏色識別

- 導入需要用的庫

import cv2 as cv import time import numpy as np import sys import os import serial import serial.tools.list_ports

os.system('ls /dev/tty[a-zA-Z]*') uart_dev= '/dev/ttyS3' #定義串口端口 baudrate = 115200 #波特率 ser = serial.Serial(uart_dev, int(baudrate), timeout=1)

- 選擇8號相機用作視頻獲取

cap_follow = cv.VideoCapture(8)

剪切獲取到的圖像,只顯示和處理一正中小塊

ret, frame = cap_color.read() #cv.imshow("frame", frame)#代碼在電腦上測試時候用于觀察,放在X3派上要注釋掉 ROI = frame[50:150, 50:200]#get useful ROI

獲取一幀圖片并進行裁剪,只保留小部分目標物塊的像素點,這有兩個原因:

(1)獲取到的一整幀圖片周圍有非目標物塊的周圍環(huán)境,如果納入計算過程的話會影響到最終識別結果

(2)縮小圖片體積,可以減少CPU負載,提升運算速度

- 把截取后的圖片轉化成HSV顏色模型,并創(chuàng)建三個數組分別用于存放轉化后HSV模型圖片中每一個像素點的H、S、V通道的值

hsv = cv.cvtColor(ROI, cv.COLOR_BGR2HSV) #cv.imshow("hsv", hsv) color_h = [] color_s = [] color_v = []

- 把轉化為HSV模型的圖片中每一個像素點都取出來,相加以后取平均值(取平均值是為了減少噪點對最后結果的影響。再把取平均值后的H、S、V三個通道的值賦給新的變量用于最后的比較)

color_h.append(np.mean(hsv[:,:,0])) color_s.append(np.mean(hsv[:,:,1])) color_v.append(np.mean(hsv[:,:,2])) h = color_h[0] s = color_s[0] v = color_v[0]

- 比較最終值和顏色范圍,確定識別結果,并通過串口把結果發(fā)送給下位機

if 35 <= h <= 77 and 43 <= s <= 255 and 46 <= v <= 255: print('green') ser.write(b'g') #red_h 10 --> 20 elif 0 <= h <= 20 and 43 <= s <= 255 and 46 <= v <= 255: print('red') ser.write(b'r') elif 156 <= h <= 180 and 43 <= s <= 255 and 46 <= v <= 255: print('red') elif 100 <= h <= 124 and 43 <= s <= 255 and 46 <= v <= 255: print('blue') ser.write(b'b') elif 0 <= h <= 180 and 0 <= s <= 255 and 0 <= v <= 46: print('black') ser.write(b'B') #white_v 221 --> 200 elif 0 <= h <= 180 and 0 <= s <= 30 and 180 <= v <= 255: print('white') ser.write(b'w') else: print('I do not know') ser.write(b'e')

解釋一下串口發(fā)送字符的含義:

g——green

r——red

b——blue

B——black

w——write

e——error

(最后'e'一個表示識別的顏色不在既定范圍內)

為什么選用使用HSV顏色模型而不是用RGB?

RGB 是我們接觸最多的顏色空間,由三個通道表示一幅圖像,分別為紅色(R),綠色(G)和藍色(B)。這三種顏色的不同組合可以形成幾乎所有的其他顏色。但是人眼對于這三種顏色分量的敏感程度是不一樣的,在單色中,人眼對紅色最不敏感,藍色最敏感,所以 RGB 顏色空間是一種均勻性較差的顏色空間。如果顏色的相似性直接用歐氏距離來度量,其結果與人眼視覺會有較大的偏差。對于某一種顏色,我們很難推測出較為精確的三個分量數值來表示。所以,RGB 顏色空間適合于顯示系統(tǒng),卻并不適合于圖像處理。

在圖像處理中使用較多的是 HSV 顏色空間,它比 RGB 更接近人們對彩色的感知經驗,可非常直觀地表達顏色的色調、鮮艷程度和明暗程度,方便進行顏色的對比(詳細解釋可參見地平線開發(fā)者社區(qū)。

在 HSV 顏色空間下,比 BGR 更容易跟蹤某種顏色的物體,常用于分割指定顏色的物體。

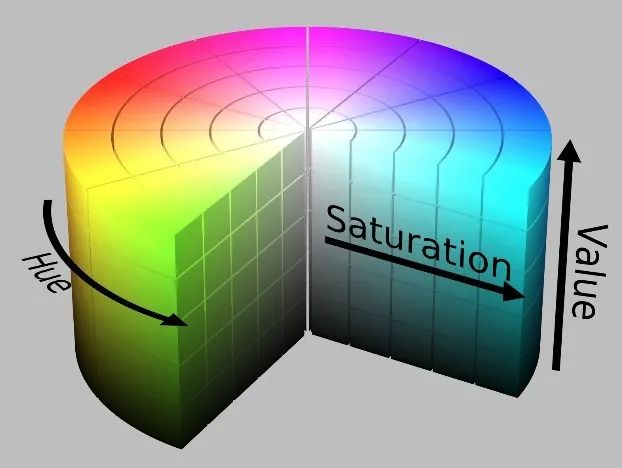

HSV 表達彩色圖像的方式由三個部分組成:Hue(色調、色相)、Saturation(飽和度、色彩純凈度)、Value(明度)。用下圖圓柱體來表示 HSV 顏色空間,圓柱體的橫截面可以看做是一個極坐標系 ,H 用極坐標的極角表示,S 用極坐標的極軸長度表示,V 用圓柱中軸的高度表示。

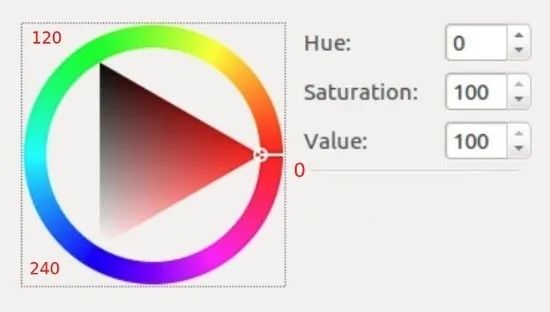

Hue 用角度度量,取值范圍為0~360°,表示色彩信息,即所處的光譜顏色的位置,表示如下:

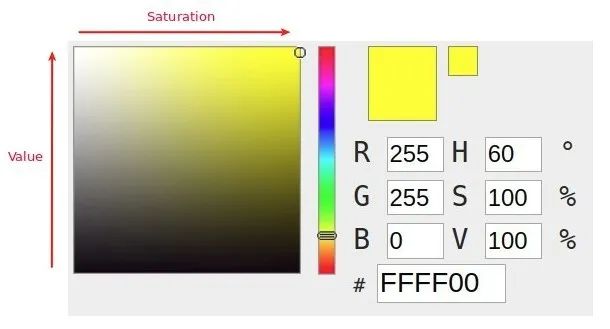

顏色圓環(huán)上所有的顏色都是光譜上的顏色,從紅色開始按逆時針方向旋轉,Hue=0 表示紅色,Hue=120 表示綠色,Hue=240 表示藍色等等。在 GRB中 顏色由三個值共同決定,比如黃色為即(255,255,0);在HSV中,黃色只由一個值決定,Hue=60即可。HSV 圓柱體的半邊橫截面(Hue=60):

其中水平方向表示飽和度,飽和度表示顏色接近光譜色的程度。飽和度越高,說明顏色越深,越接近光譜色飽和度越低,說明顏色越淺,越接近白色。飽和度為0表示純白色。取值范圍為0~100%,值越大,顏色越飽和。

豎直方向表示明度,決定顏色空間中顏色的明暗程度,明度越高,表示顏色越明亮,范圍是 0-100%。明度為0表示純黑色(此時顏色最暗)。

動作實現

下位機負責所有機器人動作的控制,包括直線行駛、轉彎、轉圈、目標物塊抓取、放置等等,此處先講解目標物塊抓取動作部分。先看機械設計,機器人前方的圓柱形帶傳動可收納式抓手是靠兩個原動件提供動力的。

(舵機,藍色部分)

(舵機,藍色部分) (42步進電機,藍色部分)

(42步進電機,藍色部分)舵機提供動力控制抓手的開合,用于夾取目標物塊和釋放目標物塊;42步進電機控制傳送帶從而控制抓手,用于使抓手升降。

從視頻可以看出,每抓取一個物塊需要五個動作:

(1)抓手下降到一半高度;

(2)抓手張開;

(3)抓手下降到最低點;

(4)抓手閉合,抓取物塊;

(5)抓手上升到最高點。

代碼講解

由于初步設計時時間較緊,故選擇Arduino該平臺作為主控。學習舵機、步進電機控制,有很多種主控方案可以選擇,大家可按需選擇。代碼主要部分:

- 導入需要用到的庫、創(chuàng)建舵機、步進電機對象

#include #include AccelStepper stepperArm(1,armstepPin,armdirPin); Servo armServo;

- 在 setup函數里面對舵機、步進電機進行初始化

stepperArm.setMaxSpeed(1200.0); stepperArm.setAcceleration(400.0); armServo.attach(8); armServo.write(servoMid);

- 抓取動作控制(五個步驟)

void Get(){ //抓手下降一半 if (getTurns == 0){ stepperArm.moveTo (armStepperHigh1); //Serial.println("我是抓手,我現在在下降"); if (stepperArm.currentPosition() == armStepperHigh1){ getTurns ++; } } //抓手張開一點 if ( getTurns == 1){ for (armAngle = servoMid; armAngle <= servoEnd; armAngle ++) { armServo.write(armAngle); delay(5); } getTurns ++; } //抓手下降到最低端 if (getTurns == 2){ stepperArm.moveTo (armStepperHigh2); if (stepperArm.currentPosition() == armStepperHigh2){ getTurns ++; } } //抓取物塊 if ( getTurns == 3){ //delay(2000); for (armAngle = servoEnd; armAngle >= servoMid; armAngle --) { armServo.write(armAngle); delay(5); } getTurns ++; } //上升抓手到最高位置 if (getTurns == 4){ stepperArm.moveTo (armStepperHigh0); if(stepperArm.currentPosition() == armStepperHigh0){ getTurns = 0; ifOverGet = 1; } } }

原作者:衣柜旁的小明

原鏈接:本文轉自地平線開發(fā)者社區(qū)

-

嵌入式

+關注

關注

5092文章

19176瀏覽量

307572 -

機器人

+關注

關注

211文章

28632瀏覽量

208336 -

人工智能

+關注

關注

1796文章

47643瀏覽量

240206

發(fā)布評論請先 登錄

相關推薦

【「具身智能機器人系統(tǒng)」閱讀體驗】2.具身智能機器人的基礎模塊

【「具身智能機器人系統(tǒng)」閱讀體驗】2.具身智能機器人大模型

【「具身智能機器人系統(tǒng)」閱讀體驗】1.初步理解具身智能

搬運碼垛機器人的特性和運用方式

基于FPGA EtherCAT的六自由度機器人視覺伺服控制設計

富唯智能案例|3D視覺引導機器人抓取鞋墊上下料

智能搬運機器人系列之利用X3派實現目標物塊的識別與抓取

智能搬運機器人系列之利用X3派實現目標物塊的識別與抓取

評論