0. Take-away messages

提出了一個簡單有效的視覺語言模型架構,BridgeTower,通過在頂層單模態層和每個跨模態層之間建立橋梁,成功地引入了不同語義層次的視覺和文本表示,從而提高了跨模態編碼器中注意力頭的多樣性,并在各種任務上實現了突出的性能改進。

在公平的評估設置下,與Two-Tower架構的METER模型相比,BridgeTower顯著地提高了模型的多模態表示能力。

僅使用400萬張圖片進行視覺語言預訓練,BridgeTower在各種視覺語言下游任務上取得了十分強大的性能,擊敗了許多用更多數據和參數進行預訓練的強大模型。

BridgeTower可以適用于不同的視覺、文本或跨模態編碼器。

1. 背景與動機

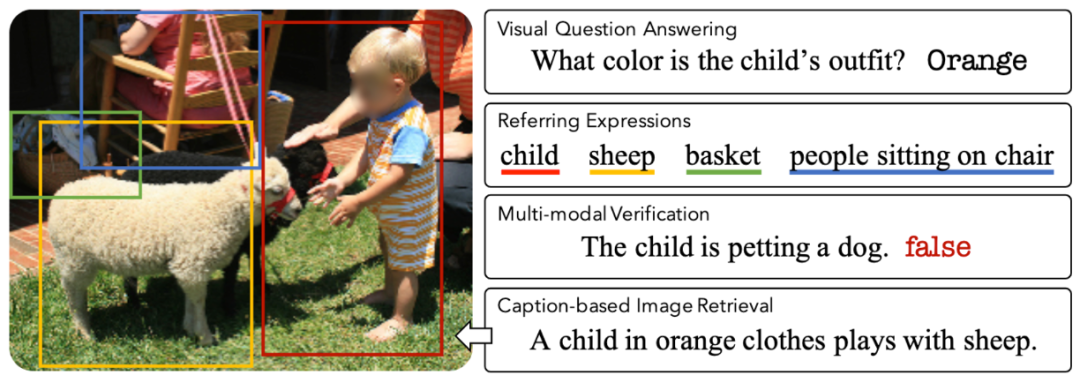

視覺語言任務示例

圖源:12-in-1: Multi-Task Vision and Language Representation Learning

視覺語言研究的目標,是訓練一個能夠理解圖像和文本的智能AI系統。上圖展示了一些流行的視覺語言任務。視覺問答是其中最著名的任務之一,它需要根據輸入圖像來回答和圖片相關的問題。

各類視覺語言模型

自2019年以來,在大規模圖像-文本對的自監督預訓練的幫助下,基于Transformer的視覺語言模型取得了顯著的進展。其中,具有雙塔結構的視覺語言 (VL) 模型在視覺語言表示學習中占主導地位。基于不同的文本和視覺編碼器,人們提出了各種模型架構和預訓練目標。從模型架構的角度來看,近期大多數的VL工作,可以看作是由三個模塊組成的雙塔架構,即文本編碼器、視覺編碼器,以及在它們之上的跨模態融合模塊。不同的VL模型在這三個模塊的設計上有所不同。

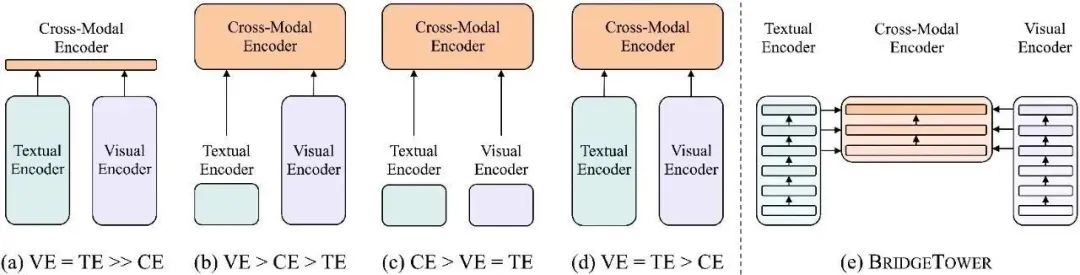

視覺語言模型架構簡述

圖(a)-(d)是目前的四類視覺語言模型。圖(e)簡要說明了BridgeTower的模型結構。VE、TE和CE分別是視覺編碼器、文本編碼器和跨模態編碼器的簡稱。每個矩形的高度代表其相對計算成本。本圖受到了ViLT: Vision-and-Language Transformer Without Convolution or Region Supervision的啟發。

目前的VL模型要么使用輕量級的單模態編碼器,并學習在深度跨模態編碼器中同時提取、對齊和融合兩種模態,要么將預訓練的深層單模態編碼器的最后一層單模態表示,送入頂部的跨模態編碼器中。這兩種方法都有可能限制視覺-語言表示的學習,并進一步限制模型的性能。

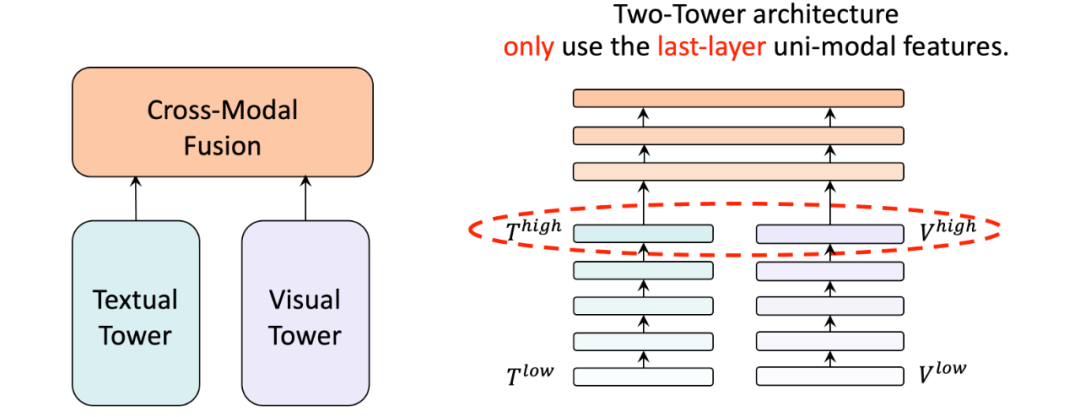

動機

如果我們深入雙塔結構的單模態塔 (編碼器) ,例如METER模型。我們可以發現他們只將最后一層的單模態特征直接送入頂部的跨模態融合模塊,忽略了深層單模態塔的不同層的語義信息。我們自然地想到,能否在不同層的預訓練單模態塔和跨模態融合模塊之間建立起橋梁,以充分利用多層單模態特征?

架構對比

因此,我們提出了BridgeTower架構。與雙塔架構不同,BridgeTower在跨模態融合模塊和單模態編碼器之間建立起了多座橋梁。二者的主要區別在于,雙塔結構只融合最后一層的特征,而BridgeTower則逐漸融合單模態編碼器頂部的多層特征。

2. 模型架構

模型架構

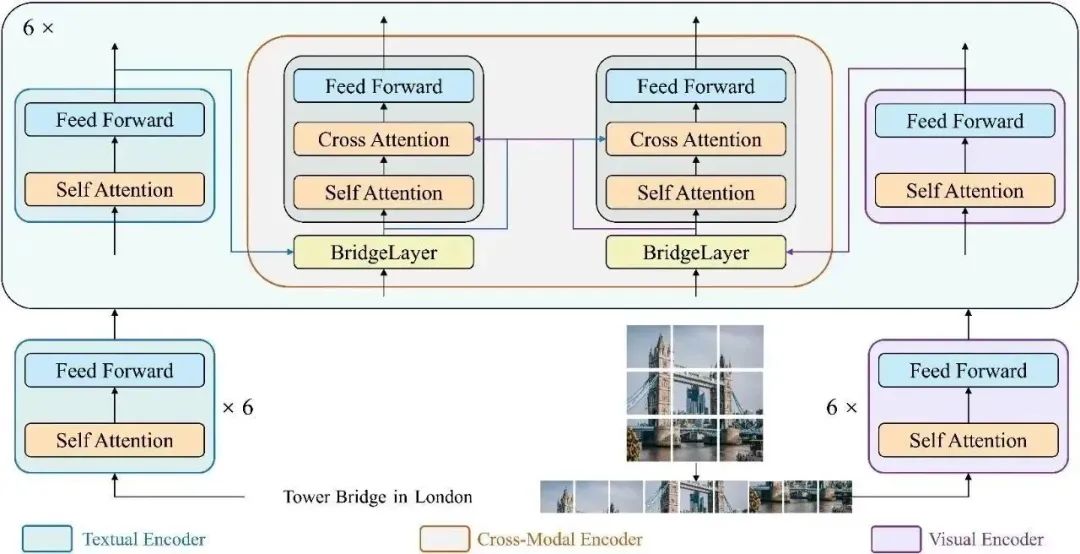

這里我們展示了BridgeTower的詳細架構圖。具體而言,我們采用12層的RoBERTa-base和12層的CLIP-ViT-B作為單模態編碼器。跨模態編碼器為6層,每一層都添加了BridgeLayer來與單模態編碼器的頂部6層建立連接。

這使得預訓練單模態編碼器中的不同語義層次的視覺和文本表示,通過BridgeLayer與跨模態表示進行融合,從而促進了跨模態編碼器中,高效的,自下而上的跨模態對齊與融合。需要注意的是,BridgeTower架構適用于不同的視覺、文本或跨模態編碼器。

3. 設計選擇

我們對BridgeTower的不同設計選擇進行了廣泛的實驗。

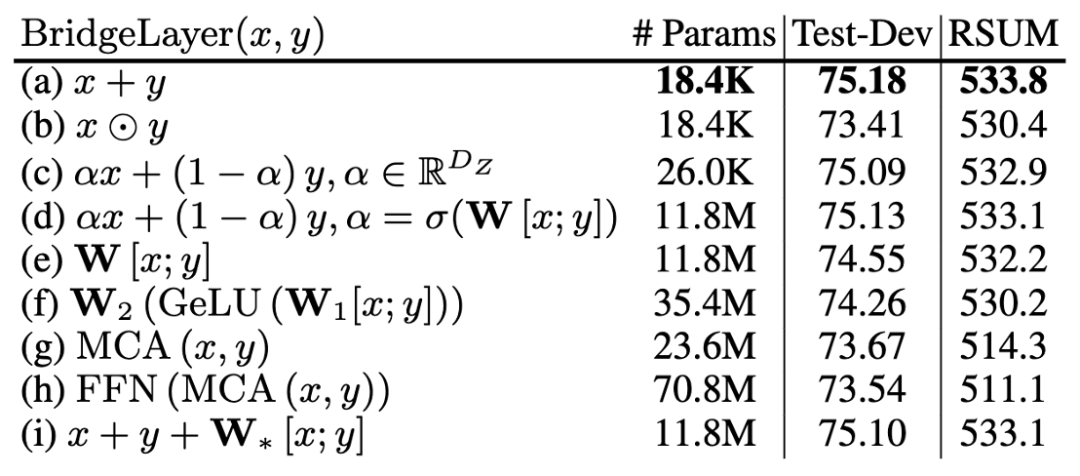

3.1 BridgeLayer的定義

bridge-layer

首先是BridgeLayer的定義,也就是單模態信息與跨模態信息如何在BridgeLayer中融合。

上表展示了不同定義的BridgeLayer的參數量和其在VQAv2和Flickr30K數據集上的性能。RSUM表示圖文檢索任務的召回度量之和。

表示前一層輸出的跨模態表示。

表示相應的單模態表示。我們省略了每一行中使用的 。有些出乎意料但又合乎情理的是,第一行中的 使用最小的參數量得到了最好的結果。

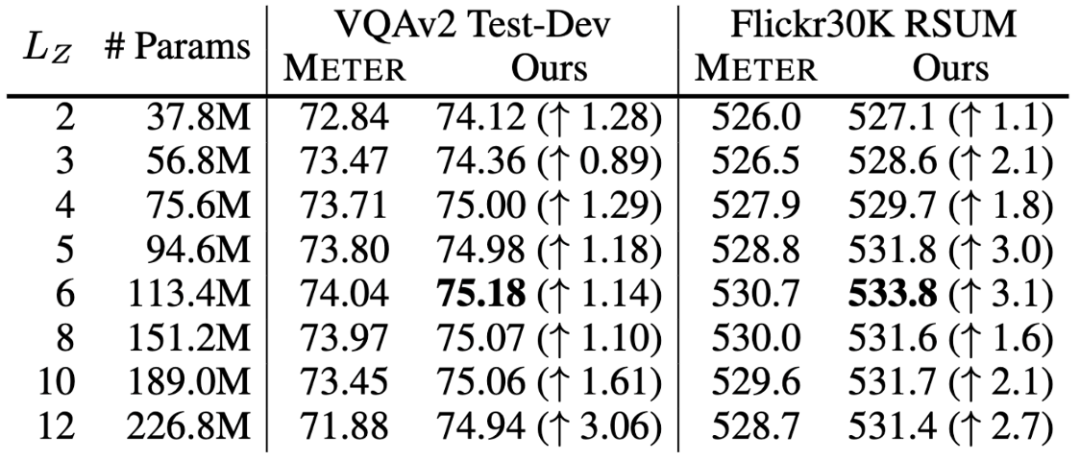

3.2 Cross-Modal Layer的數量

cross-modal-layer

接著我們基于12層的文本和視覺編碼器,研究不同數量的跨模態層對性能的影響。

表示跨模態層的數量,并且BridgeTower使用Top-的單模態表示作為跨模態層的輸入。我們在兩個數據集上比較不同下,METER和BridgeTower的性能情況,我們發現更多的跨模態層并不能不斷提高性能。這可能是由于

更多的跨模態層需要更多的訓練數據。

頂層的單模態表示有利于跨模態對齊和融合,而底層的單模態表示可能不利于,甚至是有害于跨模態表示的學習。雖然METER和BridgeTower之間唯一的區別是BridgeLayers,但BridgeTower在不同數量的跨模態層中始終獲得了一致的性能提升。

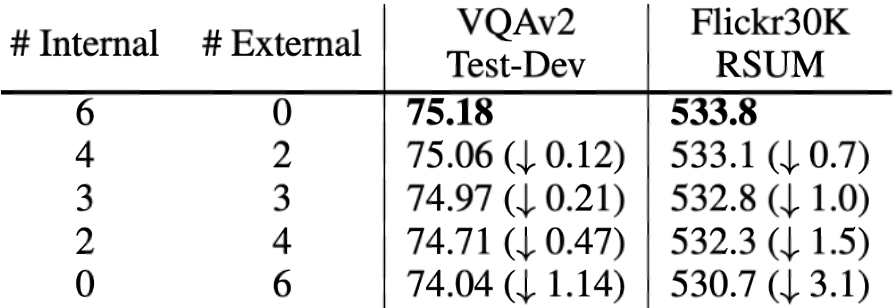

3.3 BridgeLayer的數量

internal-external

最后是BridgeLayer的數量,也就是在使用相同數量的跨模態層時,應該加入多少個BridgeLayer。

為了充分比較BridgeTower和雙塔結構的METER模型,我們試圖建立一個從BridgeTower到Two-Tower逐漸變化的情景。為了進行公平的比較,我們使用共計6個跨模態層,并將它們分為外部 (External) 跨模態層和內部 (Internal) 跨模態層。二者的區別在于內部跨模態層具有BridgeLayer,而外部跨模態層沒有。

第一行顯示了6個跨模態層均為內部層的BridgeTower的結果。然后,我們逐漸增加外部層,減少內部層。我們發現在兩個數據集上的性能都出現了穩定的下降。

最后一行顯示了雙塔結構的METER模型的性能。這表明BridgeTower通過BridgeLayers,將單模態編碼器的頂層與跨模態編碼器的每一層連接起來,可以顯著提高性能。

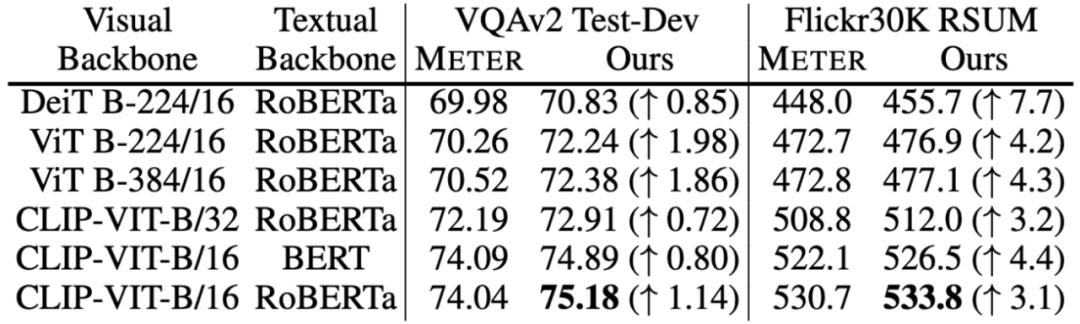

3.4 單模態編碼器

最后我們嘗試了不同的視覺和文本編碼器作為BridgeTower的預訓練單模態編碼器,并直接對下游任務進行微調,以進一步研究BridgeLayers帶來的影響。我們發現,對于不同的預訓練視覺和文本編碼器,BridgeTower的性能都持續且顯著地優于METER的性能。

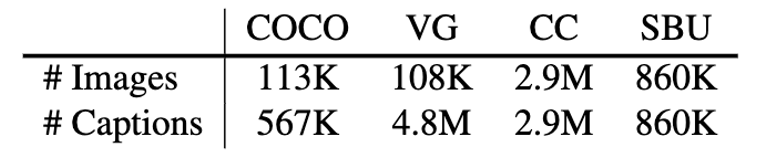

4. 實驗效果

我們基于公共圖文對數據集對BridgeTower進行預訓練,如上表所示,大約共計400萬張獨立圖片,900萬對圖文對。我們使用通用的掩碼語言建模 (Masked Language Modeling, MLM) 和圖文匹配 (Image-Text Matching, ITM) 任務作為預訓練任務。所有的預訓練設置與預訓練參數都與METER一致,以提供METER和BridgeTower之間的公平比較。

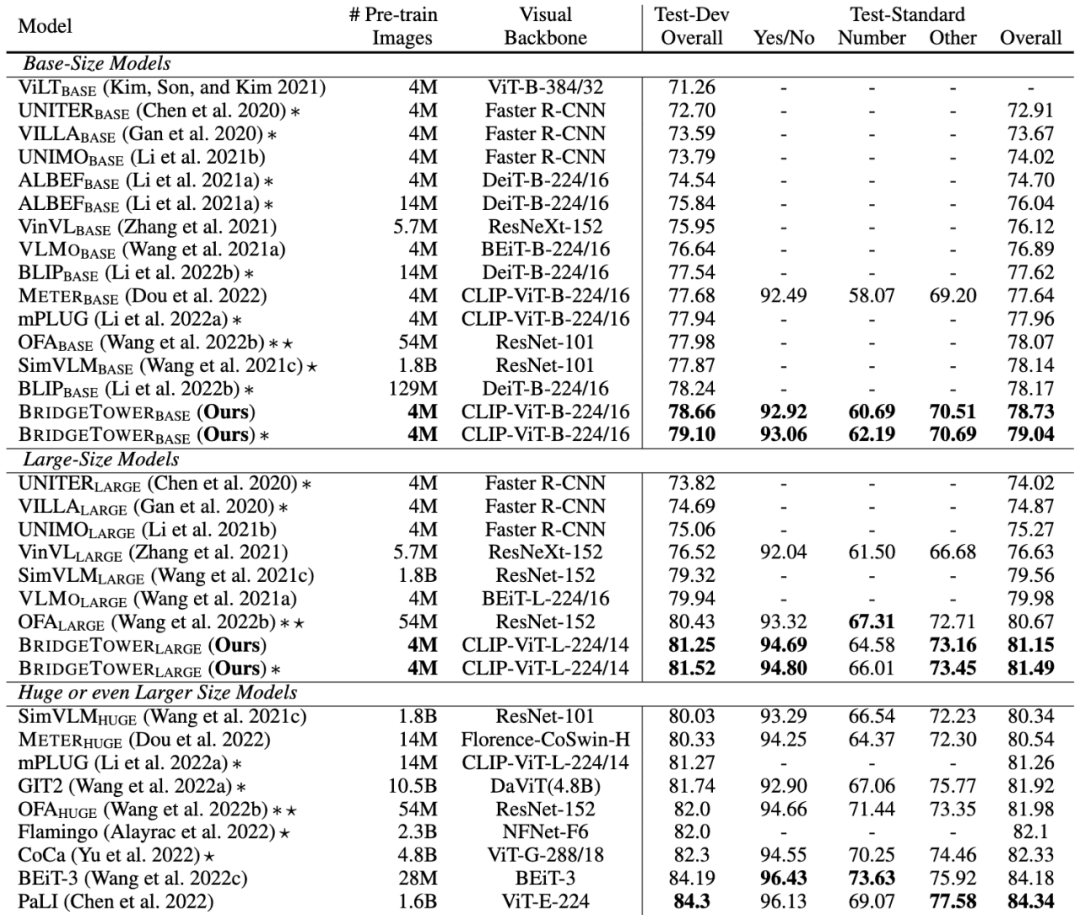

上圖展示了BridgeTower模型在視覺問答 (Visual Question Answering) 的VQAv2數據集上的Base和Large兩種Size的模型性能。在視覺-語言預訓練中,我們的Base模型只使用了400萬張圖片進行預訓練,就在VQAv2基準上取得了令人印象深刻的表現。

而且,METER和BridgeTower使用相同的文本編碼器、視覺編碼器和跨模態融合機制。只需將METER模型的Two-Tower架構改為BridgeTower架構,在相同的預訓練數據和幾乎可以忽略不計的額外參數和計算成本下,VQAv2數據集的Test-Standard性能就可以輕松提高1.09。BridgeTower的Large模型在VQAv2數據集上更是取得81.15的Test-Standard性能。

值得注意的是,BridgeTower超過了許多使用10倍甚至100倍的圖像進行VL預訓練的Base模型與Large模型,擊敗了許多用更多數據和參數進行預訓練的強大模型。

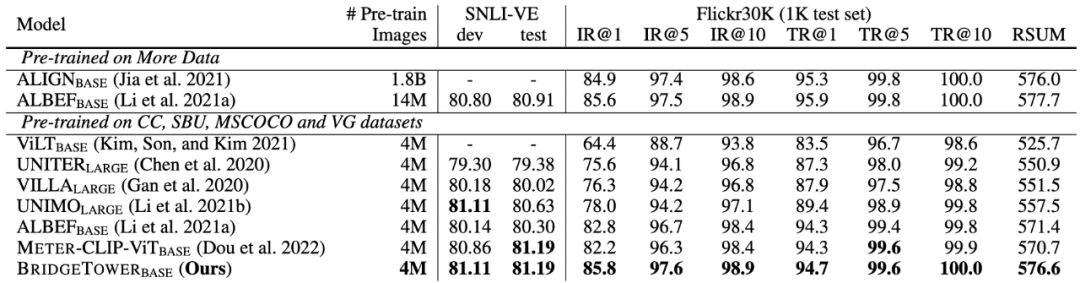

類似的趨勢也出現在視覺蘊含 (Visual Entailment) 和圖像-文本檢索 (Image-Text Retrieval) 任務中。特別是在Flickr30K數據集上,BridgeTower的Base模型帶來了5.9點收益。

5. 可視化結果

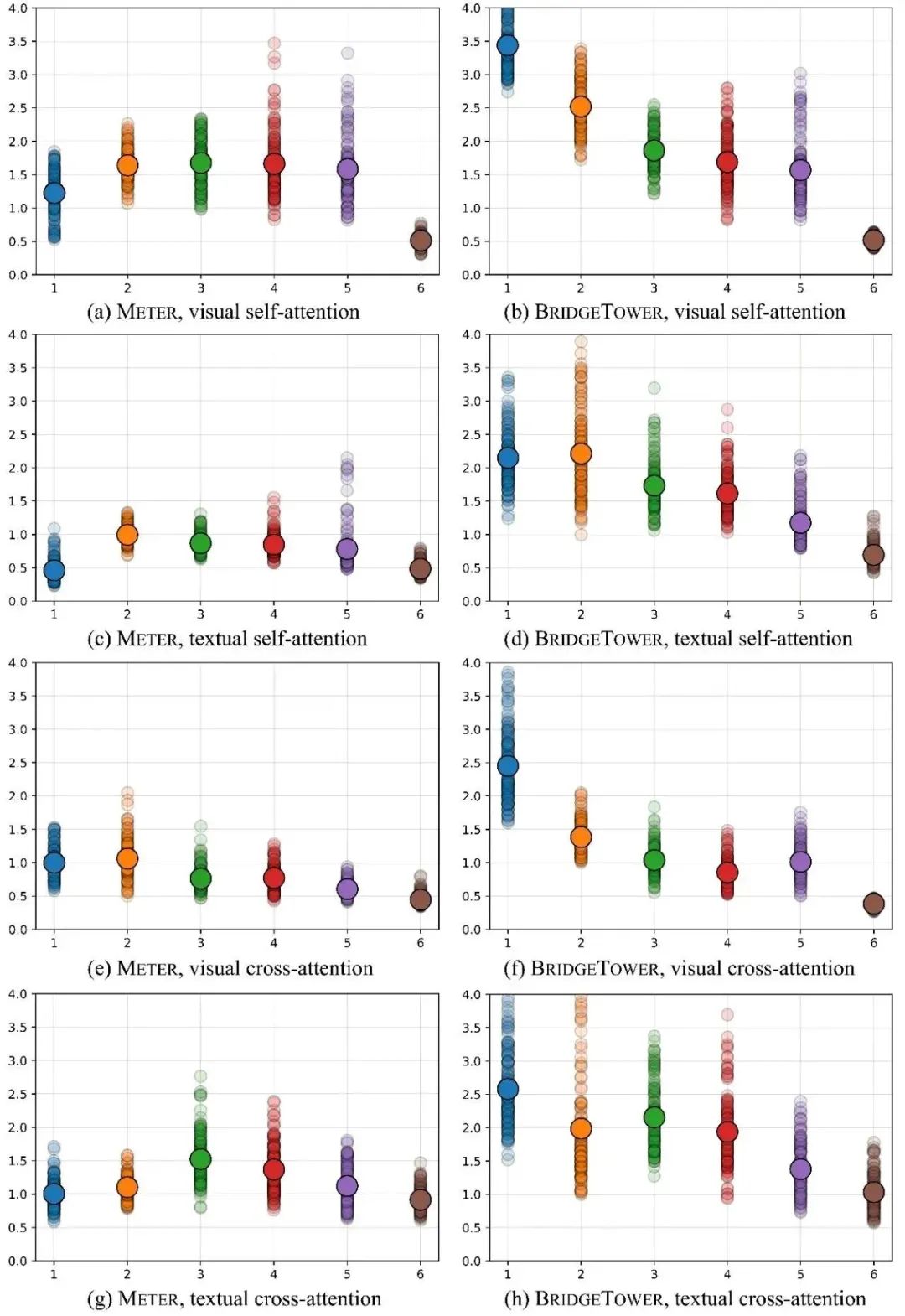

為了進一步研究性能提高的原因,我們通過分析每個跨模態層中,不同注意力頭的注意力權重分布之間的KL散度,來比較雙塔架構的METER模型和我們的BridgeTower架構。

KL散度可以被看作是注意力頭的多樣性。較高或較低的KL散度表示不同的注意力頭之間,關注的token更加不同或更加相似。

圖中的小點代表不同注意力頭的注意力分布間的KL散度,大點表示同層KL散度的均值。上圖對比了METER和BridgeTower模型的跨模態編碼器中,視覺/文本部分的自我/交叉注意力層之間的區別。

上圖展示了兩個模型的跨模態編碼器的視覺和文本部分的自注意力以及交叉注意力的注意力頭的多樣性。圖中存在兩個明顯的趨勢:

對于BridgeTower來說,注意力頭的多樣性隨著層的深入而逐漸變小,但對于METER來說,注意力頭的多樣性隨著層的深入而逐漸變大,然后變小。

BridgeTower每層的注意力頭的多樣性明顯大于METER,尤其是第1層至第5層。

因此,對于跨模態編碼器的視覺和文本部分的自注意力以及交叉注意力的不同注意力頭,與METER相比,BridgeTower能夠關注到更多不同的標記 (token)。

我們將此歸功于我們提出的BridgeLayers,它將單模態編碼器的頂層與跨模態編碼器的每一層連接起來。不同語義層次的視覺和文本表示通過BridgeLayer與跨模態表示進行融合,從而促進了跨模態編碼器每一層的更有效和更豐富的跨模態對齊和融合。

6. 結論

在本文中,我們提出了BridgeTower,它引入了多個BridgeLayer,在單模態編碼器的頂層和跨模態編碼器的每一層之間建立連接。這使得預訓練單模態編碼器中的不同語義層次的視覺和文本表示,通過BridgeLayer與跨模態表示進行融合,從而促進了跨模態編碼器中,高效的,自下而上的跨模態對齊與融合。

僅使用400萬張圖像進行視覺語言預訓練,BridgeTower在各種下游的視覺-語言任務中取得了非常強大的性能。特別是在VQAv2數據集上,BridgeTower達到了78.73%的準確率,在相同的預訓練數據和幾乎可以忽略不計的額外參數和計算成本下,比Two-Tower架構的METER模型高出了1.09%的準確率。值得注意的是,當進一步擴展該模型時,BridgeTower達到了81.15%的準確率,甚至超過了一些在更大數量級的數據集上使用更多參數進行預訓練的強大模型。

審核編輯:劉清

-

編碼器

+關注

關注

45文章

3651瀏覽量

134770

原文標題:AAAI2023 | BridgeTower: 在視覺語言表示學習中建立編碼器間的橋梁

文章出處:【微信號:zenRRan,微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

在視覺語言表示學習中建立編碼器間的橋梁

在視覺語言表示學習中建立編碼器間的橋梁

評論