介紹

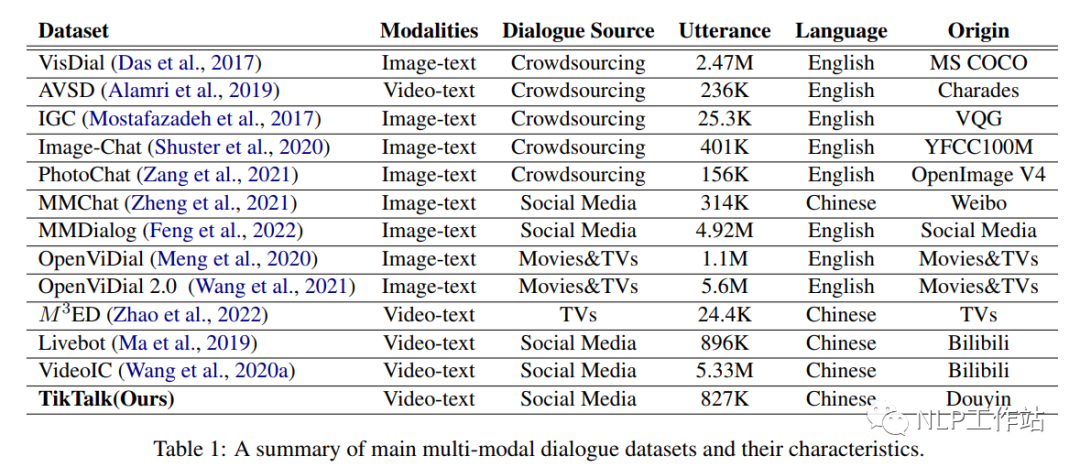

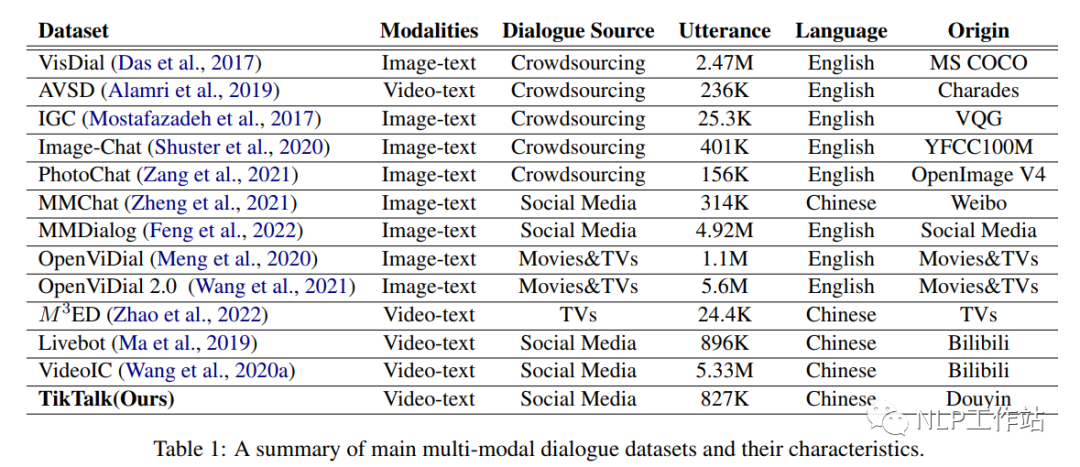

隨著大量預(yù)訓(xùn)練語(yǔ)言模型在文本對(duì)話任務(wù)中的出色表現(xiàn),以及多模態(tài)的發(fā)展,在對(duì)話中引入多模態(tài)信息已經(jīng)引起了大量學(xué)者的關(guān)注。目前已經(jīng)提出了各種各樣的多模態(tài)對(duì)話數(shù)據(jù)集,主要來自電影、電視劇、社交媒體平臺(tái)等,但這些數(shù)據(jù)與真實(shí)世界的日常聊天對(duì)話之間還是存在一些差距。

對(duì)話形式過于同質(zhì)化。視頻中的現(xiàn)場(chǎng)評(píng)論缺乏明確背景,更偏向于評(píng)論,并充斥著重復(fù)的數(shù)據(jù)用來活躍氣氛。而從影視劇中提取出來的對(duì)話內(nèi)容或解說員根據(jù)指定圖片提出的對(duì)話內(nèi)容,都不是現(xiàn)實(shí)對(duì)話場(chǎng)景中自然生成的聊天,而是為了推動(dòng)情節(jié)發(fā)展設(shè)計(jì)的一些人物臺(tái)詞或高度依賴形象。

缺乏對(duì)話的時(shí)間順序。現(xiàn)實(shí)世界的多模態(tài)對(duì)話場(chǎng)景可能包含具有時(shí)間順序的不同上下文,而目前大多數(shù)數(shù)據(jù)集中的靜態(tài)圖片所能提供的信息有限,限制了對(duì)話參與者在主題方面的多樣性。并且不同的語(yǔ)言語(yǔ)境中存在著獨(dú)特的表達(dá)方式和流行文化,很難進(jìn)行翻譯或遷移到其他語(yǔ)言。

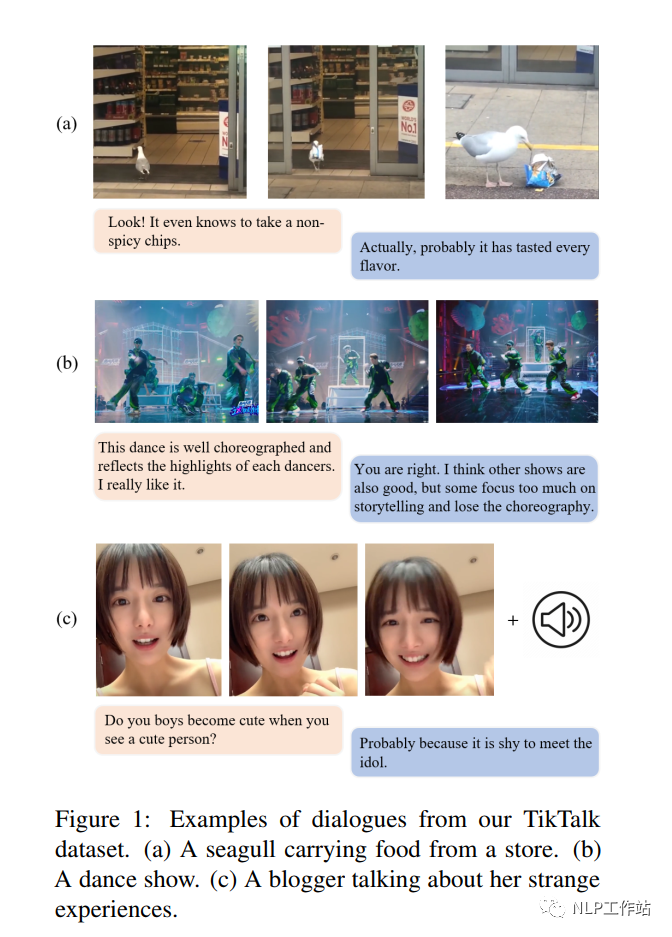

因此,該論文提出了具有獨(dú)特特色的中文多模態(tài)對(duì)話數(shù)據(jù)集-TikTalk。TikTalk是基于視頻的真實(shí)世界人類聊天語(yǔ)料庫(kù),是開放域的,并由用戶自發(fā)生成非故意創(chuàng)建的數(shù)據(jù)集。其中,與圖像、音頻和外部知識(shí)相關(guān)的回復(fù)占比分別為42%、10%和34%,如圖1(a)所示,聊天源于視頻內(nèi)容,圖1(b)中的“其他表演”和舞蹈分析需要一些外部知識(shí),圖1(c)中的對(duì)話建立在音頻內(nèi)容之上。

最后采用排名、相關(guān)性和多樣性三種度量指標(biāo)對(duì)現(xiàn)有生成模型進(jìn)行分析,發(fā)現(xiàn)模型與人類表現(xiàn)仍有很大差距,在TikTalk數(shù)據(jù)集上有相當(dāng)大的改進(jìn)空間。

TikTalk Dataset

TikTalk數(shù)據(jù)集從抖音上采集,其抖音擁有超過25個(gè)大類的視頻,如教育、美食、游戲、旅游、娛樂等。每個(gè)視頻都有作者提供的標(biāo)題和用戶的評(píng)論。用戶可以在視頻和一級(jí)評(píng)論下進(jìn)行進(jìn)一步的討論,這接近于現(xiàn)實(shí)世界面對(duì)面的多模態(tài)聊天場(chǎng)景。

Data Construction

該論文收集了2021年在抖音上發(fā)布的視頻,以及標(biāo)題、評(píng)論和回復(fù)。為了保護(hù)隱私,沒有抓取任何用戶信息。由于視頻基數(shù)大,視頻質(zhì)量良莠不齊,大部分視頻只有一級(jí)評(píng)論,無法構(gòu)成對(duì)話語(yǔ)料庫(kù)。由于視頻高贊、評(píng)論高贊表示用戶評(píng)分高,因此在爬取數(shù)據(jù)時(shí)通過點(diǎn)贊數(shù)過濾低質(zhì)量的視頻和評(píng)論。

數(shù)據(jù)清理時(shí),用正則表達(dá)式過濾掉句子中無用的內(nèi)容,例如:“@某人”、重復(fù)的詞語(yǔ)、以及一些不道德的言論等;此外,評(píng)論中帶有的表情符號(hào),通常可以表明用戶的情緒,因此,從對(duì)話中提取它們,并作為附加信息。

Data Statistics

該論文共爬取153340個(gè)視頻,最終獲取38703個(gè)視頻和367670個(gè)對(duì)話來構(gòu)建TikTalk數(shù)據(jù)集。將訓(xùn)練集、驗(yàn)證集和測(cè)試集按照35703、1000和2000進(jìn)行劃分,詳細(xì)統(tǒng)計(jì)數(shù)據(jù)見表2。

可以看出,視頻平均長(zhǎng)度為34.03s,提供了豐富的視頻和音頻信息;每段對(duì)話的平均輪數(shù)為2.25,由于對(duì)話的文本上下文較短,回復(fù)更有可能來自視頻或外部知識(shí)。

Data Analysis

TikTalk數(shù)據(jù)集有如下幾個(gè)特征:

高度自發(fā)和自由,對(duì)話是由用戶觀看視頻后發(fā)起,沒有任何的預(yù)先的意圖及指導(dǎo),類似于現(xiàn)實(shí)世界中的日常閑聊。

多種模式,對(duì)話上下文包括相關(guān)的圖像、音頻和文本,提供了更多樣化的信息來源,同時(shí)也對(duì)聊天場(chǎng)景進(jìn)行了更多的限制,提高了回答的可信度標(biāo)準(zhǔn)。

開放領(lǐng)域的,由于社交平臺(tái)是開放域的,討論話題也十分豐富。

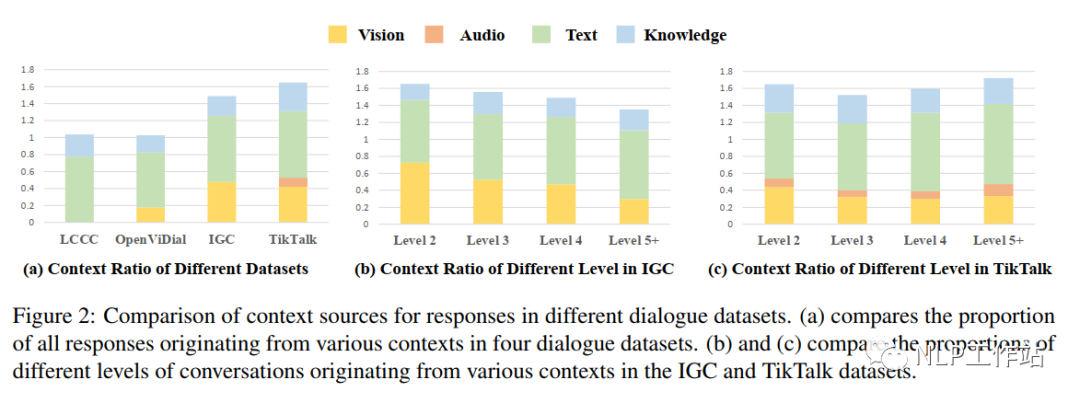

觀察數(shù)據(jù)發(fā)現(xiàn),對(duì)話回復(fù)中經(jīng)常包含與上下文信息相關(guān)的詞語(yǔ),例如:圖1(a)中的“it”為視頻中的“海鷗”,圖1(c)中討論了音頻描述的故事,圖1(b)中的回復(fù)中為上下文觀點(diǎn),并分析了視頻外的其他節(jié)目,與個(gè)人經(jīng)驗(yàn)及常識(shí)相關(guān)。因此,該論文分析了數(shù)據(jù)及中數(shù)據(jù)與各種信息相關(guān)的響應(yīng)占比,包括視頻中的視覺內(nèi)容和音頻內(nèi)容、文本內(nèi)容及隱形的外部知識(shí)。采用眾包的方式進(jìn)行數(shù)據(jù)標(biāo)注,并選擇另外其他三個(gè)具有代表性的對(duì)話數(shù)據(jù)集(每個(gè)數(shù)據(jù)集隨機(jī)選取300個(gè)樣本)進(jìn)行對(duì)比。

從回復(fù)中提取名詞和代詞,要求標(biāo)注人員判斷這些詞語(yǔ)或完整的回復(fù)是否是指:(1)視頻上下文;(2)音頻上下文;(3)文本上下文;(4)隱藏外部知識(shí);(5)其他。并且,回復(fù)可以涉及多種模式的信息。

四種數(shù)據(jù)的比較如圖2(a)所示。TikTalk數(shù)據(jù)除去文本上下文和外部知識(shí)后,信息源占比最高,表示視頻中的圖像和音頻可以提供更多的信息。來自外部知識(shí)的回復(fù)比例最高(約33%,說明),說明多模態(tài)上下文更豐富時(shí),會(huì)引入更多與當(dāng)前對(duì)話相關(guān)的新信息。

進(jìn)一步探究IGC和TikTalk之間的差異,研究當(dāng)對(duì)話輪數(shù)數(shù)增加時(shí),IGC和TikTalk對(duì)不同上下文的依賴性,如圖2(b)和(c)所示。IGC數(shù)據(jù)集中圖像與對(duì)話的比例顯著下降,而TikTalk數(shù)據(jù)集中沒有這種趨勢(shì)。可能是因?yàn)镮GC的每個(gè)對(duì)話中只使用一個(gè)圖像,隨著時(shí)間的推移,可用的信息越來越少。

Experiments

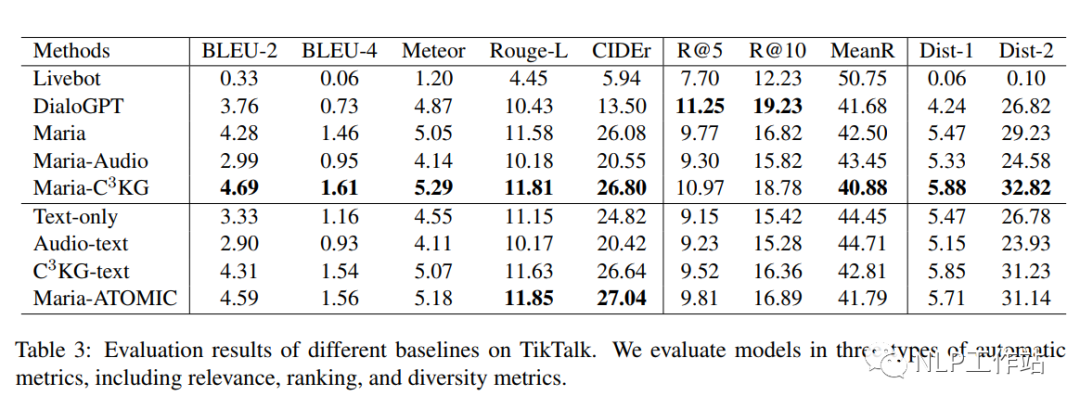

采用三個(gè)自動(dòng)指標(biāo)(相關(guān)性、排序、多樣性),從多個(gè)角度評(píng)估模型在TikTalk上的性能,

相關(guān)性:針對(duì)模型生成的回復(fù),與5個(gè)金標(biāo)準(zhǔn)計(jì)算BLEU-2、BLEU-4 、Meteor、Rouge-L和CIDEr。

排序:每段對(duì)話構(gòu)建一個(gè)100個(gè)樣本的候選集,其中包括5個(gè)金標(biāo)準(zhǔn)和95個(gè)隨機(jī)選擇的錯(cuò)誤回復(fù)。在推理階段,模型根據(jù)生成每個(gè)回復(fù)的對(duì)數(shù)似然分?jǐn)?shù)降序?qū)蜻x集進(jìn)行排序。計(jì)算Recall@K和Mean Rank。

多樣性:計(jì)算回復(fù)的Dist-1和Dist-2指標(biāo)。

從不同的任務(wù)和設(shè)置中評(píng)估一些最先進(jìn)的對(duì)話模型,包括:Livebot、DialoGPT、Maria、Maria-Audio、Maria-C3KG等。為了適應(yīng)TikTalk的特點(diǎn),在現(xiàn)有的基于圖像的對(duì)話模型中引入音頻和外部知識(shí)作為輸入,并分別對(duì)模型的性能進(jìn)行評(píng)估。

實(shí)驗(yàn)結(jié)果如表3所示,可以看出TikTalk與以前的任務(wù)和數(shù)據(jù)集有很大不同,需要更強(qiáng)大的多模態(tài)對(duì)話模型。

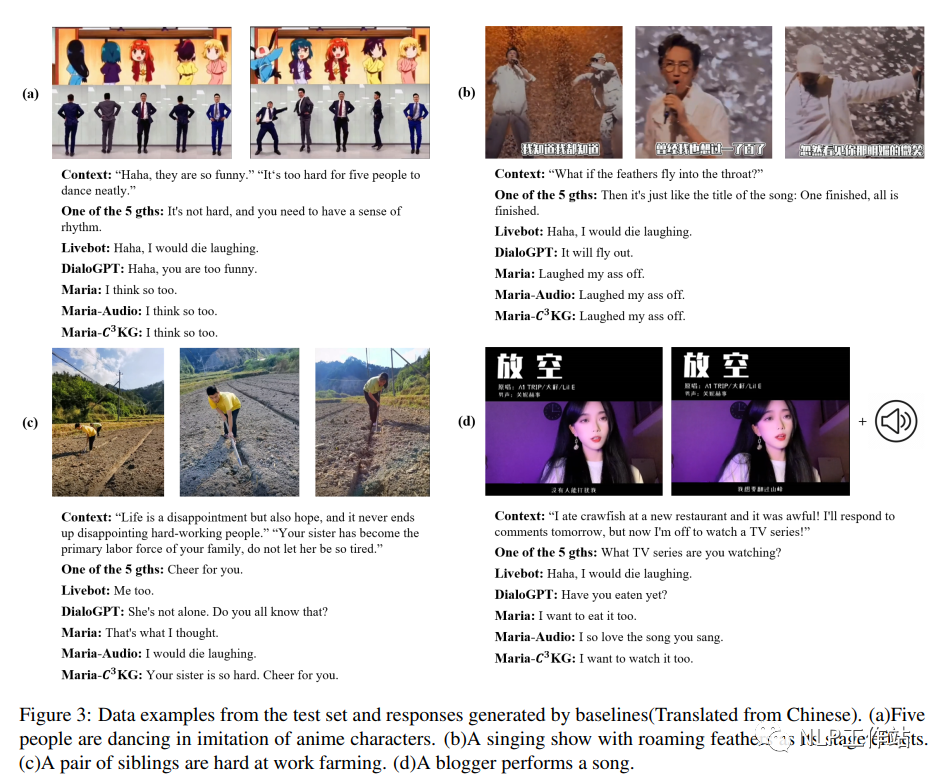

從測(cè)試集和上述基線模型生成結(jié)果中選擇了一些數(shù)據(jù)示例,對(duì)比結(jié)果如圖3所示。由于視頻場(chǎng)景和用戶個(gè)性的多樣性,TikTalk數(shù)據(jù)集需要復(fù)雜的理解和推理能力。雖然部分基線偶爾可以產(chǎn)生一些合理的響應(yīng),但它們遠(yuǎn)遠(yuǎn)不能滿足現(xiàn)實(shí)世界多模式對(duì)話的期望。

總結(jié)

中文數(shù)據(jù)集,且用且珍惜。

審核編輯:劉清

-

IGCT

+關(guān)注

關(guān)注

2文章

28瀏覽量

16108 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1208瀏覽量

24740

原文標(biāo)題:中文多模態(tài)對(duì)話數(shù)據(jù)集-TikTalk

文章出處:【微信號(hào):zenRRan,微信公眾號(hào):深度學(xué)習(xí)自然語(yǔ)言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

多文化場(chǎng)景下的多模態(tài)情感識(shí)別

關(guān)于多模態(tài)機(jī)器學(xué)習(xí)綜述論文

基于注意力神經(jīng)網(wǎng)絡(luò)的多模態(tài)情感分析方法

DocumentAI的模型、任務(wù)和基準(zhǔn)數(shù)據(jù)集

面向社交媒體的多模態(tài)屬性級(jí)情感分析

中文多模態(tài)對(duì)話數(shù)據(jù)集

多模態(tài)GPT:國(guó)內(nèi)發(fā)布一款可以在線使用的多模態(tài)聊天機(jī)器人!

多模態(tài)上下文指令調(diào)優(yōu)數(shù)據(jù)集MIMIC-IT

多模態(tài)數(shù)據(jù)定制服務(wù):提升智能化應(yīng)用的關(guān)鍵利器

VisCPM:邁向多語(yǔ)言多模態(tài)大模型時(shí)代

全球首個(gè)面向網(wǎng)聯(lián)智能車的通信與多模態(tài)感知數(shù)據(jù)集發(fā)布

更強(qiáng)更通用:智源「悟道3.0」Emu多模態(tài)大模型開源,在多模態(tài)序列中「補(bǔ)全一切」

一個(gè)真實(shí)閑聊多模態(tài)數(shù)據(jù)集TikTalk

一個(gè)真實(shí)閑聊多模態(tài)數(shù)據(jù)集TikTalk

評(píng)論