介紹

本文研究了利用認知語言處理信號(如眼球追蹤或 EEG 數(shù)據(jù))指導(dǎo) BERT 等預(yù)訓(xùn)練模型的問題。現(xiàn)有的方法通常利用認知數(shù)據(jù)對預(yù)訓(xùn)練模型進行微調(diào),忽略了文本和認知信號之間的語義差距。為了填補這一空白,我們提出了 CogBERT 這個框架,它可以從認知數(shù)據(jù)中誘導(dǎo)出細粒度的認知特征,并通過自適應(yīng)調(diào)整不同 NLP 任務(wù)的認知特征的權(quán)重將認知特征納入 BERT。

實驗結(jié)果表明:1)認知指導(dǎo)下的預(yù)訓(xùn)練模型在 10 個 NLP 任務(wù)上可以一致地比基線預(yù)訓(xùn)練模型表現(xiàn)更好;2)不同的認知特征對不同的 NLP 任務(wù)有不同的貢獻。基于這一觀察,我們給出為什么認知數(shù)據(jù)對自然語言理解有幫助的一個細化解釋;3)預(yù)訓(xùn)練模型的不同 transformer 層應(yīng)該編碼不同的認知特征,詞匯級的認知特征在 transformer 層底部,語義級的認知特征在 transformer 層頂部;4)注意力可視化證明了 CogBERT 可以與人類的凝視模式保持一致,并提高其自然語言理解能力。

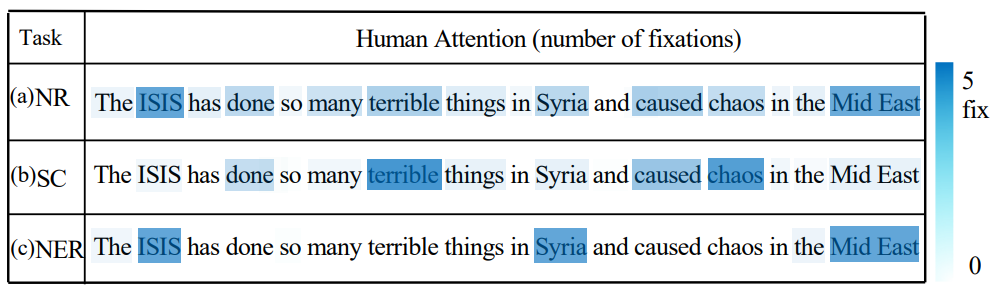

▲ 圖1. 人類眼球動作捕捉數(shù)據(jù)示意圖

背景與簡介

隨著預(yù)訓(xùn)練模型的出現(xiàn),當代人工智能模型在諸多任務(wù)上得到了超越人類的表現(xiàn)。隨著預(yù)訓(xùn)練模型取得越來越好的結(jié)果,但是研究人員對于預(yù)訓(xùn)練模型卻并沒有知道更多。

另一方面,從語言處理的角度來看,認知神經(jīng)科學(xué)研究人類大腦中語言處理的生物和認知過程。研究人員專門設(shè)計了預(yù)訓(xùn)練的模型來捕捉大腦如何表示語言的意義。之前的工作主要是通過明確微調(diào)預(yù)訓(xùn)練的模型來預(yù)測語言誘導(dǎo)的大腦記錄,從而納入認知信號。 然而,前人基于認知的預(yù)訓(xùn)練模型的工作,其思路無法對認知數(shù)據(jù)為何對 NLP 有幫助進行精細的分析和解釋。而這對于指導(dǎo)未來的認知啟發(fā)式 NLP 研究,即應(yīng)該從認知數(shù)據(jù)中誘導(dǎo)出什么樣的認知特征,以及這些認知特征如何對 NLP 任務(wù)做出貢獻,具有重要意義,否則這只是相當于往預(yù)訓(xùn)練模型加入更多的數(shù)據(jù),而對認知數(shù)據(jù)如何幫助預(yù)訓(xùn)練模型任然知之甚少。 例如,圖 1 顯示了以英語為母語的人的眼球追蹤數(shù)據(jù),其中圖 1(a) 說明了人類正常閱讀時的關(guān)注次數(shù)。圖 2(b) 和 (c) 分別顯示了在 NLP 任務(wù)中的情感分類(SC)和命名實體識別(NER)的關(guān)注次數(shù)。我們可以看到,對于同一個句子,在不同的 NLP 任務(wù)下,人類的注意力是不同的。特別是,對于情感分類任務(wù),人們更關(guān)注情感詞,如``terrible'和``chaos'。而對于 NER 任務(wù),人們傾向于關(guān)注命名的實體詞,如``ISIS'和``Syria'。但是先前的研究不能通過簡單地在認知數(shù)據(jù)上微調(diào)預(yù)先訓(xùn)練好的模型來給出這種細粒度的分析。 為了促進這一點,我們提出了 CogBERT,一個認知指導(dǎo)的預(yù)訓(xùn)練模型。具體來說,我們專注于使用眼球追蹤數(shù)據(jù)的效果,該數(shù)據(jù)通過追蹤眼球運動和測量固定時間來提供母語者的凝視信息。我們沒有直接在認知數(shù)據(jù)上對 BERT 進行微調(diào),而是首先根據(jù)認知理論提取心理語言學(xué)特征。

然后,我們在眼動數(shù)據(jù)中過濾掉統(tǒng)計學(xué)上不重要的特征(這意味著具有這些特征的單詞的人類注意力并不明顯高于/低于單詞的平均注意力)。隨后,我們通過在不同的 NLP 任務(wù)上進行微調(diào),將這些經(jīng)過認知驗證的特征納入 BERT。在微調(diào)過程中,我們將根據(jù)不同的 NLP 任務(wù),為每一類特征學(xué)習(xí)不同的權(quán)重。

方法

本文的方法主要基于一個二階段的過程,其中一個階段被用來產(chǎn)生基于認知的特征模板,第二個階段在于將這些認知啟發(fā)的特征模板通過特殊設(shè)定的架構(gòu)融入預(yù)訓(xùn)練模型當中。3.1 方法心理語言學(xué)研究表明 [1],人類閱讀能力的獲得體現(xiàn)在兩個方面。底層線索 (ower strands) 和高層線索 (upper strands)。底層線索(包括語音學(xué)、形態(tài)學(xué)等)隨著閱讀者的重復(fù)和練習(xí)而變得準確和自動。同時,高層線索(包括語言結(jié)構(gòu)、語義等)相互促進,并與底層線索交織在一起,形成一個熟練的讀者。即意味著,人類本質(zhì)上的語言習(xí)得能力,其中一個重要的關(guān)鍵是對文本中的一系列特征進行越來越熟練的提取和識別。 這意味著,人類的眼球動作行為一定程度上可以被語言特征所反應(yīng),受以往工作的啟發(fā),我們構(gòu)建了一個初始的認知特征集,包括使用 spaCy 工具 [2] 從文本中提取的 46 個細粒度的認知特征,并將其分為下層特征(詞級)和上層特征(語義/語法級)。我們對這 46 種語言特征進行了廣泛的統(tǒng)計顯著性分析,找到了其中 14 個對于人類眼球動作有顯著影響的特征,并根據(jù)特征特點,將其分為了上層特征和下層特征,展示在下表 1 當中。

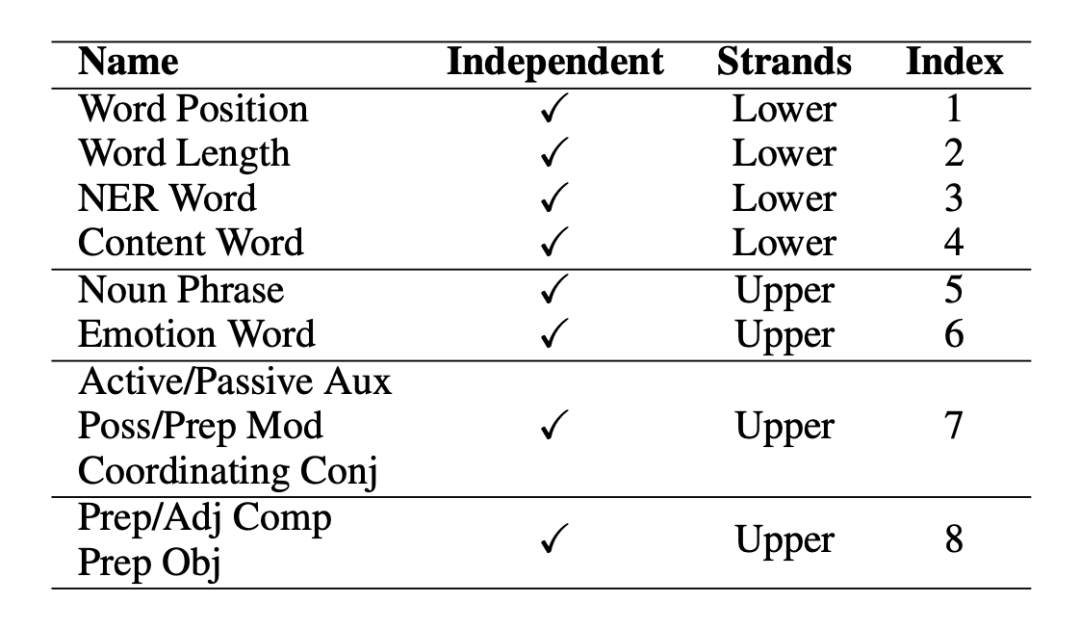

▲表1. 特征層級分類圖

3.2加權(quán)認知特征向量學(xué)習(xí)

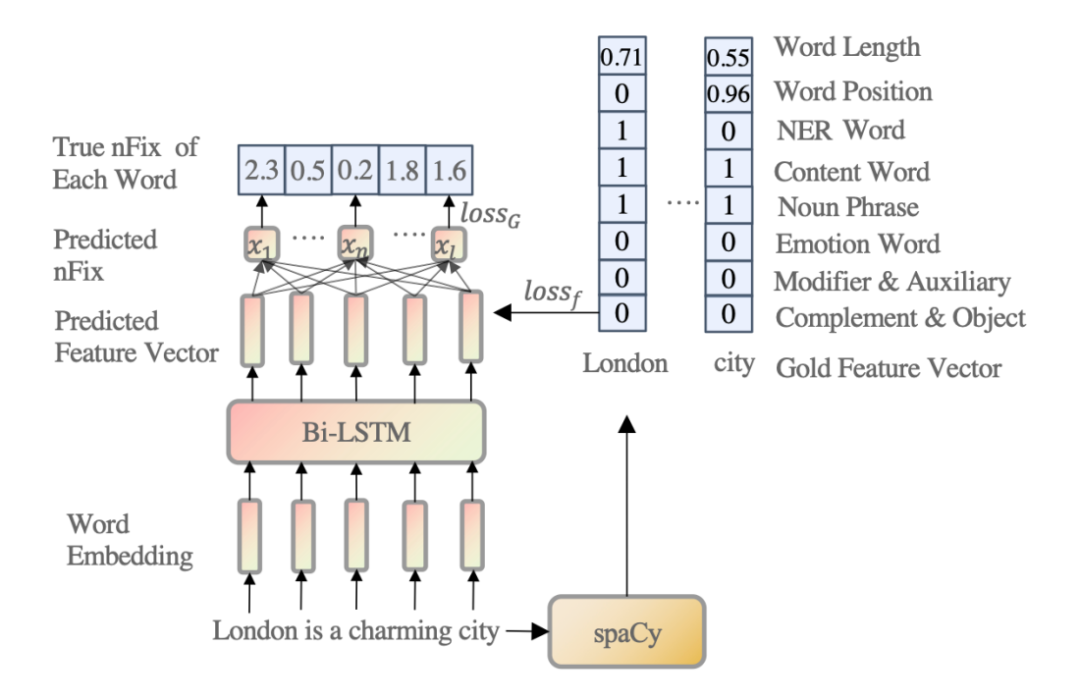

▲圖2. 加權(quán)認知特征向量學(xué)習(xí)模型

我們可以通過使用 spaCy 工具從文本中提取特征。然而,這些特征不應(yīng)該被賦予相同或隨機的權(quán)重,因為它們對適應(yīng)人類對句子的理解的貢獻是不同的。因此,如圖 2 所示,給定一個輸入句子,我們訓(xùn)練一個四層的 Bi-LSTM [3],將每個單詞嵌入到一個加權(quán)的八維認知特征向量。根據(jù)前述的心里語言學(xué)理論,我們認為認知特征可以解釋人類眼動信息的分配。因此,我們使用眼球追蹤數(shù)據(jù)(Zuco 1.0、Zuco 2.0 和 Geco)[4,5,6] 的眼球動作信息中的關(guān)注次數(shù) (nFix) 作為監(jiān)督信號來訓(xùn)練 Bi-LSTM 模型。

這部分的目的在實踐上實現(xiàn)前述所提到的理論,即人類的閱讀行為可以被特征解釋,同樣的,在模型層面上即意味著,模型要學(xué)會去利用語言特征的組合去逼近人類的閱讀行為。但是在本模型中,所需要的本不是最后對于眼球動作數(shù)據(jù)的逼近,而是需要其中通過眼球動作數(shù)據(jù)學(xué)來的特征向量。3.3 特征向量融入預(yù)訓(xùn)練語言模型

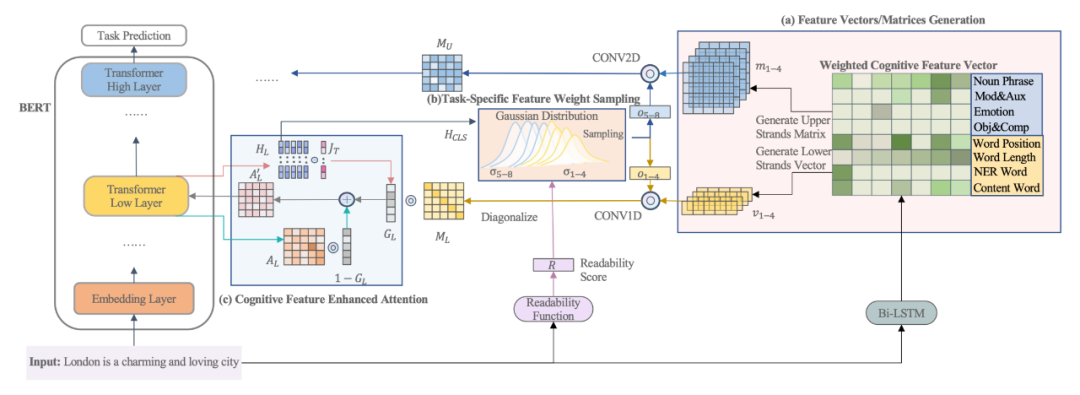

▲圖3. 特征向量融入預(yù)訓(xùn)練語言模型

如圖 3(a) 所示,對于每個有單詞的輸入句子,我們可以從 Bi-LSTM 模型中獲得其對應(yīng)的特征矩陣。對于每個底層特征(即詞長、詞位、NER 和內(nèi)容詞),我們可以從 Bi-LSTM 模型中為其生成一個初始特征向量,隨后這些特征向量將會被對角化放在一個矩陣的對角線上。

對于每個上層特征(即 NP chunk、情感詞、Mod&Aux 和 Obj&Comp),我們可以從 Bi-LSTM 模型中分別為其生成一個初始的特征矩陣。如果相鄰的詞組成了一個上層特征,它在特征矩陣中的值是由 Bi-LSTM 模型得到的相鄰詞的平均特征得分,而其余數(shù)值都填為 0。同時對于每一個特征,會有一個經(jīng)由高斯采樣出的權(quán)重每個特征進行放縮,用來提來該特征在該條數(shù)據(jù)或者任務(wù)當中的重要性。

經(jīng)由上述過程生成的特征矩陣經(jīng)過放縮后分別被卷積神經(jīng)網(wǎng)絡(luò)進行處理用于提取特征形成基于特征的注意力矩陣,同時為了保留原始的模型注意力信息和特征的注意力矩陣,本文添加了一個門控向量,該向量會分別與模型原本的注意力矩陣和特征注意力矩陣進行相乘并求和,求得一個原注意力矩陣和當前注意力矩陣的線性加權(quán)。

同時可以注意到,本模型當中,底層特征將會融入在預(yù)訓(xùn)練模型的底層,而高層特征則會融入在預(yù)訓(xùn)練模型的高層。

實驗及分析4.1數(shù)據(jù)集

本文在多個數(shù)據(jù)集上進行了大量的實驗,實驗結(jié)果包括了 GLUE Benchmark [7], CoNLL2000 Chunking [8] 以及 Eye-tracking [9] 和模型本身的一些分析。

4.2基線方法

1. BERT 不進行遷移,直接在目標領(lǐng)域上進行預(yù)測。RoBERTa 微調(diào)源領(lǐng)域模型的全部參數(shù)進行領(lǐng)域適應(yīng);

2. fMRI-EEG-BERT 一種認知數(shù)據(jù)增強的預(yù)訓(xùn)練語言模型,利用了核磁共振與腦電磁場數(shù)據(jù);

3. Eye-tracking BERT 一種認知數(shù)據(jù)增強的預(yù)訓(xùn)練語言模型,利用了眼球動作捕捉進行微調(diào)后再在下游任務(wù)上微調(diào);

4. CogBERT (Random) 本論文所提出的模型,但是特征分數(shù)并未經(jīng)由一階段進行生成,而是隨機生成的。

4.3 實驗結(jié)果與分析

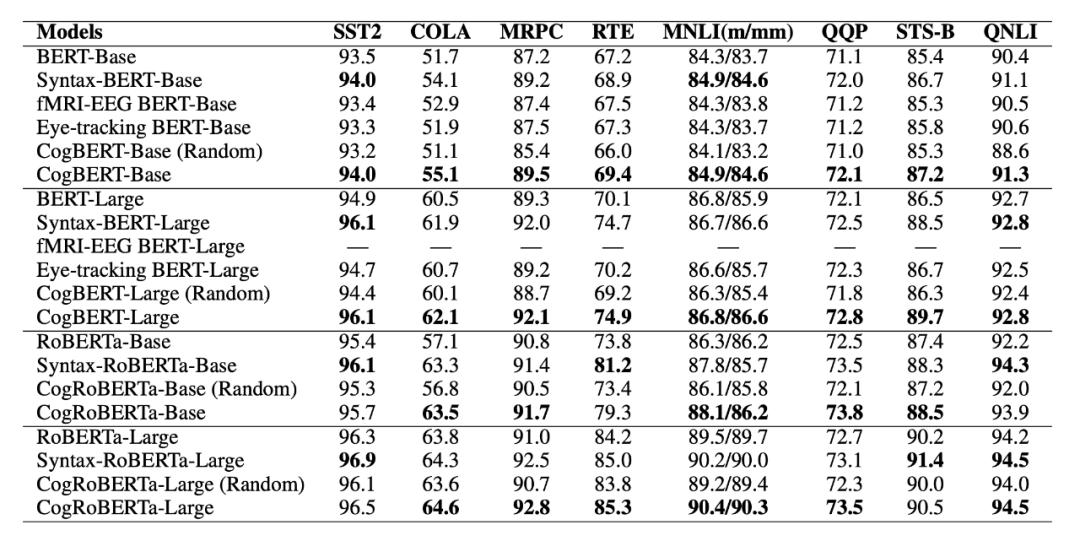

如表 2 所示,本文所提出的模型能夠在所有任務(wù)上超越模型的原本基線,同時超越大多數(shù)的認知增強的預(yù)訓(xùn)練語言模型,并能夠在大多數(shù)任務(wù)上達到或者超越經(jīng)由語法增強的預(yù)訓(xùn)練語言模型,體現(xiàn)了本文所提出模型的有效性。

▲表2. GLUE Benchmark實驗結(jié)果

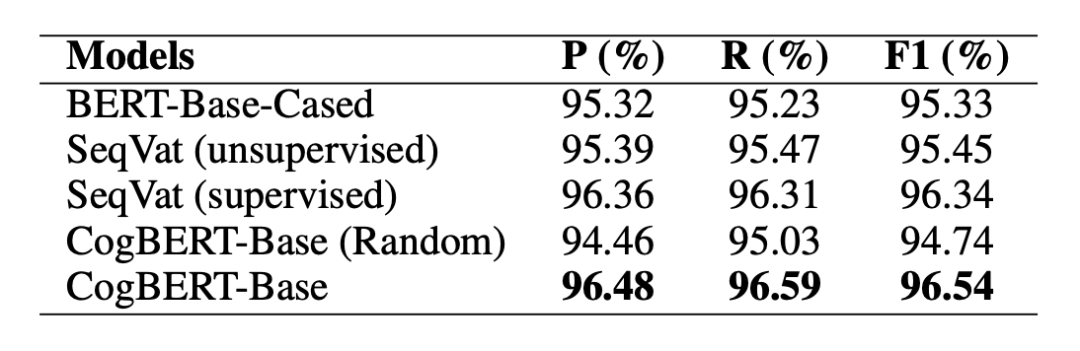

在 CoNLL 2000 Chunking 的數(shù)據(jù)集上,本文提出的模型可以超越 BERT 基線模型,同時本文提出的模型還可以超越先前專門用于序列標注而設(shè)計的模型。體現(xiàn)了認知增強的模型可以被用在廣泛的自然語言處理任務(wù)上。

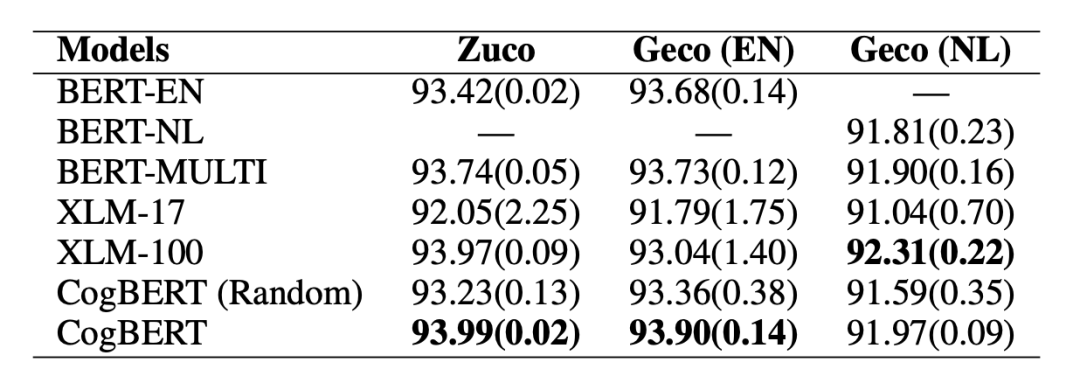

▲表3. CoNLL2000 Chunking實驗結(jié)果 同時,本文也在認知相關(guān)任務(wù)上進行了測試。在眼動數(shù)據(jù)預(yù)測的任務(wù)當中,本文所提出的模型可以在英語和荷蘭語的數(shù)據(jù)上超越相應(yīng)的基線模型。同時由于本文模型是基于 BERT 單語言版本,實驗證明我們的模型也能夠超越 BERT 多語言版本,同時能夠超越 XLM-17 這一在 17 種語言上預(yù)訓(xùn)練的模型,最終能以僅單語言的模型版本達到可比或者超越 XLM-100 這一在 100 種語言上預(yù)訓(xùn)練的模型。證明了融入認知數(shù)據(jù)對于認知任務(wù)具有強力的增益。

▲表4. Eye-tracking Prediction實驗結(jié)果

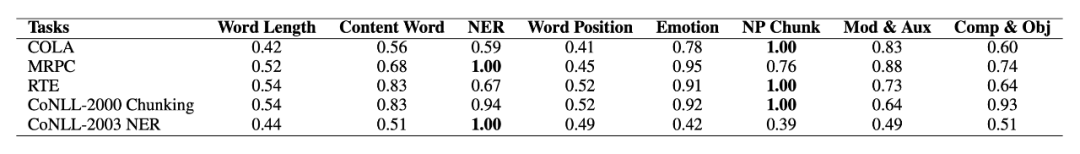

在對于模型本身的分析方面,首先展示在模型學(xué)習(xí)中不同任務(wù)里,不同特征所得到的權(quán)重。在 COLA(語法可接受性)上,本文的模型對語法相關(guān)特征給出了高權(quán)值。在 MRPC(轉(zhuǎn)述句識別)上,模型認為命名實體是最為重要的特征,即可能如果兩個句子并不在描述同一個實體,那么兩個句子大概率不是轉(zhuǎn)述句。在 RTE(文本蘊含)中,模型認為名詞短語是最為重要的特征,這可能意味著如果兩個句子具有類似的名詞短語結(jié)構(gòu),那么兩個句子具有較大的概率是蘊含關(guān)系。在 CoNLL 2000 Chunking 和 CoNLL 2003 NER 任務(wù)當中,模型可以很直觀的給出名詞短語和實體詞為最重要特征,符合了任務(wù)的設(shè)計。

▲表5. 特征權(quán)重分析實驗結(jié)果

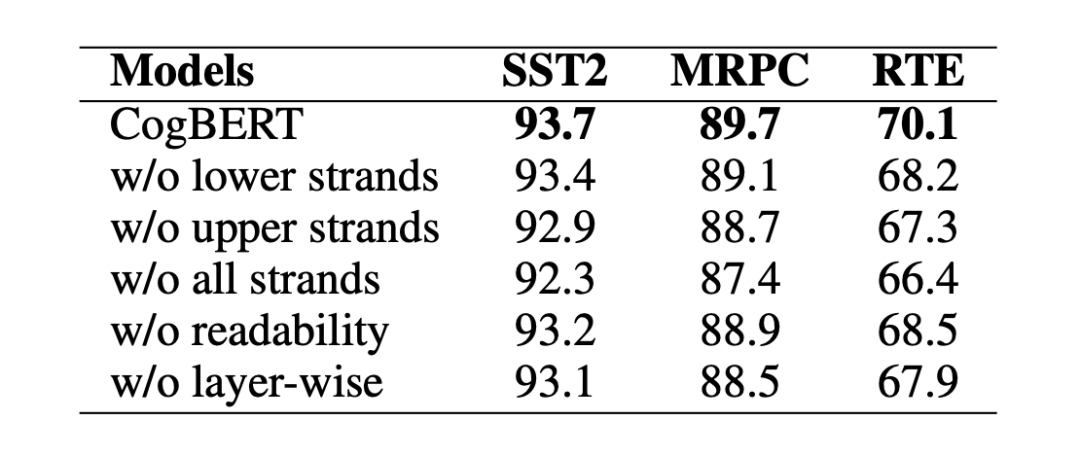

我們觀察到,替換下層或上層的認知特征會降低模型的性能,而去除所有層的認知特征會進一步影響模型的性能。我們還注意到,盡管可讀性對于我們的模型來說沒有認知特征那么重要,但去除它也會損害模型的性能。不分層的融入特征意味著我們將所有的特征整合到 BERT 的每一層,不分層的糟糕表現(xiàn)表明,以分層的方式整合特征是認知引導(dǎo)的 NLP 的一個有效方法。

▲表6. 消融實驗結(jié)果

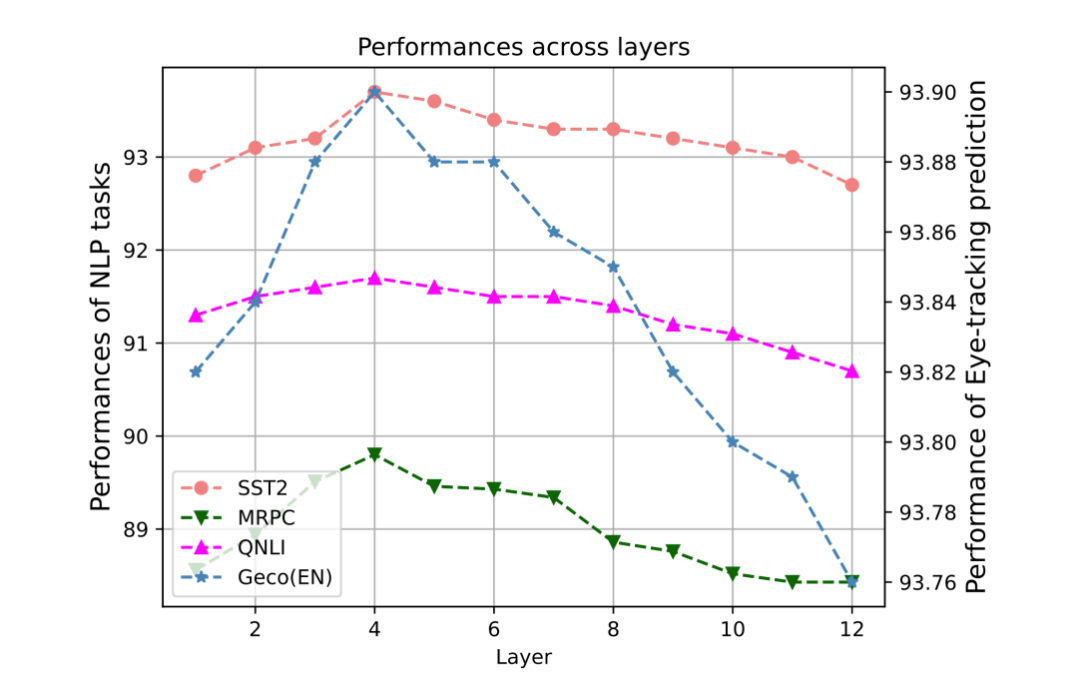

在本文中,由于下層特征融入到預(yù)訓(xùn)練模型的底層,而上層特征融入到高層當中,因此有必要去尋找合適的分層邊界。本文量化地討論了 BERT 的哪一層應(yīng)該是下層和上層認知特征的邊界,并對 SST2、MRPC、QNLI 和 STS-B 任務(wù)的開發(fā)集進行了比較實驗,并在圖中說明了結(jié)果。Y 軸是不同 NLP 任務(wù)的性能。X 軸是層數(shù)。例如,如果層數(shù)為 6,我們將下層的認知特征納入 BERT 的 1-6 層,將上層的認知特征納入其余層。

研究發(fā)現(xiàn),當層數(shù)邊界在 4 左右時,所有任務(wù)都達到了最佳性能,這意味著 BERT 的低層更適合納入下層認知特征,而當我們將上層認知特征納入更高的層數(shù)時,它們更有用。這些結(jié)果可以有效地指導(dǎo)未來認知強化預(yù)訓(xùn)練模型的研究,同時也進一步驗證了前人關(guān)于預(yù)訓(xùn)練模型的相關(guān)研究 [10]。

▲圖4. 任務(wù)表現(xiàn)與特征層數(shù)分析圖

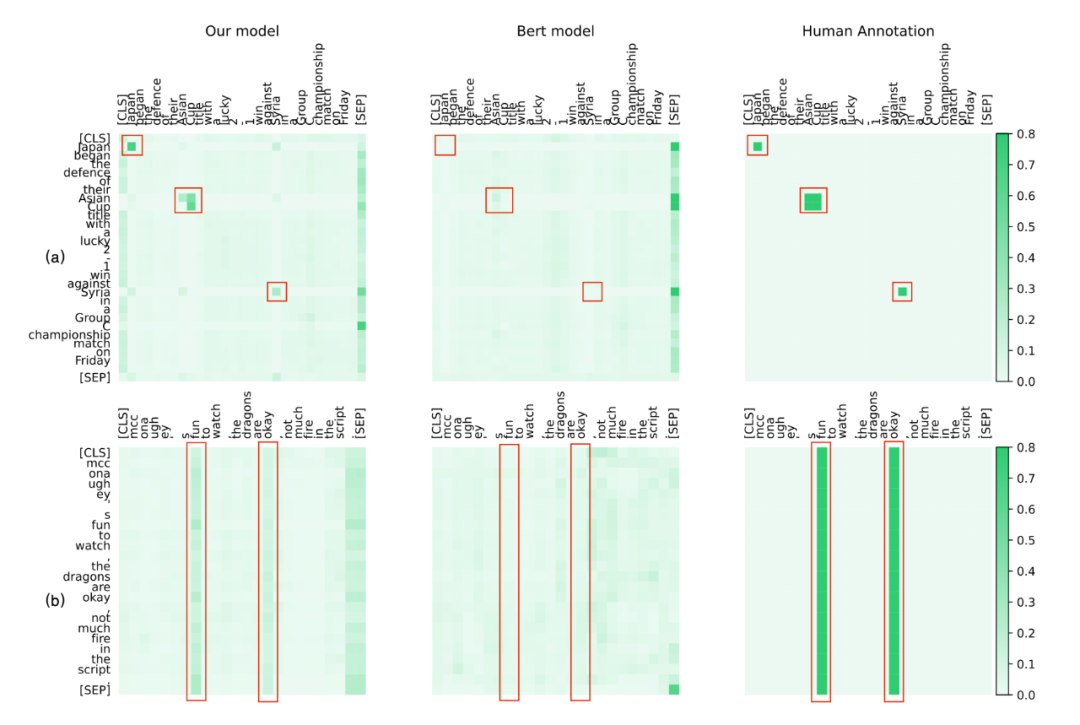

為了定性地分析我們方法的有效性,我們將 CogBERT 的注意力可視化,并與 BERT 和人類進行比較。我們從 SST2、NER 和 MRPC 任務(wù)中選擇案例。為了與人類的認知進行比較,給定一個特定的 NLP 任務(wù),我們要求四個注釋者在閱讀句子時突出他們的注意詞。對于 BERT 和 CogBERT,我們從預(yù)訓(xùn)練模型的較高層次中選擇注意力得分,這可以捕捉到任務(wù)的特定特征。SST2 和 NER 的注意力可視化圖。

圖 (a) 展示了 CoNLL-2003 NER 任務(wù)的注意力可視化,說明 CogBERT 像人類一樣對 NER 詞 "Asian Cup"、"Japan"和 "Syria"給予了更多的關(guān)注,而 BERT 對這些詞的關(guān)注很少。圖 (b) 說明了 SST2 任務(wù)的注意力可視化,顯示 CogBERT 捕獲了關(guān)鍵的情感詞`fun'和`okay',而這兩個詞從人類的判別行為來說對人類的判斷也很重要。

相比之下,BERT 未能關(guān)注這些詞。這些實驗結(jié)果表明,盡管預(yù)訓(xùn)練模型在眾多 NLP 任務(wù)中取得了可喜的改進,但它們離人類智能的水平還很遠。通過學(xué)習(xí)人類閱讀中的注意力機制,認知引導(dǎo)的預(yù)訓(xùn)練模型可以提供一種接近人類認知的有效方法。

▲圖5. 注意力可視化

結(jié)論

我們提出了 CogBERT,一個能夠有效地將認知信號納入預(yù)訓(xùn)練模型的框架。實驗結(jié)果表明,CogBERT 在多個 NLP 基準數(shù)據(jù)集上取得了超越基線的結(jié)果,同時模型表明證明對認知任務(wù)同樣有用。分析表明,CogBERT 可以自適應(yīng)地學(xué)習(xí)特定任務(wù)的認知特征權(quán)重,從而對認知數(shù)據(jù)在 NLP 任務(wù)中的工作方式做出精細的解釋。這項工作為學(xué)習(xí)認知增強的預(yù)訓(xùn)練模型提供了一個新的方法,廣泛闡述的實驗可以指導(dǎo)未來的研究。

審核編輯 :李倩 ·

-

語言模型

+關(guān)注

關(guān)注

0文章

557瀏覽量

10586 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1220瀏覽量

25184

原文標題:COLING'22 | CogBERT:腦認知指導(dǎo)的預(yù)訓(xùn)練語言模型

文章出處:【微信號:zenRRan,微信公眾號:深度學(xué)習(xí)自然語言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

用PaddleNLP為GPT-2模型制作FineWeb二進制預(yù)訓(xùn)練數(shù)據(jù)集

用PaddleNLP在4060單卡上實踐大模型預(yù)訓(xùn)練技術(shù)

騰訊公布大語言模型訓(xùn)練新專利

直播預(yù)約 |數(shù)據(jù)智能系列講座第4期:預(yù)訓(xùn)練的基礎(chǔ)模型下的持續(xù)學(xué)習(xí)

評論