概覽

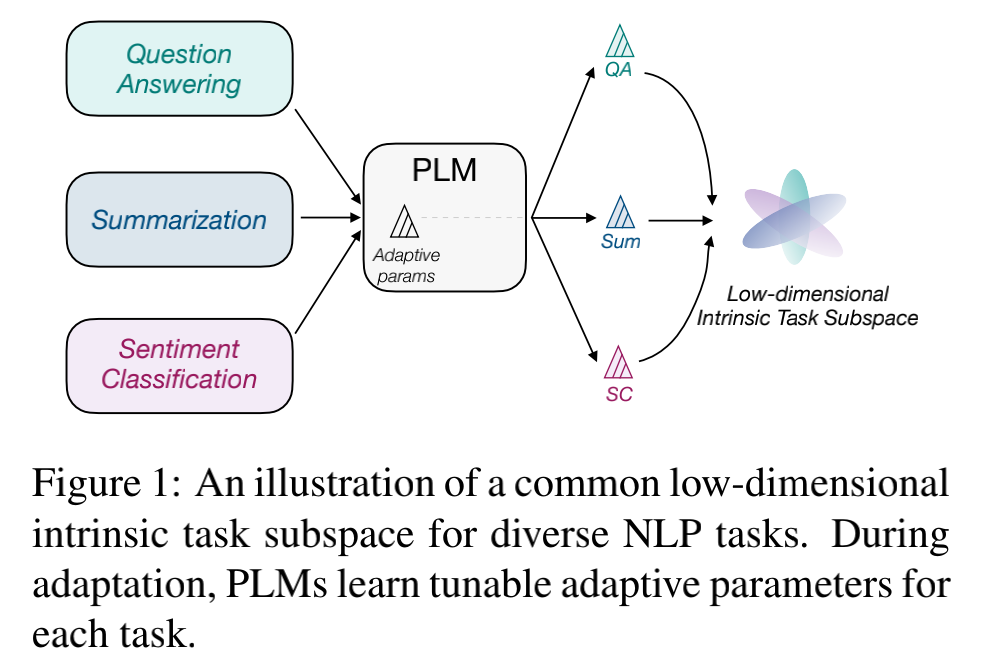

本文對(duì)任務(wù)低維本征子空間的探索是基于 prompt tuning, 而不是fine-tuning。原因是預(yù)訓(xùn)練模型的參數(shù)實(shí)在是太多了,很難找到這么多參數(shù)的低維本征子空間。作者基于之前的工作提出了一個(gè)基本的假設(shè):預(yù)訓(xùn)練模型在不同下游任務(wù)上學(xué)習(xí)的過(guò)程,可以被重新參數(shù)化(reparameterized)為在同一個(gè)低維本征子空間上的優(yōu)化過(guò)程。如下圖所示,模型在不同的任務(wù)上學(xué)習(xí)的參數(shù)雖然不同,但這些參數(shù)共享了同一個(gè)低維本征子空間。

基于這一假設(shè),作者提出了探索公共低維本征子空間的方法:intrinsic prompt tuning (IPT)。

IPT由兩個(gè)階段組成:

Multi-task Subspace Finding (MSF):尋找多個(gè)任務(wù)的公共子空間,這是一個(gè)低維的、更為本征的一個(gè)空間

Intrinsic Subspace Tuning (IST):在找到的公共本征子空間上進(jìn)行模型優(yōu)化

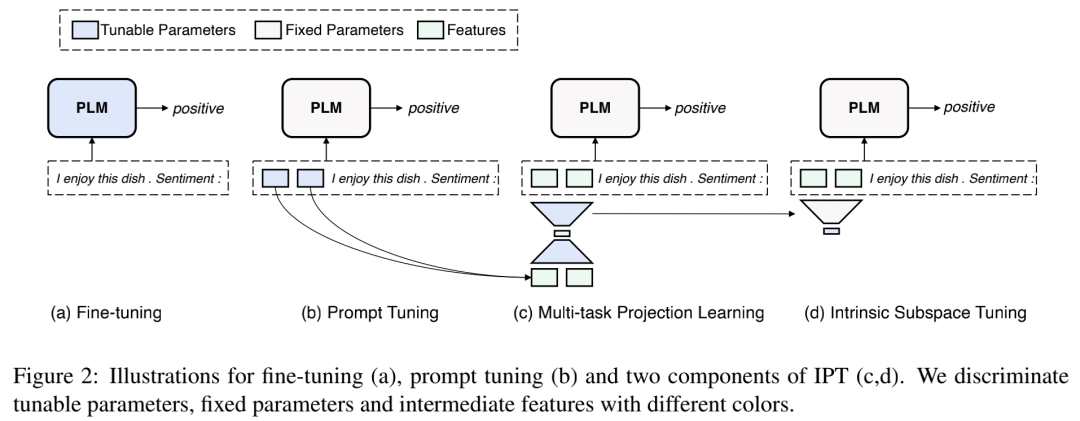

下圖展示了 IPT 與 fine-tuning 和 prompt tuning 的對(duì)比。

下面我們具體來(lái)了解一下IPT的兩個(gè)階段

IPT

作者使用intrinsic prompt tuning (IPT)來(lái)驗(yàn)證本文的基本假設(shè): 預(yù)訓(xùn)練模型對(duì)多個(gè)不同下游任務(wù)的學(xué)習(xí)可以被重新參數(shù)化為在同一個(gè)低維本征子空間上的優(yōu)化。

第一個(gè)階段是multi-task subspace finding (MSF)。

1. 尋找公共本征子空間(MSF)

MSF階段旨在通過(guò)對(duì)多個(gè)任務(wù)進(jìn)行學(xué)習(xí),來(lái)找到公共的低維本征子空間。如上圖所示,本質(zhì)上就是在學(xué)習(xí)一個(gè)自編碼器。

我們用 來(lái)代表自編碼器的Encoder部分(上圖中處于下方的梯形),用 來(lái)代表自編碼器的Decoder部分(上圖中處于上方的梯形),那么自編碼器會(huì)先用把Prompt參數(shù)映射為一個(gè)低維(維)的向量(向量所在的維空間就是我們想要的低維本征子空間),然后再用把該低維向量重新映射回原始的prompt空間,得到 這樣我們就可以使用 和 的距離來(lái)計(jì)算自編碼器的重建loss ,形式化表述就是:

另外,使用自編碼器來(lái)學(xué)習(xí)公共低維本征子空間的最終目的還是為了解決多個(gè)任務(wù),所以作者引入了面向任務(wù)的語(yǔ)言模型loss 來(lái)提供任務(wù)相關(guān)的監(jiān)督(例如圖中模型生成的結(jié)果"positive"和正確標(biāo)簽之間的交叉熵)。那么MSF階段最終的loss就是:

其中 代表 和 的參數(shù),這也是我們?cè)贛SF階段要學(xué)習(xí)的參數(shù)。

2. 本征子空間優(yōu)化(IST)

在MSF階段中,我們通過(guò)對(duì)多個(gè)任務(wù)的學(xué)習(xí)找到了維的公共本征子空間,然后就進(jìn)入了第二個(gè)階段IST。在這一階段中,我們想評(píng)價(jià)我們?cè)贛SF階段中找到的低維本征子空間是不是能夠很好的泛化到 (a) MSF階段訓(xùn)練過(guò)的任務(wù)的新數(shù)據(jù),以及 (b) MSF階段沒(méi)有訓(xùn)練過(guò)的任務(wù)。如果該低維本征子空間在這兩種情況下都有比較好的泛化性能的話,那么在我們?cè)谝欢ǔ潭壬暇统晒Φ卣业搅讼胍谋菊髯涌臻g。

在本階段中,如上圖 所示, 我們只保留自編碼器的Decoder部分并凍結(jié)它的參數(shù)。對(duì)于每個(gè)測(cè)試任務(wù),我們只微調(diào)本征子空間中的個(gè)自由參數(shù) , 會(huì)將解碼回原始的prompt空間中來(lái)計(jì)算loss:

實(shí)驗(yàn)

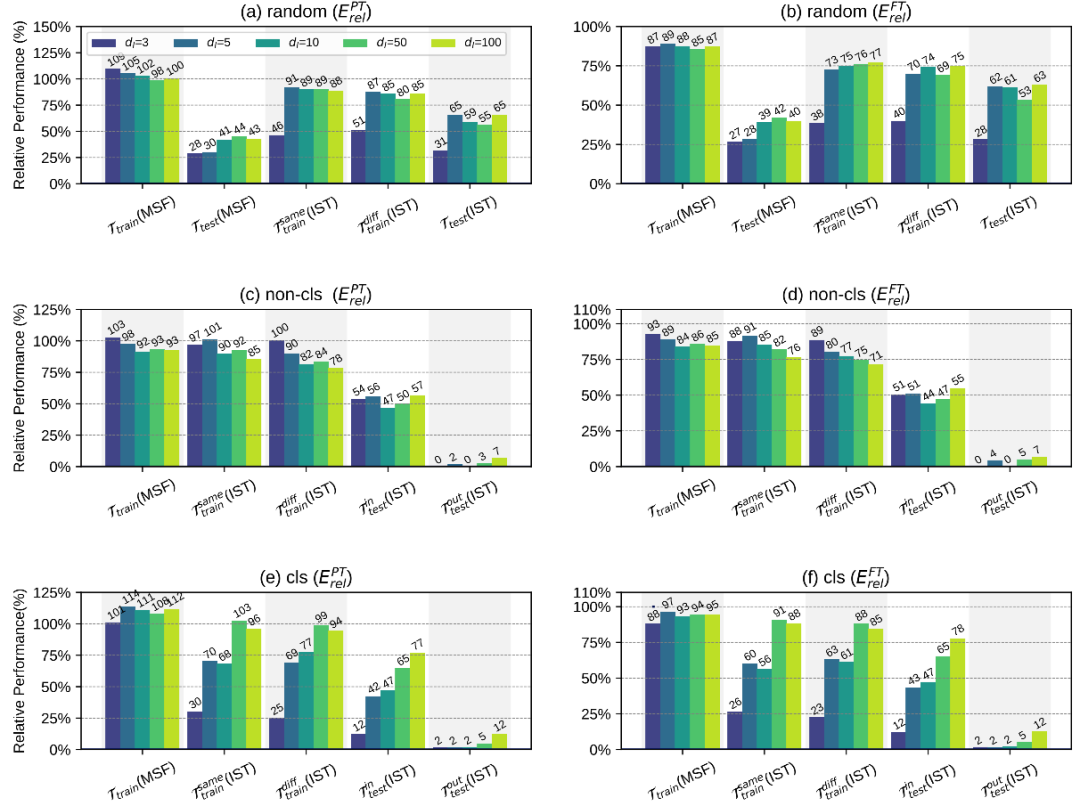

作者使用了120個(gè)few-shot任務(wù)來(lái)進(jìn)行實(shí)驗(yàn),并進(jìn)行了三種不同的訓(xùn)練-測(cè)試任務(wù)劃分

random: 隨機(jī)選擇100個(gè)任務(wù)作為訓(xùn)練任務(wù),其余20個(gè)任務(wù)作為測(cè)試任務(wù)

non-cls: 隨機(jī)選擇非分類(lèi)任務(wù)中的35作為訓(xùn)練任務(wù),其余所有任務(wù)作為測(cè)試任務(wù)

cls: 隨機(jī)選擇分類(lèi)任務(wù)中的35個(gè)作為訓(xùn)練任務(wù),其余所有任務(wù)作為測(cè)試任務(wù)

同時(shí),對(duì)每一種任務(wù)劃分,作者進(jìn)行了5種不同的實(shí)驗(yàn)

: 在MSF階段,直接使用學(xué)習(xí)到的低維本征子空間來(lái)評(píng)估訓(xùn)練任務(wù)在訓(xùn)練數(shù)據(jù)上的性能

: 在MSF階段,直接使用學(xué)習(xí)到的低維本征子空間來(lái)評(píng)估測(cè)試任務(wù)(0-shot)的泛化性能

: 在IST階段,微調(diào)學(xué)習(xí)到的低維本征子空間來(lái)評(píng)估訓(xùn)練任務(wù)在訓(xùn)練數(shù)據(jù)上的性能

: 在IST階段,微調(diào)學(xué)習(xí)到的低維本征子空間來(lái)評(píng)估訓(xùn)練任務(wù)在新數(shù)據(jù)上的泛化性能

: 在IST階段,微調(diào)學(xué)習(xí)到的低維本征子空間來(lái)評(píng)估測(cè)試任務(wù)的泛化性能

整體的實(shí)驗(yàn)結(jié)果如上圖所示,作者通過(guò)分析不同實(shí)驗(yàn)的結(jié)果,得出了一些比較重要的結(jié)論:

在random劃分中,僅僅微調(diào)低維本征子空間中的5個(gè)自由參數(shù),就可以分別獲得full prompt tuning 87%(訓(xùn)練過(guò)的任務(wù),不同訓(xùn)練數(shù)據(jù))以及65%(未訓(xùn)練過(guò)的任務(wù))的性能,這證明我們?cè)贛SF階段中找到的低維本征子空間是比較有效的。但從另一個(gè)方面來(lái)講,使用低維本征子空間無(wú)法獲得和full prompt tuning相當(dāng)?shù)男阅埽晕覀儾荒苤苯拥贸鲱A(yù)訓(xùn)練模型對(duì)多個(gè)任務(wù)的學(xué)習(xí)可以被重新參數(shù)化為在完全相同的子空間中的優(yōu)化的結(jié)論。

訓(xùn)練-測(cè)試任務(wù)的劃分會(huì)對(duì)結(jié)果有很大的影響。比如在cls劃分中,訓(xùn)練時(shí)找到的本征子空間可以在分類(lèi)的測(cè)試任務(wù)上有比較合理的表現(xiàn),但在非分類(lèi)的測(cè)試任務(wù)上表現(xiàn)很差。

隨著MSF階段中訓(xùn)練任務(wù)數(shù)量的增加,找到的本征子空間的泛化能力會(huì)有所提高。這反映了增加MSF階段中訓(xùn)練任務(wù)的覆蓋范圍和多樣性可以幫助IPT找到更通用的本征子空間。

結(jié)論

本文設(shè)計(jì)了IPT框架來(lái)驗(yàn)證提出的假設(shè): 預(yù)訓(xùn)練模型對(duì)多個(gè)不同下游任務(wù)的學(xué)習(xí)可以被重新參數(shù)化為在同一個(gè)低維本征子空間上的優(yōu)化。詳盡的實(shí)驗(yàn)為假設(shè)提供了一定的積極證據(jù),也幫助大家對(duì)如何更高效地使用預(yù)訓(xùn)練語(yǔ)言模型有了更好的了解。

思考

雖然文章中的實(shí)驗(yàn)結(jié)果不能直接驗(yàn)證“預(yù)訓(xùn)練模型對(duì)多個(gè)任務(wù)的學(xué)習(xí)可以被重新參數(shù)化為在完全相同的子空間中的優(yōu)化”這一假設(shè)是完全正確的,但起碼它證明了各種任務(wù)重參數(shù)化后的低維子空間是有比較大的交集的,而且我們可以通過(guò)MSF來(lái)找到這個(gè)交集。

審核編輯:郭婷

-

編碼器

+關(guān)注

關(guān)注

45文章

3651瀏覽量

134777

原文標(biāo)題:Prompt Learning | 五個(gè)參數(shù)解決下游任務(wù) fine-tuning

文章出處:【微信號(hào):zenRRan,微信公眾號(hào):深度學(xué)習(xí)自然語(yǔ)言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

什么是大模型、大模型是怎么訓(xùn)練出來(lái)的及大模型作用

直播預(yù)約 |數(shù)據(jù)智能系列講座第4期:預(yù)訓(xùn)練的基礎(chǔ)模型下的持續(xù)學(xué)習(xí)

如何更高效地使用預(yù)訓(xùn)練語(yǔ)言模型

如何更高效地使用預(yù)訓(xùn)練語(yǔ)言模型

評(píng)論