“強基固本,行穩(wěn)致遠(yuǎn)”,科學(xué)研究離不開理論基礎(chǔ),人工智能學(xué)科更是需要數(shù)學(xué)、物理、神經(jīng)科學(xué)等基礎(chǔ)學(xué)科提供有力支撐,為了緊扣時代脈搏,我們推出“強基固本”專欄,講解AI領(lǐng)域的基礎(chǔ)知識,為你的科研學(xué)習(xí)提供助力,夯實理論基礎(chǔ),提升原始創(chuàng)新能力,敬請關(guān)注。

作者:Zhihong Deng

地址:https://www.zhihu.com/people/Zhi-Hong.Deng

最近看了 Michael Bronstein 教授寫的一篇博客,分析得挺好的,簡單分享一下。 深度學(xué)習(xí),特別是 CV 領(lǐng)域的模型,往往有數(shù)十上百層,與此相比,在圖“深度學(xué)習(xí)”中(大部分工作都 ≤5 層,談不上深,所以加個引號吧),大部分模型架構(gòu)都是淺層的,設(shè)計深度模型到底有沒有用呢? 現(xiàn)有的一些工作告訴我們,訓(xùn)練深度圖神經(jīng)網(wǎng)絡(luò)是很難的,除了深度學(xué)習(xí)的傳統(tǒng)問題(梯度消失和過擬合)之外,針對圖本身的特性,還需要克服另外兩個問題:

過渡平滑:使用多個卷積層后,結(jié)點特征趨向于收斂到相同或相似的向量,這使它們變得難以區(qū)分[1][2][3]。

過度壓縮:在使用多層圖網(wǎng)絡(luò)后,鄰居數(shù)量指數(shù)級增長,要將大量的結(jié)點信息壓縮到一個結(jié)點上就會存在過度壓縮的問題,這也稱為瓶頸現(xiàn)象[4]。

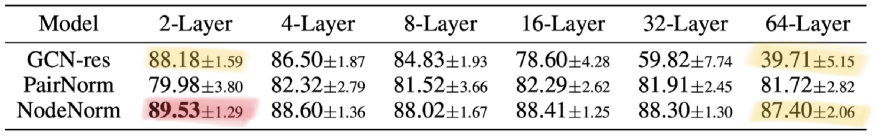

上表展示了幾種嘗試解決深度問題的方法,包括殘差連接和兩種歸一化技術(shù)。可以看出隨著網(wǎng)絡(luò)層級加深,GCN-res 效果急劇變差。PairNorm 相對穩(wěn)定,但降低了性能。NodeNorm 效果最佳,但它的最佳效果是在兩層圖網(wǎng)絡(luò)時取得的。這個實驗告訴我們,要將深度圖網(wǎng)絡(luò)帶來的提升和訓(xùn)練它所需要的技巧分開討論是很難的。 為什么深度模型在 CV 領(lǐng)域這么好使,但用在圖網(wǎng)絡(luò)上就這么難呢?作者給出了幾個觀點:

01圖的結(jié)構(gòu)

現(xiàn)有工作告訴我們,在分子圖、點云和網(wǎng)格(圖像也可以看作是一種網(wǎng)格狀的圖)上使用深度圖網(wǎng)絡(luò)是有效的,這些圖跟我們常用以評估圖神經(jīng)網(wǎng)絡(luò)效果的引用網(wǎng)絡(luò)(例如:Cora、PubMed 或 CoauthorCS)等有何不同呢?下圖就給出一個很清晰的示例:

我們常用的引用網(wǎng)絡(luò)這一類圖往往屬于直徑較小的小世界網(wǎng)絡(luò),簡單點講就是圖中任意兩個結(jié)點的距離都比較近,幾跳就能到達,使用更深的網(wǎng)絡(luò)架構(gòu)并不會擴大感受野;相比之下,在網(wǎng)格(比如圖像)這一類圖中,增加層數(shù)能讓感受野成倍增長,從而更好地捕捉到上下文。使用不同顏色標(biāo)注不同層數(shù)所能到達的結(jié)點,可以看到,同樣是12個結(jié)點的圖,左圖僅用兩種顏色就夠了,右圖則用了6種顏色。

02短程與遠(yuǎn)程信息

根據(jù)問題的特性,有的問題則可以通過短距離的信息解決,比如社交網(wǎng)絡(luò)中,預(yù)測往往僅依賴于結(jié)點的局部鄰居;有的問題可能需要更長距離的信息,比如分子圖種分子的化學(xué)性質(zhì)可能取決于另一側(cè)的原子組合,這就需要深度圖網(wǎng)絡(luò)來組合這些遠(yuǎn)程信息。但是隨著層數(shù)增多,如果圖結(jié)構(gòu)會引起結(jié)點感受野的指數(shù)級增長,那么瓶頸現(xiàn)象就會阻止遠(yuǎn)程信息的有效傳播:

上圖就展示了一個例子,在使用深度圖網(wǎng)絡(luò)時,我們需要把多個結(jié)點的信息整合到一個結(jié)點中并迭代此過程,所以傳播過程中可能會丟失不少有用的信息,也就解釋了為什么深度模型難以提高性能。

03理論局限

我們在使用深度神經(jīng)網(wǎng)絡(luò)的時候,往往可以做一些可視化分析,比如 CNN 可以將每一層學(xué)到的特征做一個可視化:

淺層神經(jīng)元學(xué)到是比較簡單的特征,比如某些紋理、線條;深層神經(jīng)元學(xué)到的則是更復(fù)雜的一些特征,比如眼睛,鼻子等等。但是,圖神經(jīng)網(wǎng)絡(luò)里也能這么分析嗎?多層的圖網(wǎng)絡(luò)也能學(xué)到逐漸復(fù)雜的性質(zhì)嗎?我們目前尚不清楚哪些圖形性質(zhì)可以用淺層圖網(wǎng)絡(luò)學(xué)到,哪些需要更深的網(wǎng)絡(luò),哪些是根本無法計算的。

04深度 vs. 豐富度

在 CV 中,因為所有圖像都是非常規(guī)則的網(wǎng)格結(jié)構(gòu),所以結(jié)構(gòu)就變得不再重要的,但在圖深度學(xué)習(xí)中,結(jié)構(gòu)是很重要的,如何設(shè)計更復(fù)雜的,可以處理高階信息(比如:各種motif)的消息傳遞機制仍有待探索。目前大家主要關(guān)注的還是1-跳卷積,但我們可以設(shè)計出多跳的filter,比如 SIGN 這篇論文。有趣的是,這跟 CV 領(lǐng)域的發(fā)展歷程恰恰相反,CV 領(lǐng)域早期的淺層模型一般使用的是大型 filter(比如:11×11),后來逐漸發(fā)展到使用小型 filter(比如 :3×3)的深度模型。這里作者想表達的“豐富度”的意思應(yīng)該是指,我們是不是也能像 CV 里 GoogLeNet 那樣使用Inception模塊,同時使用1-跳卷積,2-跳卷積等多種 filter(對應(yīng) CV 里的 3×3、5×5 等等),這其實也會間接地幫助到信息的有效傳播。

05評估

最后但或許也很重要的一點就是評估方法,一些常見的基準(zhǔn)數(shù)據(jù)集和方法未必能準(zhǔn)確評估圖神經(jīng)網(wǎng)絡(luò)的效果,我們觀察到深度圖網(wǎng)絡(luò)在一些數(shù)據(jù)集上性能隨深度下降,或許僅僅是因為數(shù)據(jù)集太小,發(fā)生了過擬合。斯坦福新推出的 Open Graph Benchmark 可以解決部分問題,它提高了大規(guī)模的圖數(shù)據(jù),并給定了訓(xùn)練和測試數(shù)據(jù)的劃分方式。 [1] More precisely, over-smoothing makes node feature vector collapse into a subspace, see K. Oono and T. Suzuki,Graph neural networks exponentially loose expressive power for node classification(2019). arXiv:1905.10947, which provides asymptotic analysis using dynamic systems formalist. [2] Q. Li, Z. Han, X.-M. Wu,Deeper insights into graph convolutional networks for semi-supervised learning(2019). Proc. AAAI. Draws the analogy between the GCN model and Laplacian smoothing and points to the over-smoothing phenomenon. [3] H. Nt and T. Maehara,Revisiting graph neural networks: All we have is low-pass filters(2019). arXiv:1905.09550. Uses spectral analysis on graphs to answer when GCNs perform well. [4] U. Alon and E. Yahav,On the bottleneck of graph neural networks and its practical implications(2020). arXiv:2006.05205. Identified the over-squashing phenomenon in graph neural networks, which is similar to one observed in sequential recurrent models.

聲明:部分內(nèi)容來源于網(wǎng)絡(luò),僅供讀者學(xué)術(shù)交流之目的。文章版權(quán)歸原作者所有。如有不妥,請聯(lián)系刪除。

責(zé)任編輯:PSY

原文標(biāo)題:我們真的需要深度圖神經(jīng)網(wǎng)絡(luò)嗎?

文章出處:【微信公眾號:新機器視覺】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

-

網(wǎng)絡(luò)

+關(guān)注

關(guān)注

14文章

7676瀏覽量

89870 -

CV

+關(guān)注

關(guān)注

0文章

53瀏覽量

16983 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5531瀏覽量

122083

原文標(biāo)題:我們真的需要深度圖神經(jīng)網(wǎng)絡(luò)嗎?

文章出處:【微信號:vision263com,微信公眾號:新機器視覺】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

評論