迄今為止,深度神經網絡(DNN)已被證明對于包括圖像和音頻分類在內的廣泛應用非常有前途。但是,它們的性能在很大程度上取決于用于訓練它們的數據量,而且大型數據集并不總是很容易獲得。

如果DNN沒有經過充分的訓練,他們將更容易對數據進行錯誤分類。這使他們容易受到特定類型的網絡攻擊,稱為對抗攻擊。在對抗性攻擊中,攻擊者創建旨在欺騙DNN(即對抗性數據)的真實數據的副本,將其欺騙為錯誤分類的數據,從而損害其功能。

近年來,計算機科學家和開發人員提出了各種工具,可以通過檢測原始數據和對抗數據之間的差異來保護深度神經體系結構免受這些攻擊。但是,到目前為止,這些解決方案均未證明具有普遍效力。

武漢大學和武漢軟件工程職業學院的研究人員最近推出了一個平臺,該平臺可以通過計算復制圖像的容易程度來評估其抵制DNN的能力,從而評估圖像對對抗攻擊的魯棒性。這個名為FoolChecker的新平臺在Elsevier的Neurocomputing期刊上發表的一篇論文中進行了介紹。

研究人員在論文中寫道:“我們的論文提出了一個稱為FoolChecker的平臺,用于從圖像本身而非DNN模型的角度評估圖像對抗攻擊的魯棒性。”“我們定義了原始示例與對抗示例之間的最小感知距離,以量化對抗對抗攻擊的魯棒性。”

FoolChecker是量化圖像抵御攻擊性魯棒性的首批方法之一。在仿真中,這項技術取得了顯著成果,在相對較短的時間內完成了計算。

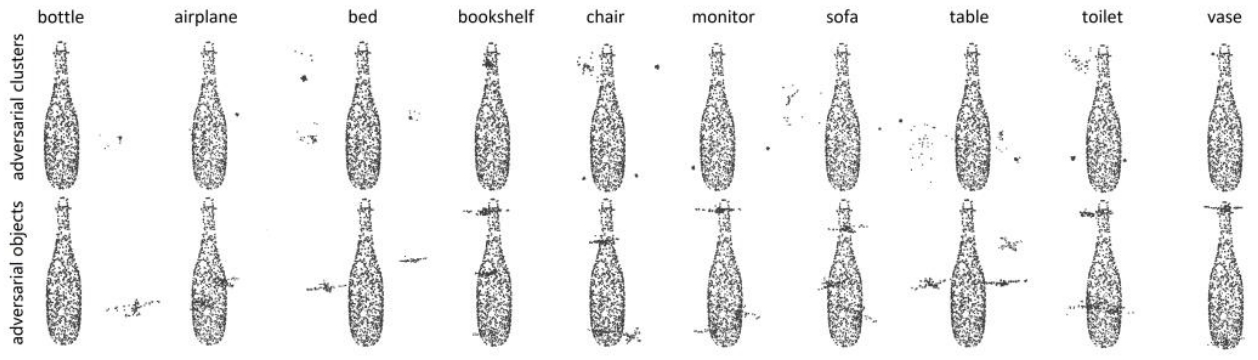

在開發平臺時,研究人員比較了許多指標以量化原始圖像與對抗圖像之間的距離。證明最有效的度量標準是原始樣本與對抗樣本之間的攝動靈敏度距離(PSD)。

FoolChecker的工作原理是計算成功欺騙DNN分類器所需的最小PSD。盡管需要手動計算,但研究人員開發了一種方法,該方法結合了稱為差分進化(DE)和貪婪算法的技術,貪婪算法是一種直觀的體系結構,通常用于解決優化問題。

研究人員寫道:“首先,將差分演化應用于產生具有高擾動優先級的候選擾動單位。”“然后,貪心算法嘗試將當前具有最高擾動優先級的像素添加到擾動單元中,直到欺騙DNN模型為止。最后,計算出擾動單元的感知距離,作為評估圖像抵抗對抗攻擊的魯棒性的指標。 ”

研究人員通過一系列測試對FoolChecker進行了評估,發現它可以有效地計算某些圖像在被多個DNN處理后對對抗攻擊的魯棒性。他們的研究提供了證據,表明DNN模型的對抗性脆弱性也可能是由于外部因素(即,與模型性能無關)造成的,例如它正在處理的圖像的特征。

換句話說,該團隊發現,圖像本身在易于修改的程度方面可能會有所不同,從而會誘使DNN誤分類數據。將來,他們開發的平臺可用于評估饋送到DNN的數據的魯棒性,這可能會阻止攻擊者創建對抗性數據并因此而發動攻擊。

-

神經網絡

+關注

關注

42文章

4789瀏覽量

101867 -

計算機科學

+關注

關注

1文章

144瀏覽量

11484 -

數據集

+關注

關注

4文章

1217瀏覽量

25101

發布評論請先 登錄

相關推薦

CMOS傳感器的圖像處理能力

我做THS8200出來的圖像會有干擾,想加一個低通濾波器來濾RGB信號

東軟新一代檢查檢驗互認信息平臺落地見效

圖像傳感器的探測能力與哪些因素有關

cdn為什么能防止ddos攻擊呢?

生成對抗網絡(GANs)的原理與應用案例

DDoS有哪些攻擊手段?

高防CDN是如何應對DDoS和CC攻擊的

電子對抗系統有哪些

逆變器絕緣抵抗和殘余電流不同,發生較大故障

評論