大家好,之前有文章說到信號處理,說到卷積,那今天咱們來聊一聊卷積。

關(guān)于卷積,之前在大學(xué)時候?qū)W信號與系統(tǒng)的時候就感覺理解的不是很深刻,我于是心想一定要把卷積完全搞明白。經(jīng)過一段時間的思考之后,有一些很有趣的體會和大家分享。據(jù)說卷積這種運算式物理學(xué)家發(fā)明的,在實際中用得不亦樂乎,而數(shù)學(xué)家卻一直沒有把運算的意義徹底搞明白。仔細品以下,還是有那么點滋味的。

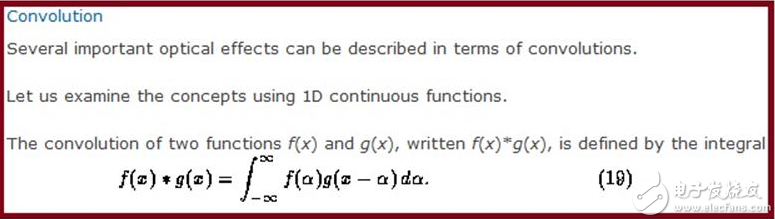

下面先看一下劍橋大學(xué)的教科書對卷積的定義:

我們都知道這個公式,但是它有什么物理意義呢,平時我們用卷積做過很多事情,信號處理時,輸出函數(shù)是輸入函數(shù)和系統(tǒng)函數(shù)的卷積,在圖像處理時,兩組幅分辨率不同的圖卷積之后得到的互相平滑的圖像可以方便處理。卷積甚至可以用在考試作弊中,為了讓照片同時像兩個人,只要把兩人的圖像卷積處理即可,這就是一種平滑的過程,可是我們怎么才能真正把公式和實際建立起一種聯(lián)系呢,也就是說,我們能不能從生活中找到一種很方便且具體的例子來表達公式的物理意義呢?

那下面咱們就來看一看詳細的卷積本質(zhì)以及物理意義的介紹

1 來源

卷積其實就是為沖擊函數(shù)誕生的。“沖擊函數(shù)”是狄拉克為了解決一些瞬間作用的物理現(xiàn)象而提出的符號。古人曰:“說一堆大道理不如舉一個好例子”,沖量這一物理現(xiàn)象很能說明“沖擊函數(shù)”。在t時間內(nèi)對一物體作用F的力,倘若作用時間t很小,作用力F很大,但讓Ft的乘積不變,即沖量不變。于是在用t做橫坐標(biāo)、F做縱坐標(biāo)的坐標(biāo)系中,就如同一個面積不變的長方形,底邊被擠的窄窄的,高度被擠的高高的,在數(shù)學(xué)中它可以被擠到無限高,但即使它無限瘦、無限高、但它仍然保持面積不變(它沒有被擠沒!),為了證實它的存在,可以對它進行積分,積分就是求面積嘛!于是“卷積”這個數(shù)學(xué)怪物就這樣誕生了。

卷積是“信號與系統(tǒng)”中論述系統(tǒng)對輸入信號的響應(yīng)而提出的。

2 意義

信號處理是將一個信號空間映射到另外一個信號空間,通常就是時域到頻域,(還有z域,s域),信號的能量就是函數(shù)的范數(shù)(信號與函數(shù)等同的概念),大家都知道有個Paserval定理就是說映射前后范數(shù)不變,在數(shù)學(xué)中就叫保范映射,實際上信號處理中的變換基本都是保范映射,只要Paserval定理成立就是保范映射(就是能量不變的映射)。

信號處理中如何出現(xiàn)卷積的。假設(shè)B是一個系統(tǒng),其t時刻的輸入為x(t),輸出為y(t),系統(tǒng)的響應(yīng)函數(shù)為h(t),按理說,輸出與輸入的關(guān)系應(yīng)該為

Y(t)=h(t)x(t),

然而,實際的情況是,系統(tǒng)的輸出不僅與系統(tǒng)在t時刻的響應(yīng)有關(guān),還與它在t時刻之前的響應(yīng)有關(guān),不過系統(tǒng)有個衰減過程,所以t1( y(s)=∫x(t)h(s-t)dt, 離散情況下就是級數(shù)了。 3 計算 卷積是一種積分運算,它可以用來描述線性時不變系統(tǒng)的輸入和輸出的關(guān)系:即輸出可以通過輸入和一個表征系統(tǒng)特性的函數(shù)(沖激響應(yīng)函數(shù))進行卷積運算得到。(以下用$符號表示從負無窮大到正無窮大的積分) 1)一維卷積: y(t)=g(k)*x(k)=$g(k)x(t-k) 先把函數(shù)x(k)相對于原點反折,然后向右移動距離t,然后兩個函數(shù)相乘再積分,就得到了在t處的輸出。對每個t值重復(fù)上述過程,就得到了輸出曲線。 2)二維卷積: h(x,y)=f(u,v)*g(u,v)=$$f(u,v)g(x-u,y-v) 先將g(u,v)繞其原點旋轉(zhuǎn)180度,然后平移其原點,u軸上像上平移x, v軸上像上平移y。然后兩個函數(shù)相乘積分,得到一個點處的輸出。 4 幽默笑話——談卷積的物理意義 有一個七品縣令,喜歡用打板子來懲戒那些市井無賴,而且有個慣例:如果沒犯大罪,只打一板,釋放回家,以示愛民如子。 有一個無賴,想出人頭地卻沒啥指望,心想:既然揚不了善名,出惡名也成啊。怎么出惡名?炒作唄!怎么炒作?找名人呀!他自然想到了他的行政長官——縣令。 無賴于是光天化日之下,站在縣衙門前撒了一泡尿,后果是可想而知地,自然被請進大堂挨了一板子,然后昂首挺胸回家,躺了一天,嘿!身上啥事也沒有!第二天如法炮制,全然不顧行政長管的仁慈和衙門的體面,第三天、第四天......每天去縣衙門領(lǐng)一個板子回來,還喜氣洋洋地,堅持一個月之久!這無賴的名氣已經(jīng)和衙門口的臭氣一樣,傳遍八方了! 縣令大人噤著鼻子,呆呆地盯著案子上的驚堂木,擰著眉頭思考一個問題:這三十個大板子怎么不好使捏?......想當(dāng)初,本老爺金榜題名時,數(shù)學(xué)可是得了滿分,今天好歹要解決這個問題: ——人(系統(tǒng)!)挨板子(脈沖!)以后,會有什么表現(xiàn)(輸出!)? ——費話,疼唄! ——我問的是:會有什么表現(xiàn)? ——看疼到啥程度。像這無賴的體格,每天挨一個板子啥事都不會有,連哼一下都不可能,你也看到他那得意洋洋的嘴臉了(輸出0);如果一次連揍他十個板子,他可能會皺皺眉頭,咬咬牙,硬挺著不哼(輸出1);揍到二十個板子,他會疼得臉部扭曲,象豬似地哼哼(輸出3);揍到三十個板子,他可能會象驢似地嚎叫,一把鼻涕一把淚地求你饒他一命(輸出5);揍到四十個板子,他會大小便失禁,勉強哼出聲來(輸出1);揍到五十個板子,他連哼一下都不可能(輸出0)——死啦! 縣令鋪開坐標(biāo)紙,以打板子的個數(shù)作為X軸,以哼哼的程度(輸出)為Y軸,繪制了一條曲線: ——嗚呼呀!這曲線像一座高山,弄不懂。為啥那個無賴連挨了三十天大板卻不喊繞命呀? —— 呵呵,你打一次的時間間隔(Δτ=24小時)太長了,所以那個無賴承受的痛苦程度一天一利索,沒有疊加,始終是一個常數(shù);如果縮短打板子的時間間隔(建議Δτ=0.5秒),那他的痛苦程度可就迅速疊加了;等到這無賴挨三十個大板(t=30)時,痛苦程度達到了他能喊叫的極限,會收到最好的懲戒效果,再多打就顯示不出您的仁慈了。 ——還是不太明白,時間間隔小,為什么痛苦程度會疊加呢? ——這與人(線性時不變系統(tǒng))對板子(脈沖、輸入、激勵)的響應(yīng)有關(guān)。什么是響應(yīng)?人挨一個板子后,疼痛的感覺會在一天(假設(shè)的,因人而異)內(nèi)慢慢消失(衰減),而不可能突然消失。這樣一來,只要打板子的時間間隔很小,每一個板子引起的疼痛都來不及完全衰減,都會對最終的痛苦程度有不同的貢獻: t個大板子造成的痛苦程度=Σ(第τ個大板子引起的痛苦*衰減系數(shù)) [衰減系數(shù)是(t-τ)的函數(shù),仔細品味] 數(shù)學(xué)表達為:y(t)=∫T(τ)H(t-τ) ——拿人的痛苦來說卷積的事,太殘忍了。除了人以外,其他事物也符合這條規(guī)律嗎? ——呵呵,縣令大人畢竟仁慈。其實除人之外,很多事情也遵循此道。好好想一想,鐵絲為什么彎曲一次不折,快速彎曲多次卻會輕易折掉呢? ——恩,一時還弄不清,容本官慢慢想來——但有一點是明確地——來人啊,將撒尿的那個無賴抓來,狠打40大板! 也可以這樣理解:T(τ)即第τ個板子,H(t-τ)就是第τ個板子引起的痛苦到t時刻的痛苦程度,所有板子加起來就是∫T(τ)H(t-τ) 4 卷積在具體學(xué)科中的應(yīng)用 圖像處理:用一個模板和一幅圖像進行卷積,對于圖像上的一個點,讓模板的原點和該點重合,然后模板上的點和圖像上對應(yīng)的點相乘,然后各點的積相加,就得到了該點的卷積值。對圖像上的每個點都這樣處理。由于大多數(shù)模板都是對稱的,所以模板不旋轉(zhuǎn)。卷積是一種積分運算,用來求兩個曲線重疊區(qū)域面積。可以看作加權(quán)求和,可以用來消除噪聲、特征增強。 把一個點的像素值用它周圍的點的像素值的加權(quán)平均代替。 卷積是一種線性運算,圖像處理中常見的mask運算都是卷積,廣泛應(yīng)用于圖像濾波。 卷積在數(shù)據(jù)處理中用來平滑,卷積有平滑效應(yīng)和展寬效應(yīng). 電路學(xué):卷積法的原理是根據(jù)線性定常電路的性質(zhì)(齊次性、疊加性、時不變性、積分性等),借助電路的單位沖激響應(yīng)h(t),求解系統(tǒng)響應(yīng)的工具,系統(tǒng)的激勵一般都可以表示為沖擊函數(shù)和激勵的函數(shù)的卷積,而卷積為高等數(shù)學(xué)中的積分概念。概念中沖擊函數(shù)的幅度是由每個矩形微元的面積決定的。 卷積關(guān)系最重要的一種情況,就是在信號與線性系統(tǒng)或數(shù)字信號處理中的卷積定理。利用該定理,可以將時間域或空間域中的卷積運算等價為頻率域的相乘運算,從而利用FFT等快速算法,實現(xiàn)有效的計算,節(jié)省運算代價。 信號處理: 1)卷積實質(zhì)上是對信號進行濾波; 2)卷積就是用沖擊函數(shù)表示激勵函數(shù),然后根據(jù)沖擊響應(yīng)求解系統(tǒng)的零狀態(tài)響應(yīng)。 卷積是求和(積分)。對于線性時不變的系統(tǒng),輸入可以分解成很多強度不同的沖激的和的形式(對于時域就是積分),那么輸出也就是這些沖激分別作用到系統(tǒng)產(chǎn)生的響應(yīng)的和(或者積分)。所以卷積的物理意義就是表達了時域中輸入,系統(tǒng)沖激響應(yīng),以及輸出之間的關(guān)系。 信號角度:卷積代表了線性系統(tǒng)對輸入信號的響應(yīng)方式,其輸出就等于系統(tǒng)沖擊函數(shù)和信號輸入的卷積,只有符合疊加原理的系統(tǒng),才有系統(tǒng)沖擊函數(shù)的概念,從而卷積成為系統(tǒng)對輸入在數(shù)學(xué)上運算的必然形式,沖擊函數(shù)實際上是該問題的格林函數(shù)解。點激勵源作為強加激勵,求解某個線性問題的解,得到的格林函數(shù)即是系統(tǒng)沖擊響應(yīng).所以在線性系統(tǒng)中,系統(tǒng)沖擊響應(yīng)與卷積存在著必然的聯(lián)系。 數(shù)學(xué):來說卷積就是定義兩個函數(shù)的一種乘法,或者是一種反映兩個序列或函數(shù)之間的運算方法。對離散序列來說就是兩個多項式的乘法。物理意義就是沖激響應(yīng)的線性疊加,所謂沖激響應(yīng)可以看作是一個函數(shù),另一個函數(shù)按沖激信號正交展開。 在現(xiàn)實中:卷積代表的是將一種信號搬移到另一頻率中,比如調(diào)制,這是頻率卷。 物理:卷積可代表某種系統(tǒng)對某個物理量或輸入的調(diào)制或污染。 在現(xiàn)實中:卷積代表的是將一種信號搬移到另一頻率中,比如調(diào)制,這是頻率卷。 形象比喻:卷積我覺得就象一把銼刀,它主要是把一些非光滑的函數(shù)或算子光滑化。 信號處理的任務(wù)就是尋找和信號集合對應(yīng)的一個集合,然后在另外一個集合中分析信號,F(xiàn)ourier變換就是一種,它建立了時域中每個信號函數(shù)與頻域中的每個頻譜函數(shù)的一一對應(yīng)關(guān)系,這是元素之間的對應(yīng)。那么運算之間的對應(yīng)呢,在時域的加法對應(yīng)頻域中的加法,這就是FT線性性的體現(xiàn);那么時域的乘法對應(yīng)什么呢,最后得到的那個表達式我們就把它叫卷積,就是對應(yīng)的頻域的卷積。 簡單來說,卷積是一種重疊關(guān)系,也就是說,所得到的結(jié)果反映了兩個卷積函數(shù)的重疊部分。所以,用一個已知頻段的函數(shù)卷積另一個頻段很寬的函數(shù),也就是對后者進行了濾波,后者跟前者重疊的頻段才能很好地通過這個filter. 5 卷積與多項式 信號處理中的一個重要運算是卷積.初學(xué)卷積的時候,往往是在連續(xù)的情形,兩個函數(shù)f(x),g(x)的卷積,是∫f(u)g(x-u)du。當(dāng)然,證明卷積的一些性質(zhì)并不困難,比如交換,結(jié)合等等,但是對于卷積運算的來處,初學(xué)者就不甚了了。 其實,從離散的情形看卷積,或許更加清楚,對于兩個序列f[n],g[n],一般可以將其卷積定義為s[x]= ∑f[k]g[x-k]。 卷積的一個典型例子,其實就是初中就學(xué)過的多項式相乘的運算。 比如(x*x+3*x+2)(2*x+5)一般計算順序如下: (x*x+3*x+2)(2*x+5) = (x*x+3*x+2)*2*x+(x*x+3*x+2)*5 = 2*x*x*x+3*2*x*x+2*2*x+ 5*x*x+3*5*x+10 然后合并同類項的系數(shù), 2x*x*x 3*2+1*5x*x 2*2+3*5x 2*5 2*x*x*x+11*x*x+19*x+10 實際上,從線性代數(shù)可以知道,多項式構(gòu)成一個向量空間,其基底可選為{1,x,x*x,x*x*x,...}如此,則任何多項式均可與無窮維空間中的一個坐標(biāo)向量相對應(yīng),如,(x*x+3*x+2)對應(yīng)于(1 3 2),(2*x+5)對應(yīng)于(2,5)。線性空間中沒有定義兩個向量間的卷積運算,而只有加法、數(shù)乘兩種運算,而實際上,多項式的乘法,就無法在線性空間中說明,可見線性空間的理論多么局限了。但如果按照我們上面對向量卷積的定義來處理坐標(biāo)向量,(1 3 2)*(2 5)則有(1 3 2)*(2 5)=(2 11 19 10)。 回到多項式的表示上來,(x*x+3*x+2)(2*x+5)=2*x*x*x+11*x*x+19*x+10,結(jié)果跟我們用傳統(tǒng)辦法得到的是完全一樣的.換句話,多項式相乘,相當(dāng)于系數(shù)向量的卷積.其實道理也很簡單,卷積運算實際上是分別求 x*x*x ,x*x,x,1的系數(shù),也就是說,他把加法和求和雜合在一起做了。(傳統(tǒng)的辦法是先做乘法,然后在合并同類項的時候才作加法)以x*x的系數(shù)為例,得到x*x,或者是用x*x乘5,或者是用3x乘2x,也就是 2 3 1 _ 2 5 6+5=11 其實,這正是向量的內(nèi)積.如此則,卷積運算,可以看作是一串內(nèi)積運算.既然是一串內(nèi)積運算,則我們可以試圖用矩陣表示上述過程。 [ 2 3 1 0 0 0] [ 0 2 3 1 0 0]==A [ 0 0 2 3 1 0] [ 0 0 0 2 3 1] [0 0 2 5 0 0]' == x b= Ax=[ 2 11 19 10]' 采用行的觀點看Ax,則b的每行都是一個內(nèi)積。A的每一行都是序列[23 1]的一個移動位置。顯然,在這個特定的背景下,我們知道,卷積滿足交換,結(jié)合等定律,因為,眾所周知的,多項式的乘法滿足交換律,結(jié)合律.在一般情形下,其實也成立. 在這里,我們發(fā)現(xiàn)多項式,除了構(gòu)成特定的線性空間外,基與基之間還存在某種特殊的聯(lián)系,正是這種聯(lián)系,給予多項式空間以特殊的性質(zhì). 在學(xué)向量的時候,一般都會舉這個例子,甲有三個蘋果,5個橘子,乙有5個蘋果,三個橘子,則共有幾個蘋果,橘子。老師反復(fù)告誡,橘子就是橘子,蘋果就是蘋果,可不能混在一起。所以有(3,5)+(5,3)=(8,8).是的,橘子和蘋果無論怎么加,都不會出什么問題的,但是,如果考慮橘子乘橘子,或者橘子乘蘋果,這問題就不大容易說清了。 又如復(fù)數(shù),如果僅僅定義復(fù)數(shù)為數(shù)對(a,b),僅僅在線性空間的層面看待C2,那就未免太簡單了。實際上,只要加上一條(a,b)*(c,d)=(ac-bd,ad+bc)。則情況馬上改觀,復(fù)變函數(shù)的內(nèi)容多么豐富多彩,是眾所周知的。另外,回想信號處理里面的一條基本定理,頻率域的乘積,相當(dāng)于時域或空域信號的卷積.恰好和這里的情形完全對等.這后面存在什么樣的隱態(tài)聯(lián)系,需要繼續(xù)參詳. 從這里看,高等的卷積運算其實不過是一種初等的運算的抽象而已.中學(xué)學(xué)過的數(shù)學(xué)里面,其實還蘊涵著許多高深的內(nèi)容(比如交換代數(shù))。溫故而知新,斯言不謬.其實這道理一點也不復(fù)雜,人類繁衍了多少萬年了,但過去n多年,人們只知道男女媾精,乃能繁衍后代。精子,卵子的發(fā)現(xiàn),生殖機制的研究,也就是最近多少年的事情。 孔子說,道在人倫日用中,看來我們應(yīng)該多用審視的眼光看待周圍,乃至自身,才能知其然,而知其所以然。 參考資料: http://hi.baidu.com/a__g/blog/item/10873722cab331ac4723e8f7.html http://blog.chinaunix.net/u2/76475/showart_1682636.html

-

離散卷積

+關(guān)注

關(guān)注

0文章

2瀏覽量

1431

發(fā)布評論請先 登錄

相關(guān)推薦

簡談卷積

簡談卷積

評論