本文為新欄目——將門好聲音第5期。

作者是來自將門計算機視覺社群的群友、中科院計算技術(shù)研究所VIPL課題組博士生——李勇。本文中,他將為大家介紹中科院計算所VIPL組的CVPR2019新作:一種基于視頻流的自監(jiān)督特征表達方法,通過利用巧妙的自監(jiān)督約束信號,得到提純的面部動作特征用于微表情識別。

如果你也想與廣大群友分享自己的研究工作、文章觀點、出坑經(jīng)驗,隨時與群主小姐姐聯(lián)系!只要內(nèi)容合適,我“門”送你頭條出道!

著名心理學(xué)家Paul Ekman和研究伙伴W.V.Friesen,通過對臉部肌肉動作與對應(yīng)表情關(guān)系的研究,于1976年創(chuàng)制了“面部運動編碼系統(tǒng)”,而利用微表情的“讀心術(shù)”正是基于這一研究體系。由于該領(lǐng)域有限的數(shù)據(jù)集和高昂的標注成本,有監(jiān)督學(xué)習(xí)的方法往往會導(dǎo)致模型過擬合。本文中,將為大家介紹中科院計算所VIPL組的CVPR2019新作:作者提出了一種基于視頻流的自監(jiān)督特征表達方法,通過利用巧妙的自監(jiān)督約束信號,得到提純的面部動作特征用于微表情識別。

李勇,中國科學(xué)院計算技術(shù)研究所視覺信息處理與課題組博士研究生,導(dǎo)師為常虹副研究員以及山世光研究員,研究方向為開放場景下的人臉表情分析。在攻讀博士學(xué)位期間,李勇在 CVPR, TIP 等會議及期刊上發(fā)表過多篇學(xué)術(shù)論文,其已發(fā)表的會議文章均被錄取為口頭報告。此外,李勇獲得ACM Multimedia 2017 親屬關(guān)系識別國際競賽冠軍。

論文信息:

Yong Li, Jiabei Zeng, Shiguang Shan, Xilin Chen. “Self-Supervised Representation Learning From Videos for Facial Action Unit Detection”, CVPR 2019, pp. 10924-10933, Long Beach, California, USA, June 16-20, 2019.

論文鏈接:

http://openaccess.thecvf.com/content_CVPR_2019/papers/Li_Self-Supervised_Representation_Learning_From_Videos_for_Facial_Action_Unit_Detection_CVPR_2019_paper.pdf

一、研究背景

面部運動編碼系統(tǒng)(FACS,F(xiàn)acial Action Coding System)從人臉解剖學(xué)的角度,定義了44個面部動作單元(Action Unit,簡稱AU)用于描述人臉局部區(qū)域的肌肉運動。

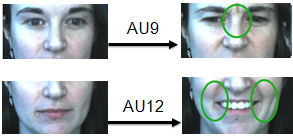

圖1. 面部動作單元示例

如圖1所示,AU9表示“皺鼻”,AU12表示“嘴角拉伸”。各種動作單元之間可以自由組合,對應(yīng)不同的表情。如“AU4(降低眉毛)+AU5(上眼瞼上升)+AU24(嘴唇相互按壓)”這一組合對應(yīng)“憤怒”這一情緒狀態(tài)。

面部動作單元能夠客觀、精確、細粒度地描述人臉表情。然而昂貴的標注代價在很大程度上限制了AU識別問題的研究進展,其原因在于不同的AU分布在人臉的不同區(qū)域,表現(xiàn)為不同強度、不同尺度的細微變化。具體來說,為一分鐘的人臉視頻標注一個AU,需要耗費一名AU標注專家30分鐘。目前學(xué)術(shù)界已發(fā)布的AU數(shù)據(jù)集只包含了有限的采集對象,以及有限的人臉圖像(如2017年CMU發(fā)布的GFT數(shù)據(jù)集有96個人,約35,000張人臉圖像)。

當前已有的工作多采用人臉區(qū)域分塊、注意力機制等方法學(xué)習(xí)人臉局部區(qū)域的AU特征,這類方法在訓(xùn)練階段需要利用精確標注的AU標簽,由于目前業(yè)界發(fā)布的AU數(shù)據(jù)集人數(shù)及圖像總量不足,采用監(jiān)督學(xué)習(xí)方法訓(xùn)練得到的模型往往呈現(xiàn)出在特定數(shù)據(jù)集上的過擬合現(xiàn)象,這無疑限制了其實際使用效果。

我們提出了一種能夠在不依賴AU標簽的前提下,從人臉視頻數(shù)據(jù)中自動學(xué)習(xí)AU表征的方法(Twin-Cycle Autoencoder,簡稱TCAE)。TCAE用于后續(xù)的AU識別任務(wù)時,只需要利用訓(xùn)練數(shù)據(jù)訓(xùn)練一個分類器即可,顯著減少了所需的訓(xùn)練數(shù)據(jù),并提升了模型的泛化能力。

二、方法概述

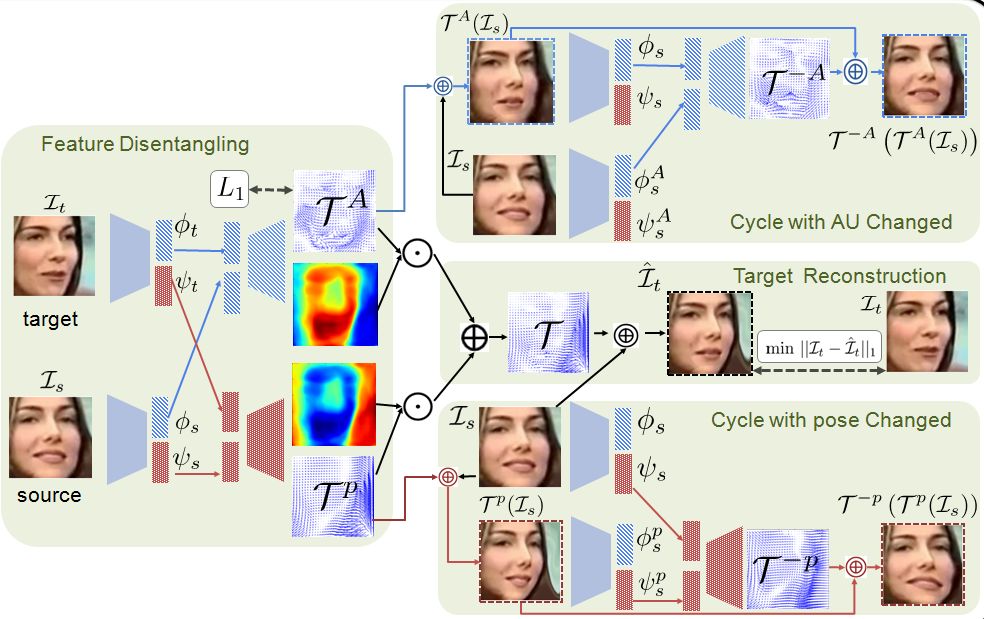

如圖2所示,該方法以兩幀人臉圖像(源圖,目標圖)之間的運動信息為監(jiān)督信號,驅(qū)使模型提取出用于解碼運動信息的圖像特征。這個方法的理念在于,模型只有感知并理解了人臉圖像中各個面部動作單元的狀態(tài)(AU是否激活),才能夠?qū)⒃磮D的面部動作轉(zhuǎn)換為目標圖像的面部動作。

圖2. TCAE 設(shè)計圖

考慮到兩幀人臉圖像之間的運動信息包含了AU以及頭部姿態(tài)的運動分量,TCAE通過利用巧妙的自監(jiān)督約束信號,使得模型能夠分離出AU變化引起的運動分量,以及頭部姿態(tài)變化引起的運動分量,從而得到提純的AU特征。與其他監(jiān)督方法,TCAE可以利用大量的無標注人臉視頻,這類視頻是海量的。與半監(jiān)督或者弱監(jiān)督方法相比, TCAE采用了自監(jiān)督信號進行模型訓(xùn)練,避免了對數(shù)據(jù)或者標簽的分布做出任何假設(shè)。

三、算法詳解

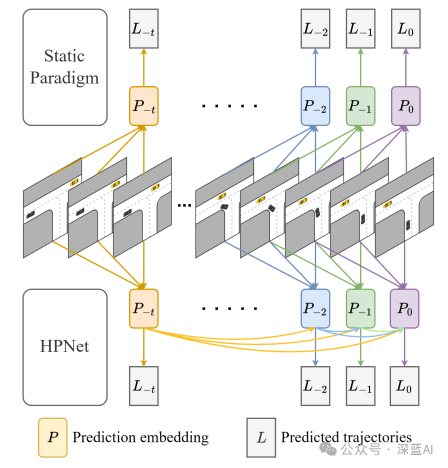

如圖3所示,TCAE包含四個階段,分別是特征解耦,圖像重建,AU循環(huán)變換,以及姿態(tài)(pose)循環(huán)變換。

圖3. TCAE的四個階段示意圖,四個階段分別是特征解耦,圖像重建,AU循環(huán)變換,以及姿態(tài)循環(huán)變換。

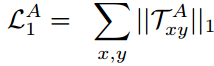

給定兩張人臉圖像,TCAE在特征解耦階段使用編碼器得到每張圖像的AU特征以及姿態(tài)特征,隨后,兩幀圖像的AU特征被送入AU解碼器,用于解碼出AU位移場;兩幀圖像的姿態(tài)特征被送入姿態(tài)解碼器,用于解碼出姿態(tài)位移場。考慮到AU的變化是稀疏的,且AU位移場的數(shù)值與姿態(tài)位移場相比更小,我們?yōu)锳U位移場添加了L1約束:

在目標圖重建階段,TCAE通過線性組合AU位移場和pose位移場,得到源圖和目標圖之間的整體位移場,進行圖像重建:

在AU循環(huán)變換階段,僅變換了AU的人臉圖像被重新變換到源圖,由此我們獲得一個像素層面的一致性約束:

另外,對于變換了AU的人臉圖像,其AU特征應(yīng)該接近目標圖像的AU特征,其姿態(tài)特征應(yīng)該和源圖的姿態(tài)特征一致,由此我們獲得一個特征層面的一致性約束:

同理,在pose循環(huán)變化階段,我們同樣可以獲得類似的像素及特征層面的一致性約束:

四、實驗結(jié)果

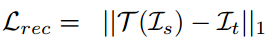

多個數(shù)據(jù)集上的實驗證明,TCAE能夠成功提取出人臉圖像的AU及姿態(tài)特征。如圖4所示,給定兩張人臉圖像(源圖,目標圖),TCAE能夠僅僅改變源圖的AU或者頭部姿態(tài)。可視化的AU位移場呈現(xiàn)出運動方向的多樣性。

圖4. 可視化結(jié)果在AU識別任務(wù)上,TCAE取得了與監(jiān)督方法可比的性能。

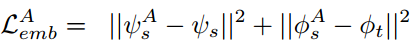

表1及表2的結(jié)果表明,TCAE明顯優(yōu)于其他自監(jiān)督方法。在GFT數(shù)據(jù)集(該數(shù)據(jù)集存在大范圍的頭部姿態(tài)變化)上,TCAE的性能優(yōu)于其他監(jiān)督方法。

表1. BP4D及DISFA數(shù)據(jù)集評測結(jié)果

(評測標準:F1 值 (%))

表2. GFT及EmotioNet數(shù)據(jù)集評測結(jié)果(評測標準:F1 值 (%) )

五、總結(jié)與展望

TCAE通過自監(jiān)督的方法學(xué)習(xí)到了魯棒的AU表征,實驗證明該AU表征是魯棒的,適用于AU分類任務(wù)的。可視化結(jié)果表明,TCAE具有潛在的人臉表情編輯價值。另外,TCAE在訓(xùn)練階段使用了大量的無標簽數(shù)據(jù)(近6000人,約10,000,000張圖像),由此可見使用自監(jiān)督方法訓(xùn)練模型時數(shù)據(jù)利用的效率需要進一步提高,這一點在BERT的實驗分析中也得到了印證:

Good results on pre-training is 》1,000x to 100,000 more expensive than supervised training.

-

計算機視覺

+關(guān)注

關(guān)注

8文章

1700瀏覽量

46108 -

視頻數(shù)據(jù)

+關(guān)注

關(guān)注

0文章

18瀏覽量

10992 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1209瀏覽量

24810

原文標題:將門好聲音 | CVPR2019 “識面知心”——基于自監(jiān)督學(xué)習(xí)的微表情特征表達

文章出處:【微信號:thejiangmen,微信公眾號:將門創(chuàng)投】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

一種基于因果路徑的層次圖卷積注意力網(wǎng)絡(luò)

一種提升無人機小物體跟蹤精度的方法

一種創(chuàng)新的動態(tài)軌跡預(yù)測方法

特征工程實施步驟

華芯微電子取得一種過流保護電路專利

一種無透鏡成像的新方法

神經(jīng)網(wǎng)絡(luò)如何用無監(jiān)督算法訓(xùn)練

rup是一種什么模型

人臉檢測的五種方法各有什么特征和優(yōu)缺點

接觸器的自鎖接線方法

介紹一種用于絕對定量的微腔式數(shù)字PCR微流控芯片

CVPR2019新作:一種基于視頻流的自監(jiān)督特征表達方法

CVPR2019新作:一種基于視頻流的自監(jiān)督特征表達方法

評論